模型训练类似于AI系统开发的基础阶段(例如重新开发一个ChatGPT)。它涉及从零开始构建AI模型的过程,类似于将种子培育成长成一棵大树。这个过程非常重要,因为它奠定了AI的基本能力和智能。主要适用的场景包括:1. 新领域:当涉足现有模型不适用或不足的领域时。例如,开发一种尚未被探索的新型医学诊断AI2. 基于独特数据集应用:在数据对特定需求具有独特性的情况下,例如公司使用客户数据来预测购买模式。3. 创新和研究:非常适合研究和开发,用于测试新理论或模型。模型训练是人工智能发展的基石,提供了无与伦比的定制化和创新潜力。然而,它需要大量数据和GPU计算资源和开发资源,成本很高,并带有固有的风险,因此更适用于需要定制解决方案或在人工智能应用领域开辟新天地的情况。微调(Fine-tuning)是机器学习和深度学习中的一个术语,指的是在预训练模型的基础上,针对特定的任务或数据集进行进一步的学习和调整。

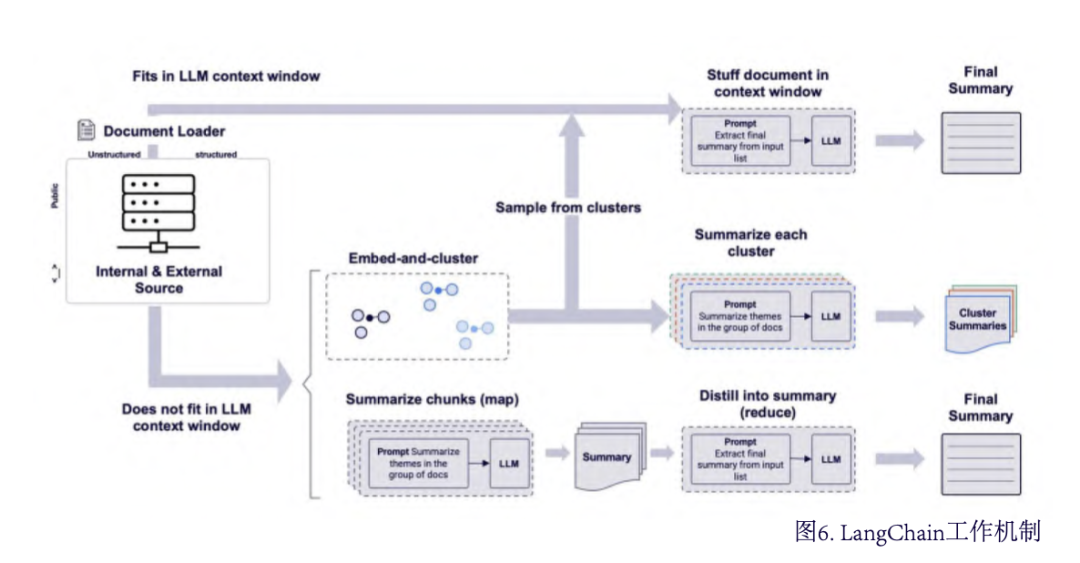

微调类似于磨练技艺娴熟的艺术家,使其在特定类型中表现出色。它涉及对经过预训练的模型进行调整,即对已经从大规模数据集中学到一般模式的模型进行专门任务或数据集方面的进一步提高。这一过程对于将通用人工智能模型适应特殊需求至关重要。例如基于医学文献训练微调成一套更适合回答健康护理相关的问题。1. 特定任务应用:适用于需要模型的一般理解与特定需求相匹配的任务,例如使语言模型适应医学术语。2. 有限资源:适用于无法负担完整模型训练所需的大量资源的情况。3. 提升模型性能:当您需要提高预训练模型在特定领域准确性时。在 GenAI 中,微调是将通用模型转变为专业模型的艺术。它在效率和性能增强之间取得平衡,非常适合有针对性改进的场景。这种方法最适用于基础扎实但需要特定专业知识的情况。在人工智能领域,大语言模型(LLMs)如GPT-3.5和GPT-4等已经成为了自然语言处理(NLP)的强大工具。它们能够生成连贯的文本、回答问题、甚至创作诗歌和故事。然而,尽管这些模型在处理语言方面表现出色,但它们在实际应用中的潜力仍然受限。为了克服这些限制并充分发挥LLMs的能力,LangChain应运而生。LangChain是哈里森-蔡斯(Harrison Chase)于2022年10月发起的一个基于LLM的应用开发框架开源项目,是目前大模型应用开发的最主流框架之一。它提供了一套工具和组件,使得开发者能够将LLMs与外部数据源和计算能力结合起来,从而创建更加智能和功能丰富的应用。LangChain围绕将不同组件“链接”在一起的核心概念构建,通过统一的接口简化了与 GPT-3.5、GPT-4、llama、文心一言、通义千问等 LLM 合作的过程,使得开发者可以轻松创建定制的高级用例。

截至2024年3月,LangChain平台已实现了与包括亚马逊、谷歌及微软Azure在内 的主流云存储系统的深度整合,并且封装了涵盖新闻资讯、影视资料和气象信息的多样化API接口。此外,LangChain提供了对Google Drive文档、电子表格及演示 文稿内容的自动化总结、抽取与创建能力;同时涵盖了Google搜索与Microsoft Bing搜索引擎的网络信息检索功能。在自然语言处理领域,它成功对接了OpenAI、 Anthropic 和Hugging Face等多家知名机构的语言模型资源。在编程与代码管理方面,LangChain支持Python与JavaScript代码的自动生成、静态分析与调试功能,并采用Milvus与Weaviate向量数据库系统分别用于存储与检索高维向量嵌入及缓存相关对象。为加速数据访问性能,系统配备了Redis作为缓存数据存储方案,并通过Python Requests Wrapper及其他API请求手段确保了与各类服务的 无缝交互。在并发处理层面,该平台能够实时追踪并记录线程与异步子进程运行中的堆栈符号信息。截至2024年3月,LangChain已具备读取超过50种不同文档类型和数据源的强大能力,展现出广泛的应用潜力和卓越的技术适应性。RAG,即检索增强生成(Retrieval-Augmented Generation),是一种结合了信息检索(Retrieval)和文本生成(Generation)的人工智能技术。RAG是GenAI领域的重大进展,它通过整合外部知识源来增强传统的大语言模型 (LLM)。这种方法拓宽了人工智能的视野,使其能够访问和利用除初始训练数据之外的大量信息。可以将 RAG 想象为一位学者,除了拥有自己的知识外,还可以即时访问到一座全面的图书馆。2. 根据问题在向量数据库(提前将知识库的文档向量化)检索匹配相关的上下文段落信息3. 将检索结果的top_k条段落进行排序,将提示词和组装的段落以及用问题三者形成最终的提示词prompt5. 大模型生成输出并返回给Chatbot,进而返回给用户1. 提高答案准确性:通过引用外部知识库中的信息,RAG可以提供更准确的回答2. 增加用户信任:用户可以通过引用的来源来验证答案的准确性3. 便于知识更新和引入特定领域知识:RAG通过结合LLM的参数化知识和外部知识库的非参数化知识,有效地解决了知识更新的问题4. 减少幻觉问题:RAG能够减少语言模型中的幻觉问题,使生成的响应更准确、可靠AI Agent,即人工智能代理,是一种具备环境感知、决策制定和行动执行能力的智能体,也被称为“智能业务助理”。其旨在利用大模型技术,通过自然语言交互方式高度自动化地处理专业或复杂工作任务,从而显著减轻人力负担。在本质上,AI Agent是建立在大语言模型之上的智能应用,即在大模型的基础上运行的应用程序。AI Agent不仅限于对话交流,还能整合外部工具,直接完成各种任务。一个基于大模型的AI Agent系统可分为四个组件部分:大模型、规划、记忆和工具使用,对应需要四个能力:包含大语言模型能力、具体拆解问题的能力、具有长短期记忆控制的能力、以及具有调用外部工具的能力。AI Agent有望开启新时代,其基础架构可简单划分为Agent = LLM + 规划技能 + 记忆 + 工具使用。在这一结构中,LLM充当Agent的“大脑”,为系统提供推理、规划等关键能力。