在提倡节能环保的大环境下,Agent 也加入了可持续发展事业中。Agent 如何实质性地推动智能电网和能源管理领域的技术进步?本周绿洲邀请到了香港中文大学的李彤欣教授,他在电力系统和可信机器学习领域拥有深厚的研究背景,带领团队探索了平等 Agent 框架,有望为个人、电力公司乃至数据中心带来节能省钱的解决方案,让我们听听他如何利用 Agent 帮助使用者省钱提效。Enjoy《Building Socially-Equitable Public Models》

Equitable PM Agent 框架

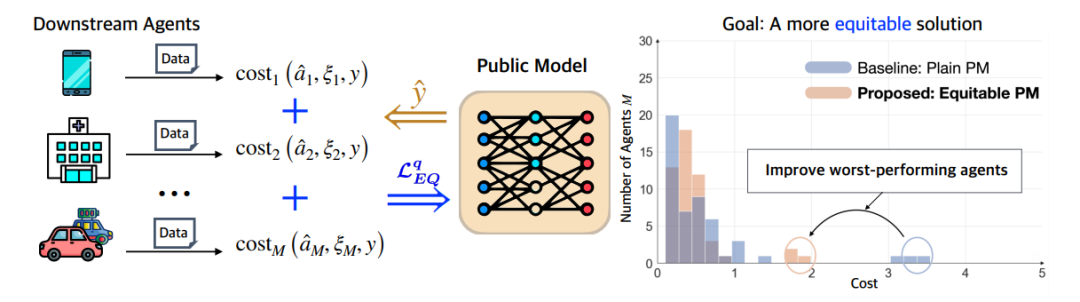

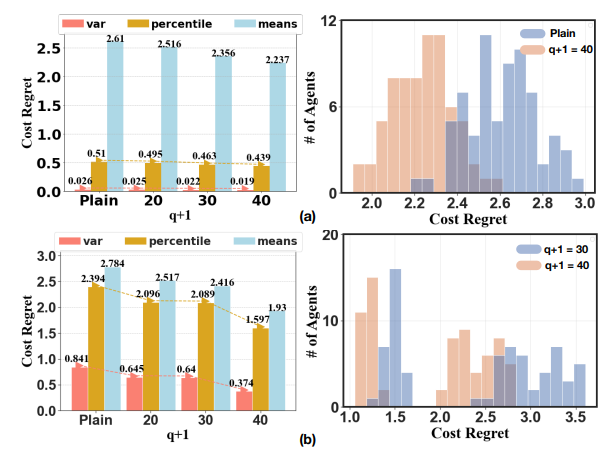

论文链接:https://arxiv.org/abs/2406.02790解决问题:公共模型为各种下游任务提供预测,但一味强调预测准确性可能与下游 Agent 的不同最终目标相冲突。团队将 Agent 下游目标整合到优化过程,提出了公平目标(Equitable Objective),使下游 Agent 性能分布更加均匀,每个 Agent 都有自己独特的关注点模型架构:Agent 架构分为两块,前端进行公共目标设定,满足于大家的公平性(Define Fairness),后端利用特殊的求解器进行计算与训练,最终保证 Agent 预测结果更贴近实际目标应用场景:电力 Agent、能源 Agent、交通 Agent 等一系列严肃场景测试结果:团队提出的 Equitable PM 框架能够将预测误差最小化,与不考虑下游 Agent 在不同环境下的目标方法相比,Equitable PM 能获得更公平的解决方案

Equitable PM Agent 框架部分测试结果

绿洲:请帮我们介绍一下您的经历与研究方向?

李教授:我从博士开始的研究方向是智能电网和可信机器学习,主要研究物理系统的控制优化,例如复杂网络系统的决策场景,如何对电网进行更好的控制,或者对交通网络进行建模优化。电网里有很多物理定律和条件约束(例如基尔霍夫定律、欧姆定律等)是非线性的,导致整个优化问题非常难求解。电网过去有 PID,LQR 或者 MPC 这种模型预测控制,它们本身没有充分利用到采集到的数据,然而我们平时网络监测到的反馈数据本身是非常有价值的,例如我们可以用强化学习从过去数据中学习生成更好的决策行为。

这些 AI 决策往往并不是可以直接采纳的。如何通过引入可信超参数,使算法兼顾 Worst-Case 保障(又称“鲁棒性”)和对有利 AI 决策的充分采纳(又称“一致性”);不同模型在不同 AI 决策范式下一致性和鲁棒性怎么样严谨定义并比较;在理论层面,对于任意算法,它们是否存在彼此之间的 Tradeoff 等,都是我在博士期间研究的方向。我的背景和传统深度学习研究不同,我关注严肃决策场景中的人工智能。有别于其他机器学习学者偏向于虚拟场景,我更感兴趣于真实大规模物理系统中 AI 方法扮演的角色及与之相对应的难点和挑战。

可信机器学习的潜在应用价值是非常高的。在一些实际场景中比较关键的严肃系统中,一旦出了一点小错,或者不符合它本身设立的约束条件,那么就可能会造成一些很严重的后果,经济损失也很大。如何让建立在基模之上的 Agent 可信,还有 Agent 核心的决策可信度如何提升等,都是我现在研究的方向。

在应用层面,我的研究涉及到很多电力系统的案例,因为电力系统是可控机器学习中比较理想的应用落地场景,保证电力系统不出重大的错误和自动驾驶对安全性与鲁棒性的要求类似,一旦系统提供了超过容量的指示,也许就有面临电线烧毁的可能。所以电力系统未来是 Agent 应用的一片沃土,而可信方法会让 Agent 充分照进现实。

绿洲:请帮我们介绍一下开发 Equitable PM 的初衷?

李教授:这个工作由 UCR Shaolei Ren 老师团队和我共同完成。做 Equitable PM 的动力从我们思考未来 Agent 发展方向开始,未来底层基模大概率会变成公共服务。然而每位用户使用 Agent 时,由于目标不同,很难为每人形成一个公平的定制化服务。因此我们想开发 Equitable PM 这一套框架,来更好地服务每位用户在调整模型时的目标优化差异。这次讨论的论文中列举了数据中心的例子,我们利用 Agent 来预测数据中心的碳排放效率(Carbon Efficiency),用户选择 Agent 提供的公共服务,预测掌握未来碳排放的高效程度,来优化数据中心的成本。数据中心的优化决策依赖于模型的预测时间序列。

然而用电模型的优化程度,在同一个类似场景的另一类细分应用需要预测的终值又完全不一样。例如:数据中心我们需要预测最近几天的电价以及与其对应的用电效率,充电桩我们需要预测最近几小时对应的相似的数据,那么同一基模之上我们设立的 Agent 需要完成的任务目的是完全不同的。我们的方法可以在许多类似的不同场景中用来训练 Agent 模型提供公共服务,实现用户层面的社会公平。

绿洲:请帮我们解释一下 Equitable PM 框架的开发方式?

李教授:Equitable PM Framework 包括两部分。第一部分是公共目标设定,简单来说就是如何定义满足于大家的公平性(Define Fairness),从数学定义如何权衡每个个体的期望,这个期望在电力领域中通常就是用户得到的平均成本(Average Cost)。如果我的用电成本和大家的区别太大,那我肯定不满意。为了刻画社会公平,我们引入一个 q 参数去权衡。其本质上类似于数学里面范数(Norm)的概念,可以将参数设立为范数中的变量 q 进行调节,再进行大规模采样之后算出平均数。

第二部分是训练,有了这样的数据之后没办法用传统的求解器(Solver)进行计算,因为有些用户的优化成本是离散、不可求导的函数,此时我们需要用一些黑盒优化的方法来做,那么会需要把一些采样数据放到一个 Batch 里进行优化求解。

绿洲:请问在数据中心以及 EV 充电桩两个评测案例中,我们是如何设置实验的?

李教授:第一个在数据中心的例子中,我们假设有 50 个数据中心,统一采用一家公司的预测服务,里面的模型都用时间序列预测模型(LSTM)进行预测。模型中我们有自己的参数,它决定了每个时间段里这些数据中心的碳排放值,这个预测给到每个数据中心后,通过合理的数学公式进行成本建模,这个数学公式中涉及的数据包括可再生能源和化石燃料随着时间变化的分配比例。每个用户都想最小化自己的成本。此外我们还用了 Azure Cloud 的 Workload Data。

第二个 EV 充电桩的例子,我们假设它的公共模型是 Transformer 架构,利用比较简单的单层编码器-解码器组合,利用位置编码(Position Encoding)进行向量处理。这个场景中的用户到充电中心充电的时候会有预测值显示,对于不同电价会有不同的充电量建议,中间包含了复杂的水消耗、碳排放等具体数据,全部组合在一起能够给用户一个最佳决策结果。这部分数据一部分用的是我在加州理工校园充电桩项目中实际收集的数据,用户行为在不同年份(疫情前、疫情后)、不同时间段、不同天气的数据截然不同,再加上美国的电网系统有非常多不同的供应商(美国基本每个州都有自己的电力公司,不像国内仅有几家大型电力公司),建模起来复杂得多。

这两个示例中我们的 Equitable PM 框架都可以保证社会公平。在 Equitable PM 框架中,第一部分的公共目标设定至关重要。作为工程师需要深度了解用户需求,并反馈给系统设计人员,让他们知道用户实际关心的成本到底是什么,才能更准确地权衡模型。此外,一旦模型设立好,就能提供给用户极具个性化的预测方案。在新能源渗透率不断提高的背景下,这种方案在大公司,电力公司或者聚合商会有非常大的需求,因为它们可以更好地预测未来。

李教授:过去我在博士期间做的主要工作比较偏理论,以后的方向我会尝试将研究做得更落地一些。例如我现在感兴趣的方向是基于大模型,在垂类的场景中更好地微调。传统的优化方式会使用 LoRA 或者 QLoRA 等方法,但当有几千上万个用户之后,就要考虑如何权衡,是设计一个模型(比如包含进去一些经济指标,减少和 Agent 之间的交互),还是我们如何把公共模型多个 Expert Agent 结合。

另外我现在也比较关心在线决策问题,如何利用 Agent 来更好地解决在线问题。因为在线其实是很实际的问题模型,很多决策都需要即时来做,用户并不知道未来会发生什么事,Agent 会给你更好的建议与提示,但 Agent 的建议偶尔会有问题,也不一定完全可信。一旦在重要系统里出错,后果会非常严重。把错误修正方式融入到模型训练过程中,也是我现在关注的 AI 在线决策的场景。

绿洲:您觉得现在 Agent 实际应用比较欠缺的点是什么?

李教授:我觉得实际应用中一个很重要欠缺的点在于通用 Agent 如何能“接地气”。是否能通过例如和传统方法结合等模式,让人信任并使用 Agent 系统,怎样说服用户从传统方法转变为真正信赖并使用 Agent。举个简单的例子,我熟悉的电网控制中逆变器,连接了光伏和整个电力系统,光伏并网需要把交流变直流,传统方法已经有很多标准化的执行方式,比如传统电网下垂控制已经有国际知名的标准体系,但其并没有使用过去电网积累的大量运行数据。最近也有用 Agent 的方式来优化决策的案例,在特殊实验场景有不错的效果。然而如何让 Agent 变得可信,在实际应用中落地,还有很多困难要克服。总而言之,短期 Agent 的能力发挥,当前模型已经够用了。但对应下游应用,仍然需要领域专家对模型输出做特定的优化,最终通过特殊设计保证这个系统使用之后不会崩溃,这样 Agent 在提升系统的高效一致性的同时,也不会失去传统解决方案的可靠性,还能替用户省钱。