论文标题:On scalable oversight with weak LLMs judging strong LLMs论文链接:https://arxiv.org/pdf/2407.04622可扩展监督协议旨在使人类能够准确地监督超人类人工智能。论文研究了辩论(debate,两个人工智能竞相说服一个评判者);咨询(consultancy,一个人工智能试图说服一个提问的评判者);并与直接问答的基准进行比较(评判者在没有人工智能的情况下直接回答)。论文使用大型语言模型(LLMs)作为人工智能agents和人类评判者的替代品,假设评判模型比agents模型更弱。 论文进行了一项多任务(包括多模态)研究,评估了可扩展监督协议、咨询和辩论及其开放变体,并报告了对其进行大规模实验的分析,涉及多种模型和协议。论文发现,在之前未研究的封闭QA任务中,弱评判者在辩论协议中的准确度高于咨询,与直接问答相当。此外,通过实施新的可扩展监督协议,开放辩论和开放咨询,论文能够进一步看到这些方法的优势和劣势:当咨询者/辩论者正确选择时,弱评判者在咨询中略优于辩论;然而,当咨询者选择错误时,弱评判者在咨询中远不如辩论。论文发现,跨任务而言,更强的辩论者(根据其Elo分数衡量)导致更高的评判准确度,但这一效应相对于Khan等人(2024)和Radhakrishnan(2023)(仅研究QuALITY任务)较弱。论文将这些解释为辩论的微弱有利迹象,尽管需要注意的是,这只是辩论作为训练协议的一个agents,论文的所有实验都是仅推理进行的。如果当前使用人类反馈进行对齐的实践要继续下去,那么即使AI在重要任务上达到并最终超过专家人类水平,反馈也需要保持准确。解决这个问题的一个方案是可扩展监督——识别利用先进AI能力的训练协议,使人类能够向超人类AI提供准确的训练信号。可扩展监督对于超人类AI系统的安全性尤为重要。Denison等人(2024)最近表明,当前的大型语言模型(LLMs)能够泛化利用不准确训练信号的行为:从简单的行为(如谄媚)泛化到更复杂的行为(如奖励篡改),即模型修改自身的奖励管理。一种假设是,更强大的AI可能会进一步泛化这些行为,发展出更复杂且危险的行为,如策划,其中AI在训练中表现良好是为了日后获取权力;如果这一点成立,提高监督质量可以降低策划行为发生的可能性。Irving等人(2018)的辩论提案引入了这样的观点:两个能力相当的AI之间的辩论可以向能力较弱的人类评判者充分展示双方的优势和缺陷,使评判者能够选择正确答案,希望在辩论游戏的所有纳什均衡中,双方辩手都能以最有说服力的方式说实话。从理论角度来看,将辩论协议与计算复杂性理论中的交互式证明相联系的工作表明,辩论可以使复杂任务能够被准确且高效地监督,即便是由较弱的LLMs来评判较强的LLMs更为有限的评判者。 图1 | 论文的设置。论文评估三种类型的任务(顶行):抽取式,即有一个问题、两个答案选项和一个用于抽取的源文章,以及信息不对称,意味着评判者看不到文章。封闭式,即只有一个问题和两个答案选项。多模态,即问题涉及文本和图像,以及两个答案选项。论文考虑六种协议(中行和底行):咨询,即单个AI被分配正确/错误答案(概率为50/50)并试图说服提问的评判者;开放咨询,类似但AI选择为哪个答案辩护。辩论,即两个AI竞争说服评判者。开放辩论,完全相同,但其中一个辩手,标记为主角,选择为哪个答案辩护。无文章问答,即评判者直接回答问题。有文章问答,(仅在抽取式任务中)评判者根据文章直接回答问题但理论论证留下了实证问题:辩论是否能使能力较弱的评判者在实践中准确监督更强的AI agents?尝试回答这一问题仍处于早期阶段。迄今为止,LM之间的辩论主要在阅读理解任务上进行了研究,评判者人为地受限于仅能看到LLM辩手提供的文本中的简短验证引文。虽然提供了关于辩论力量的初步有希望的证据,但这种类型的信息不对称限制了全面评估理论预测的辩论质量优势的能力。超人类AI与人类之间的长期差异可能会延伸到许多能力上的差异,包括数学和逻辑推理、创造力以及事实知识。因此,实证研究中评判者与辩手之间的差距理想情况下应源于各种能力差异,而不仅仅是信息不对称。 论文探讨了一系列任务上的辩论,这些任务更好地涵盖了必须通过可扩展监督来弥合的广泛能力差距。论文的实验设置如图1所示。这些任务源自多项选择题回答数据集的二元选择版本,包括抽取式问答、封闭式问答和多模态推理任务。为了控制强弱LLM之间的监督差距,论文采用了可扩展监督的方法,其中弱LLM评估强LLM的表现。图2 | 分配角色结果:按任务类型(分面)、评判模型(x轴)、协议(颜色)划分的平均评判准确度(y轴)。数值越高表示效果越好。95%置信区间是根据相同类型的任务聚合计算得出的(详见附录D)。带有文章的问答协议(紫色)仅适用于抽取式任务。只有Pro 1.5是多模态的 表1 | 区分论文任务的关键特征概述:抽取式、封闭式和多模态。抽取式任务涉及信息不对称,其他则不涉及论文的研究在一系列任务上进行,这些任务基于一个二元选择问答数据集,并结合了评估多种可扩展监督协议所需的逻辑和提示模板,涉及大型语言模型(LLMs)。在每个任务中,一个评判LLM回答任务中的问题,可能是在看到辩论者或顾问LLM的输出之后,评判准确性根据真实数据集标签进行衡量。论文沿着三个维度变化设置:(1)可扩展监督协议,(2)问答任务,以及(3)评判LM,下面将详细描述每个维度。有许多问答基准测试语言模型在不同领域回答问题的能力。论文通过使用适用于每种可扩展监督协议的LLM提示模板处理现有数据集来形成任务。通常,对于一个多选的基础数据集,论文通过选择正确答案和一个随机答案来形成一个二元选择版本。论文将任务分为三类,见表1:抽取式问答(QuALITY,BoolQ和GPQA-extractive),其中提供给顾问/辩论者一个二元选择问题和一篇文章,但不提供给评判者,引入了信息不对称。辩论者从文章中提取段落用于他们的论点——模拟了一种特定的弱-强差距。辩论者和评判者可以使用一个工具来验证段落是否确实包含在文章中。 封闭式问答(MMLU,GSM8KQA,PrOntoQA,TruthfulQA和GPQA)包含问题和答案,但没有文章作为来源,与抽取式问答相反,因此没有信息不对称。这里的弱-强差距更多地源于模型内部——它们的能力和技能/推理差距。consultancy(MMMU)任务是图像-文本-文本,其他是文本-文本。评判者和辩论者/顾问可以查看图像以及问题,没有信息不对称。这种任务类型的动机是理解额外模态的影响。任务的详细信息在附录F中提供。可扩展监督协议通过较弱评判者的监督,为高度智能的AI生成训练信号。关于辩论的理论仅在辩论AI与弱评判者提供的信号在训练中收敛时,才保证监督的准确性。在论文的实验中,如同先前的工作(Khan et al., 2024),论文在仅推理设置下,测量评判者的准确性以及随着能力差距增加的扩展趋势,作为可扩展监督协议作为训练信号效用的agents。论文评估了若干可扩展监督协议,参见图1,包括咨询和辩论。在可能的情况下,论文的设置和提示基于Khan et al.(2024)。前两个QA协议(不要与QA任务混淆)不是可扩展监督协议——相反,它们是直接的QA基线协议,用于比较。它们仅使用(可能是弱的)评判模型,没有得到更强模型的帮助。因此,理想情况下,可扩展监督协议应优于这些基线。接下来的两个协议,咨询和辩论,是分配角色,意味着咨询者/辩论者不能选择为哪一方辩护。最后两个协议是开放角色,意味着咨询者和其中一位辩论者可以选择为哪个答案辩护。辩论者/咨询者被提示以链式思维方式构建他们的输出,并提出他们的论点。只有他们的论点会被展示给评判者(思考是私密的)。无文章的QA(Khan et al.(2024)中的“Naive”)作为基线,论文以零样本提示的方式,向评判者提出一个问题和两个答案选项。对于封闭式QA任务,这是一个标准的零样本基线。对于抽取式QA任务,评判者看不到文章,因此除非在不看文章的情况下也能正确回答,否则通常表现不佳。文章问答(Khan et al. (2024)中的“专家”) 对于抽取式问答任务,论文向评判模型提出一个问题、两个答案选项以及全文(注意此协议仅适用于抽取式问答任务)。这使得评判模型获得了回答问题所需的全部信息,相比之下,其他协议在抽取式问答任务中引入了咨询者/辩论者与评判者之间的信息不对称。 咨询模式 咨询模式遵循Khan et al. (2024); Michael et al. (2023)的设置,包括一个咨询者和一个评判者。咨询者被指定一个答案选项,并被提示论证该答案是正确的。评判者则被要求评估该论证并询问咨询者深入的问题。经过固定轮次后,评判者需提供最终答案。对于封闭式问答任务,咨询者和评判者模型拥有相同的信息。对于抽取式问答任务,只有咨询者能看到全文,并需向评判者提供摘录以支持其论点。在论文的实现中,每个问题进行两次咨询评估:一次咨询者被指定正确答案,另一次被指定错误答案。辩论模式(Irving et al., 2018) 此协议涉及两个辩论者模型(分别命名为Alice和Bob),它们通过结构化辩论来说服评判者支持它们的答案。辩论者被分配对给定问题的对立立场,并在多轮中提出各自论点(默认使用三轮)。每轮辩论允许辩论者在两种设置下审查不断演变的辩论记录:同时进行,即双方辩论者基于前一轮的记录同时提出论点;顺序进行,即第二位辩论者还能看到第一位辩论者在当前轮的论点。在辩论记录中,Alice的论点总是出现在Bob之前。每轮辩论者都会收到标准化指令,概述游戏机制、分配立场及现有辩论记录。随后,评判者会看到辩论记录并被要求生成答案。注意,论文选择不评估互动辩论,即评判者在每轮提问,因为Khan et al. (2024)发现这并未在标准辩论中(无论是人类评判者,见他们的图1,还是LLMs评判者,见图8和9)带来改进。开放咨询(Roger, 2024)此协议允许咨询顾问为其认为正确的答案进行辩护,而非答案被预设(包括正确和错误)。这更符合他们可能接受的追求真相的监督训练。在论文的实现中,论文不是生成新数据,而是通过筛选咨询评估,仅选择那些咨询顾问的分配与咨询模型在直接问答(具体为抽取任务的OA有/无文章,封闭任务的OA)格式下选择的答案相匹配的评估。开放辩论 在开放辩论中,采用一种格式,其中一位辩手(指定为主角)选择他们对给定问题的首选答案。另一位辩手,即反角,则自动分配对立的答案。与标准辩论协议相比,这种格式提供了更真实的框架应用方式,可能在AI对齐训练中使用。论文重用现有的辩论评估数据,并将主角识别为在直接问答(如开放咨询中)下分配答案与辩手模型答案匹配的辩手。 论文在工作中使用以下模型:Gemma7B(V1)(仅文本的指令调优版本),GPT-3.5(gpt-3.5-turbo-0125),Gemini Pro 1.0(仅文本版本),以及Gemini Pro 1.5(图文转文本版本,使论文能够仅通过此模型进行多模态操作)。Gemma7B是开源的,论文希望这有助于其他人复现论文的工作。GPT3.5在先前的工作中已被用作裁判(Khan等,2024),使论文能够比较一些结果。在论文的首次实验中,论文使用最强的模型Pro 1.5作为辩论者/顾问,并让所有模型作为(可能较弱的)裁判,以便论文研究由较弱裁判监督的强顾问/辩论者。论文首先在图2中展示了跨任务类型、裁判模型和分配角色协议(咨询、辩论和QA有/无文章)的发现;个别任务的结果可在附录B的图B.1中找到。对于这些结果,论文选择了以下设置:对于咨询/辩论,论文使用Pro 1.5作为顾问/辩论者,并进行3轮互动。对于辩论,论文采用同时轮流,辩论者通过最佳4选1(Best-of-4)选择他们的回应:独立生成4个样本,并提示Pro 1.5选择最具说服力的一个。裁判采用0次提示,根据协议记录预测答案。为了估计协议间性能差异的统计显著性,论文计算了每种任务类型和裁判的准确性差异的基于排列的p值。论文现在强调论文结果的一些关键特征(采用5%的显著性水平)。抽取式任务:Khan等人(2024)在QuALITY上的研究结果能泛化到其他抽取式任务,即便使用不同的模型集合:更强的评判模型往往在各协议中更准确。文章辅助的问答对所有模型都是最佳选择,表明信息直接利用(即使由弱模型执行)优于通过监督进行过滤。重要的是,在辩论、咨询和无文章问答中,评判模型在辩论上的准确性更高——除了Gemma7B,论文最弱的评判模型,其在辩论上的表现并不优于无文章问答。封闭式任务:论文观察到,在封闭式任务中,辩论相比咨询能提高评判模型的准确性(此前这一现象仅在抽取式任务QuALITY中观察到)。 辩论与无文章问答的比较则更为微妙。对于论文最弱的评判模型Gemma7B,无文章问答表现优于辩论(如同在抽取式任务中)。对于GPT3.5,辩论优于无文章问答(p = 0.037)。对于Pro 1.0,辩论与无文章问答之间的差异无统计显著性(p = 0.1)。对于Pro 1.5,当评判模型与辩论者相同时,辩论实际上导致评判准确性低于无文章问答,这与Khan等人(2024)在图31中报告的一些发现相似。论文的解释如下:Gemma7B可能过于弱小,无法从这些协议中学到有价值的信息。Pro 1.5在此封闭问答情境中不存在弱-强不对称性,因此对可扩展监督的启示有限。Pro 1.0和GT3.5可能最能指示可扩展监督的情况,并表明辩论相对于无文章问答可能带来微小或无益处。多模态:咨询明显劣于其他协议。辩论与无文章问答之间的差异无统计显著性(p = 0.11)。判断能力大致与所有任务中报告的能力相关,其中Gemma7B的判断能力不如GPT3.5和Pro 1.0,这两者大致相似,而Pro 1.5的判断能力优于这两者。论文现在总结一系列针对各种设置的消融研究结果,实验结果的图表显示在附录A中。消融研究:回合数(Number of turns ) 论文研究当论文将咨询和辩论中的回合数从3减少到1时会发生什么。论文发现回合数没有显著影响。这表明,对于这些任务、模型和协议,更多回合并不有助于判断。这与Khan等人(2024)关于QuALITY的发现一致。参见图A.2。消融研究:辩论者的最佳N次采样(Best-of-N for debaters) 论文考虑辩论协议并减少辩论者回应的最佳N次(BoN)采样,从4次减少到1次,即标准采样。论文没有看到判断准确性的实质性降低,这表明论文的最佳N次实现并无帮助。Khan等人(2024)并未直接报告N对判断准确性的影响,尽管他们的图3表明Elo随着N增加而增加,判断准确性随着Elo增加而增加(尽管对于更强的辩论者可能不那么明显)。论文在第4.3节关于Elo的发现表明,BoN=4增加了Elo,但并未显著提高准确性。参见图A.3。消融研究:判断者的少示例提示(Ablation: Judge Few-shot prompting) 论文考察了将0次示例提示变为6次示例提示的情况,平衡了正确答案在示例中的顺序。总的来说,结果并未显示出6次示例提示的显著改进。参见图A.4。 消融研究:判断链式思考(Ablation: Judge Chain-of-thought) 论文引导判断者在使用链式思考(CoT)推理(Wei et al., 2022)后再给出答案,并与默认提示进行比较,后者仅指示判断者直接给出答案(预测)。令人惊讶的是,论文发现CoT往往损害性能或影响甚微(见图 5)。论文假设,让较弱的判断者使用自己的CoT会导致他们忽视较强顾问/辩论者提供的口头推理,这些推理可能质量更高。Stureborg et al. (2024) 也注意到CoT降低了LLM评估性能。消融研究:辩论轮次风格(Ablation: debate turn style) 辩论可以采用同时轮次(Alice和Bob仅能看到对方上一轮的论点)或顺序轮次(Alice先发言,然后Bob可以看到Alice的回应,...)。在顺序设置中,Bob可能具有优势,因为Bob可以反驳Alice的最终论点,而Alice无法反驳Bob的最终论点。然而,论文并未看到轮次风格之间存在显著差异,这表明潜在的不对称性并不重要。参见图A.6(注意这是在BoN=1设置下)。

5)。论文假设,让较弱的判断者使用自己的CoT会导致他们忽视较强顾问/辩论者提供的口头推理,这些推理可能质量更高。Stureborg et al. (2024) 也注意到CoT降低了LLM评估性能。消融研究:辩论轮次风格(Ablation: debate turn style) 辩论可以采用同时轮次(Alice和Bob仅能看到对方上一轮的论点)或顺序轮次(Alice先发言,然后Bob可以看到Alice的回应,...)。在顺序设置中,Bob可能具有优势,因为Bob可以反驳Alice的最终论点,而Alice无法反驳Bob的最终论点。然而,论文并未看到轮次风格之间存在显著差异,这表明潜在的不对称性并不重要。参见图A.6(注意这是在BoN=1设置下)。消融实验:位置偏差:位置偏差 Khan 等人(2024)报告称,评判模型表现出位置偏差(Wang 等人,2023b;Zheng 等人,2023),在辩论中系统性地偏好第一个或第二个答案。他们建议每个问题两次呈现答案,并交换辩论顺序,从而将评判成本加倍。论文实施此方法后发现,评判准确率的平均值没有显著差异(图 A.7),且方差略有减少。进一步地,论文考察了每个模型选择的答案位置(1 或 2)的平均值(1.5 表示无位置偏差,因为论文的数据集是平衡的)。评判模型往往显示出位置偏差,在辩论中比其他协议更为明显,而使用两种顺序并未改变答案位置的平均值,只是降低了其方差,见图 A.8。这表明仅随机化答案位置就足够了,而不必通过两种答案位置进行评估。

影响 总的来说,论文认为这些结果表明辩论作为一种可扩展的监督协议,可能比咨询更具前景,尽管论文强调论文的发现仅适用于仅推理设置,并且对用于训练的可扩展监督协议的适当评估可能会揭示其他结果。未来对辩论评估的一个关键挑战是展示其相对于直接 QA 基线的改进——论文推测这可能通过在辩论评判任务上对评判模型进行有限微调来实现,类似于标准微调使模型更适合直接 QA 任务的方式。关于 BoN 的消融研究未显示出改进,这对使用弱 LLM 评判强 LM 的可扩展监督持轻微负面信号,因为 BoN 被视为训练的agents。关于轮次数量的消融研究未显示出改进也是一个轻微负面信号,尽管在辩论训练中可能会有所不同,如果模型学会利用更多轮次更好地反驳上一轮对手的主张。推理设置的改变(少样本、思维链、轮次风格、交换答案顺序)似乎影响不大。

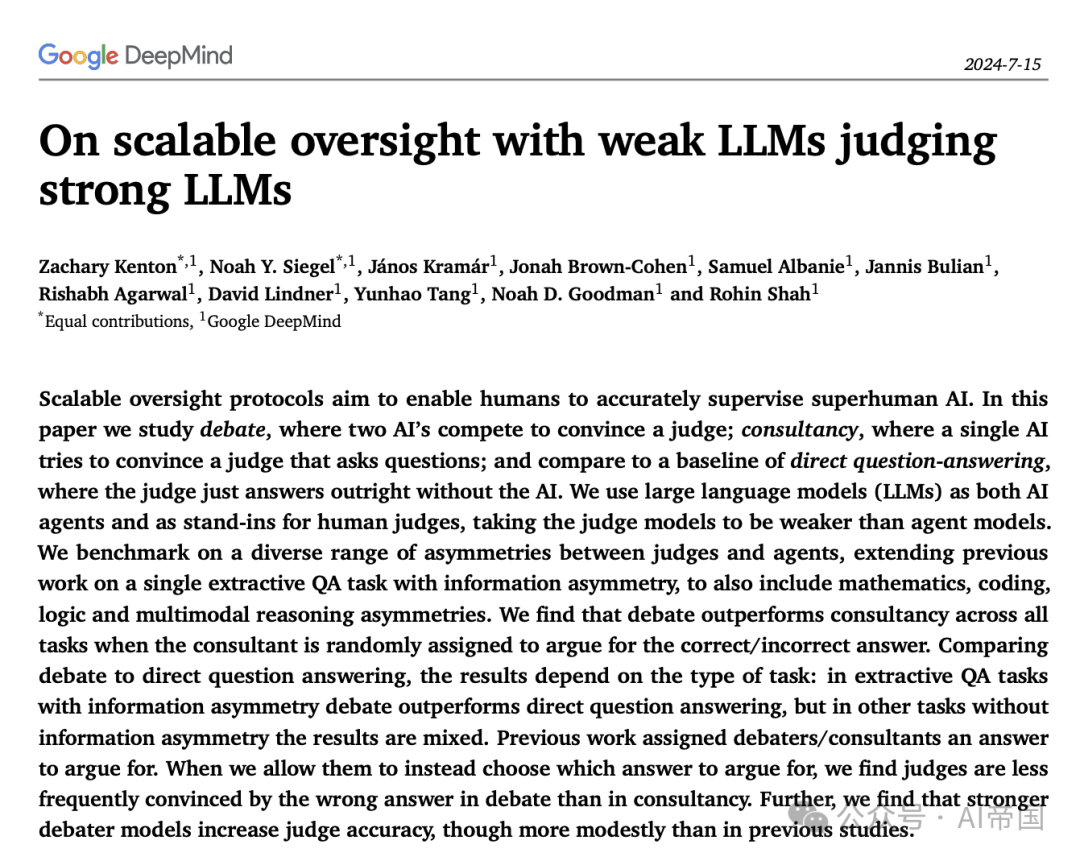

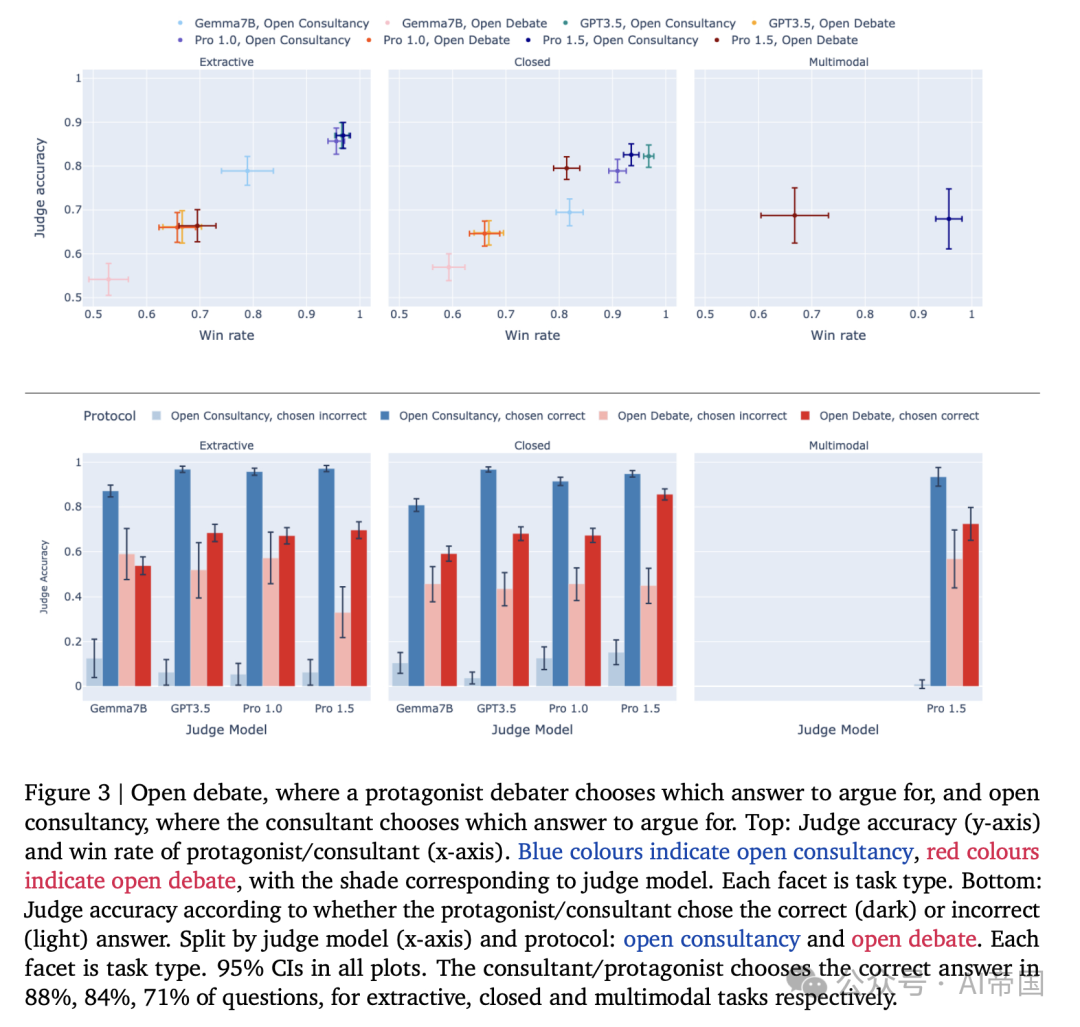

图3 | 开放式辩论与开放式咨询,其中主角辩论者或咨询者选择支持哪个答案。顶部:法官准确度(y轴)与主角/咨询者胜率(x轴)。蓝色表示开放式咨询,红色表示开放式辩论,颜色深浅对应法官模型。每个分面代表任务类型。底部:根据主角/咨询者选择正确(深色)或错误(浅色)答案的法官准确度。按法官模型(x轴)和协议划分:开放式咨询和开放式辩论。每个分面代表任务类型。所有图表中均包含95%置信区间。咨询者/主角在88%、84%、71%的问题中选择了正确答案,分别对应于抽取式、封闭式和多模态任务论文现在比较开放式咨询和开放式辩论,其中咨询者/主角可以选择一个答案来支持。在图3顶部,论文绘制了法官准确度(y轴)与主角/咨询者胜率(法官选择主角/咨询者所支持答案的比例)。蓝色表示开放式咨询,红色表示开放式辩论,颜色深浅对应法官模型。在所有任务中,开放式咨询的胜率均高于(或等于)开放式辩论,这意味着法官在咨询协议中更倾向于同意咨询者的选择,可能是因为咨询者面临的挑战不如开放式辩论中那样强大(那里有一个同等强度的对手)。然而,这并不总是导致更高的法官准确度。对于抽取式任务,开放式咨询确实比开放式辩论导致更高的法官准确度,但在封闭式/多模态任务中,论文最强的辩论法官的准确度大致相同,尽管较弱的辩论法官的准确度低于相应的咨询法官。 为了更深入地理解法官如何受到主角/顾问选择正确性的影响,在图3底部,论文绘制了开放咨询和开放辩论中法官的准确度,按顾问或辩论中的主角选择了正确(深色)或错误(浅色)答案进行划分。对于开放咨询,当顾问选择正确时(深蓝色),法官的准确度较高,而当顾问选择错误时(浅蓝色),准确度较低。对于开放辩论,主角选择正确时(深红色)法官的得分高于选择错误时(浅红色),但差异不如开放咨询情况中那么极端。对于可扩展监督训练而言,最重要的是弱法官能够注意到强模型何时出错。在这方面,论文可以更清楚地看到开放辩论的优势——当辩论主角选择错误时(浅红色),弱法官在开放辩论中的准确度远高于开放咨询中顾问选择错误时(浅蓝色)。然而,这确实会导致当辩论主角选择正确时,准确度相对下降。在未来的工作中,探索一种双方辩论者都有真正开放选择的开放辩论版本将会很有趣,他们可以选择为同一个答案辩论,这可能会进一步提高法官的准确度。论文现在分析辩论者的相对说服力,动机源于辩论作为一种可扩展的对齐训练协议。作为训练模型在辩论游戏中获胜的agents,论文转而考虑辩论模型在说服裁判(仅推理辩论)方面的相对强度,并研究这与裁判准确性的相关性。与仅使用单一模型作为辩论者(Pro 1.5)的第4.1节和第4.2节相比,论文现在使用一系列辩论者,并通过测量他们的交叉对战胜率(裁判选择他们答案的频率)和用Elo评分模型他们的潜在技能,研究这些与裁判准确性的相关性,遵循与Khan等人(2024)类似的设置。论文的发现总结是,较强的辩论模型(按Elo评分衡量)往往会导致略高的裁判准确性,尽管效果相对较小。要点是,这对于辩论作为一种可扩展的监督协议是一个弱正向的指示——尽管人们可能希望看到对裁判准确性的更强影响。Elo评分 论文生成一系列同时辩论中的1轮论点(即仅开场论点),包括五位辩论者:Gemma7B、GPT-3.5、Gemini Pro 1.0、Gemini Pro 1.5(所有BoN=1)和Gemini Pro 1.5(BoN-4)。然后论文从中抽取512个样本(每个数据集贡献相等),研究辩论者的说服力与裁判准确性的关系。

图 4 | 顶部:辩论者的Elo评分,按模型着色,区分他们是被指派为正确(深色)还是错误(浅色)答案。中部:正确答案优势(正确辩论者的Elo - 错误辩论者的Elo)与辩论者综合Elo评分的关系。底部:Pro 1.5评委准确度与辩论者综合Elo评分的关系图。95%置信区间。评委的决策在提取任务上比封闭任务更敏感 论文通过跨游戏辩论的配对(数量),并使用Pro 1.5进行评判,以计算他们的综合Elo评分。论文进一步通过将每个辩论者视为两个不同的玩家来计算正确Elo和错误Elo评分:一个被指派正确答案,另一个被指派错误答案,如附录E所述。结果 在图4(顶行)中,论文展示了每个模型的正确(深色)和错误(浅色)Elo评分,误差棒显示了来自bootstrap抽样的95%置信区间(见附录E)。论文发现,尤其是在封闭任务上,为真理辩护往往更容易,并且更强的模型往往获得更高的Elo评分。图4(中行)展示了正确和错误Elo评分之间的差异(正确辩论者的优势)与他们的综合Elo评分的关系。所有辩论者都显示出正差异,表明被指派正确答案具有优势。然而,与Khan等人(2024)相比,论文没有看到这种优势随着Elo增加而增加的明确趋势。对于提取任务,随着模型说服力的提高,诚实辩论者似乎变得稍微容易些,而在封闭任务上这种趋势不那么明显。论文随后考察了综合Elo与评判准确度(以Pro 1.5为评判者)的相关性,以观察技能更高的辩论者是否能提高评判准确度。图4(底部行)显示,在抽取式任务中,更强的模型具有更高的综合Elo,这些模型导致了更高的评判准确度。然而,在封闭任务中,辩论者之间的差异较小,无论是综合Elo还是评判准确度。这可能是因为评判者在抽取式任务中更依赖于辩论者的陈述,评判者需要依靠辩论者提供他们无法自行获取的信息。