研究团队

柳泽明,车万翔:哈尔滨工业大学

王海峰,雷泽阳,牛正雨,吴华:百度公司

文章下载

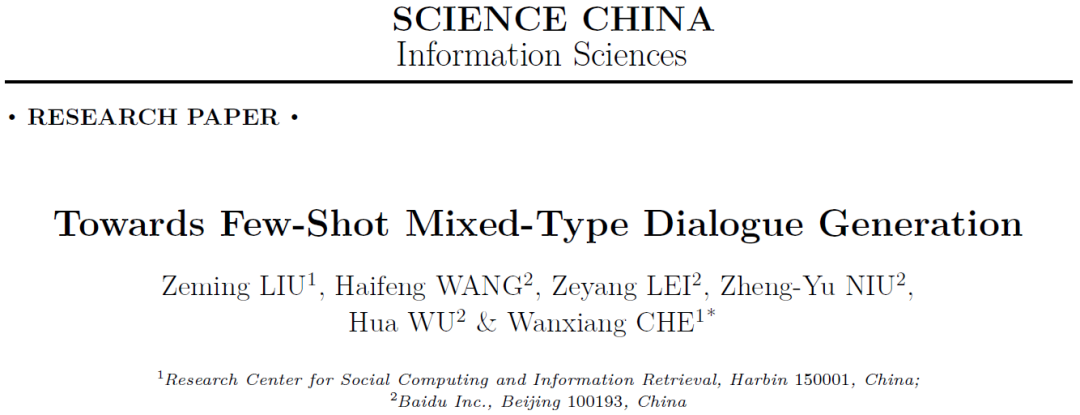

Zeming LIU, Haifeng WANG, Zeyang LEI, Zheng-Yu NIU, Hua WU & Wanxiang CHE. Towards Few-Shot Mixed-Type Dialogue Generation. Sci China Inf Sci, 2024, doi/10.1007/s11432-023-4069-x

在真实对话场景中,用户通常有多样化的需求,这需要对话系统能自然地处理单个对话中的多种类型的对话(称为混合型对话)。例如,用户可以在任务型对话中进行闲聊,也可以在对话推荐过程中提出问题并参与知识对话。为了解决用户多样化的需求,对话系统应具有三类主要功能。首先,它能通过角色聊天来吸引用户,这是一种更具吸引力的社交闲聊形式。其次,它能通过深入的知识对话来讨论各种主题。最后,它能通过两类对话提供服务:对话推荐和任务型对话。两者的主要区别在于它们的目标。对话推荐聚焦在推荐资源,如电影或食物,强调推荐过程;而任务型对话旨在提供服务,如订电影票或餐厅,重点是完成任务。因此,对话系统需要具有根据人机交互情况自动规划适当的对话类型并进行深入对话的能力。近年来,人们对混合型对话的研究越来越感兴趣。这些研究主要是自然地融合常见的对话类型,以创造更自然、更连贯的对话体验。这些研究几乎都试图构建大规模的人工标注数据,以训练混合型对话模型。然而,标注这类数据的成本很高。因此,研究少样本混合型对话很有意义。为了解决上述问题,本文首次研究少样本混合型对话生成。具体来说,本文专注于任务分解和模型设计。首先,本文基于对话角色将混合型对话分解为三个子任务:自然语言理解(NLU)、对话行为规划(DAP)和自然语言生成(NLG)。NLU理解当前对话上下文和识别当前的对话行为,DAP根据对话上下文和NLU确定的行为规划下一轮的对话行为,NLG根据DAP规划的行为和对话上下文生成回复。分解任务后可以方便地引入子任务的监督信号(对话行为),并充分利用与子任务相关的外部语料库。因此,增强了每个子任务的训练,这在小样本设置中尤为重要。

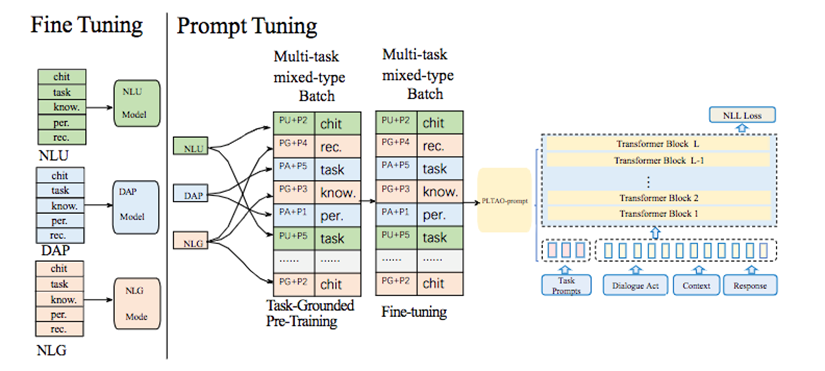

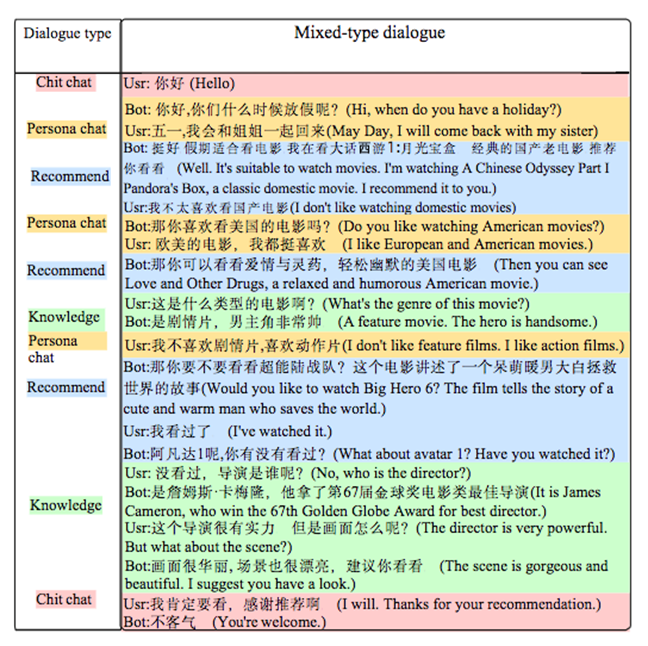

图1 PLATO-prompt模型结构图

此外,为了更好地集成多个分解的子任务,如图1所示,本文提出一个新的预训练混合型对话模型PLATO-prompt。与单独微调单个子任务的方法不同,PLATO-prompt消除了对模型参数冗余副本的需要,并实现了跨多个子任务的更有效融合学习。这种方法极大地促进了少样本混合型对话生成,使该模型能在不同对话场景中生成连贯且符合上下文的回复。具体来说,本文统一使用Transformer编码对话行为和上下文,并生成回复。此外,在输入表征中添加了额外的任务提示表征,以区分不同的对话类型和对话子任务。例如,“P1”、“P2”、“P3”、“P4”、“P5”和“P6”的表征分别用于角色聊天、闲聊、知识对话、对话推荐、任务型对话和问答,“PU”、“PA”和“PG”的表征分别用于NLU、DAP和NLG。然后,通过组合提示,就可以为不同的子任务建模不同的对话类型。例如,“PU+P1”、“PU+P4”和“PU+P5”的表征分别用于角色聊天、对话推荐和任务型对话的NLU。然后,就可以利用外部知识库,预训练和微调各种对话类型和对话子任务,以增强小样本混合型对话生成的性能。为了训练和评估PLATO-prompt,本文将角色聊天融合到对话推荐和任务型对话中,如图2所示,构建了小样本混合类型对话生成基准mixed-FS。在mixed-FS中,本文将角色聊天融入对话推荐和任务型对话中,使对话更自然,更接近实际应用。具体来说,首先通过角色聊天收集用户偏好(例如,喜欢欧洲和美国电影),然后根据迄今为止收集的偏好,更自然和高效地进行对话推荐或帮用户完成任务。此外,为了更接近实际应用,用户偏好会在每轮对话结束时自动更新,而不是在每个对话结束后才更新,更新后的用户偏好将影响后续的推荐或任务。自动评估和人工评估证明了该基准的价值。(1) 据我们所知,本文是首次研究少样本混合型对话生成。(2) 本文根据对话角色将混合类型对话生成分解为三个子任务,并提出一个基于提示的混合类型对话生成框架PLATO-prompt。该框架能够统一地处理这三个子任务,实验结果证明了该框架的有效性。(3) 本文将角色聊天融合到对话推荐和任务型对话中,构建了小样本混合类型对话生成基准。自动评估和人工评估都证实了该基准的价值。总的来说,本文不仅识别了小样本混合类型对话生成这一挑战,还提出一种新的方法和基准数据集来应对这一挑战。

图2 mixed-FS示例

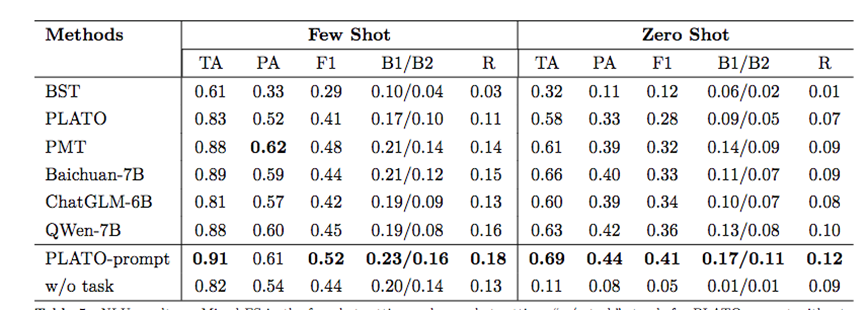

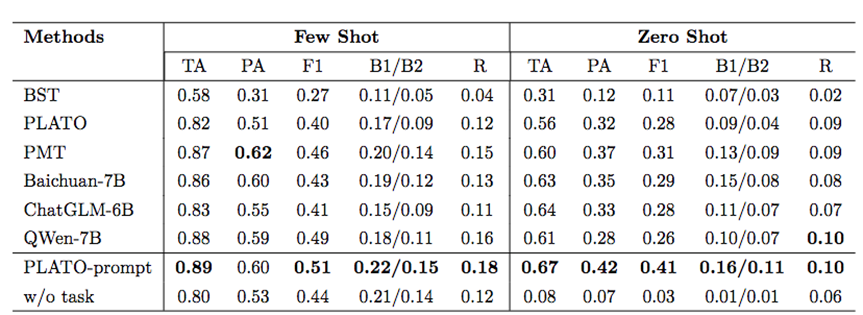

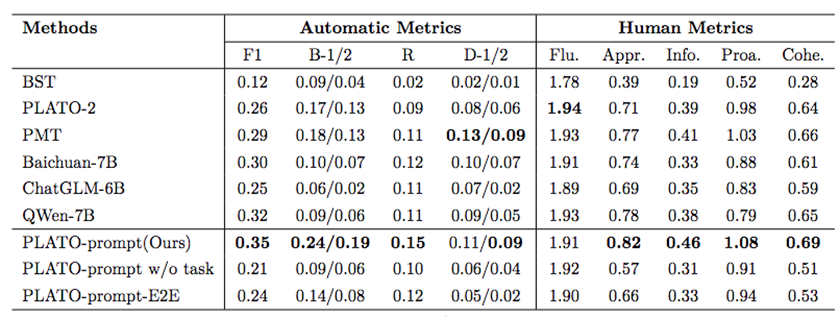

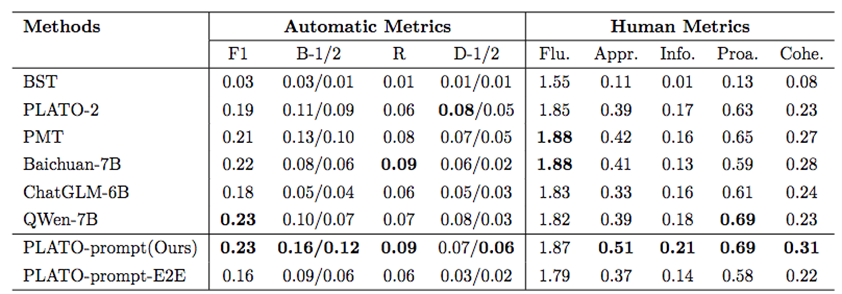

在小样本和零样本两种设置下,测试了本文所提出的框架PLATO-prompt在NLU、DAP和NLG三个子任务上的效果。如图3-6所示,实验结果证明了使用外部对话数据可以增强模型理解用户需求的能力、规划对话行为的能力、生成对话回复的能力。此外,在小样本和零样本两种设置下,PLATO-prompt都可以更好地理解用户需求、规划对话行为、生成对话回复。

图3 小样本和零样本NLU结果

图4 小样本和零样本DAP结果

图5 小样本NLG结果

图6 零样本NLG结果