介绍

大模型发展迅速,Qwen,LLaMA 等模型已经展示了超长输入(128k 以上 token)的处理能力,但是还难以产生较长的文本,比如难以生成一个 2000 字的小说或议论文。我们分析这是由于训练过程中的缺陷:在 pre-training 阶段,尽管有各种长文本来源可供使用,却缺乏有效的指令来引导这种能力;相反,在post-training阶段,大多数由人工或 AI 增强的问答对都比较短,这导致训练好的大型语言模型在生成长篇的与人类偏好对齐的输出时面临挑战。 为了解决这个问题,已有的工作采用了两种策略:反向生成指令 (instruction backtranslation) 和行为模仿,以构建具有长篇回复的数据来微调模型。然而,获得涵盖各种长生成任务和领域的高质量数据具有挑战性;而行为模仿假设存在一个更为强大的模型,但受到如 OpenAI 使用条款的限制。 在本篇工作中,我们首次展示了如何仅利用 LLM 的内在知识和技能来激发其长文本生成能力。我们方法的核心是一个名为 Self-Lengthen 的迭代训练框架,其中包含两个角色:生成器和扩展器。生成器负责生成初始回复,而扩展器的任务是延长回复的长度。

论文标题:

Language Models Can Self-Lengthen to Generate Long Texts

https://arxiv.org/abs/2410.23933

https://github.com/QwenLM/Self-Lengthen

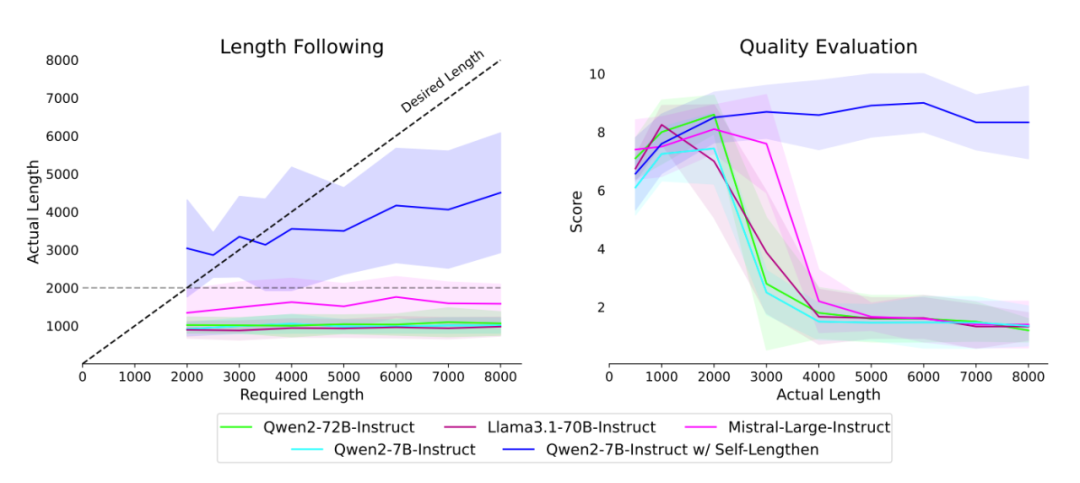

我们选取 10 条长生成指令进行测试,发现现有的主流开源模型都难以生成长文本;即使通过修改解码策略来强制让模型产生长输出,我们发现当模型输出超过 2000 字,输出的质量迅速降低,都出现了重复、乱码等问题。而使用了我们的 Self-Lengthen 方法进行长度扩充后,我们成功将 Qwen 模型的输出能力从 1000 字提升到了 8000 字(图 1)。

方法

Self-Lengthen 主要可以分为四个基本步骤:1)指令增广,2)初始响应生成,3)响应扩展,以及4)微调下一次迭代的模型。这四个步骤将被反复进行,从而逐步提升大语言模型的输出长度。流程图如图 2 所示。1)指令增广:我们使用 self-instruct 方法来扩充我们的指令集。具体来说,我们维护一个指令库,每次随机选择两个指令作为 few-shot 来生成一个新指令。2)初始响应生成:在第 次迭代中,我们使用从上一次迭代微调过的生成器来根据增广的指令 生成初始响应 。随着生成器每次迭代生成长输出的能力不断提高,这些初始响应的长度也将逐步增加。3)响应扩展:在生成初始响应 后,下一步是扩大其长度以创建一个更长的响应 。直接一次性扩展响应受限于模型的最大长度限制,无法在迭代中实现持续增长。为了解决这一问题,我们提出了一种分两阶段的扩展方法,使我们能够达到并突破模型的长度限制。在阶段 1,我们使用初始回复的前一半(记作 )作为扩展器的输入进行扩展过程。这将产生内容前半部分的扩展版本 。由于输入较短,模型可以生成比输入明显更长的输出——可能将 扩展到几乎两倍其原始长度,与 大致匹配。在阶段 2,我们将整个初始回复 提供给 进行进一步扩展。在这里,第一部分的扩展 作为现有的扩展内容用于完成第二部分的扩展,就像在 in-context-learning 中用于展示扩展的结构和方式一样。一个实例如图 3 所示。其中粉色字代表用户指令,绿色字代表初始回复,蓝色字为阶段 1 的扩充指令,棕色字为阶段 2 补充的扩展。4)微调下一次迭代的模型:当我们获取到更长的回复后,我们将使用这些回复来同时微调生成器和扩展器,这使得它们生成、扩展的回复更长。我们迭代这些步骤来得到越来越长的回复。

实验

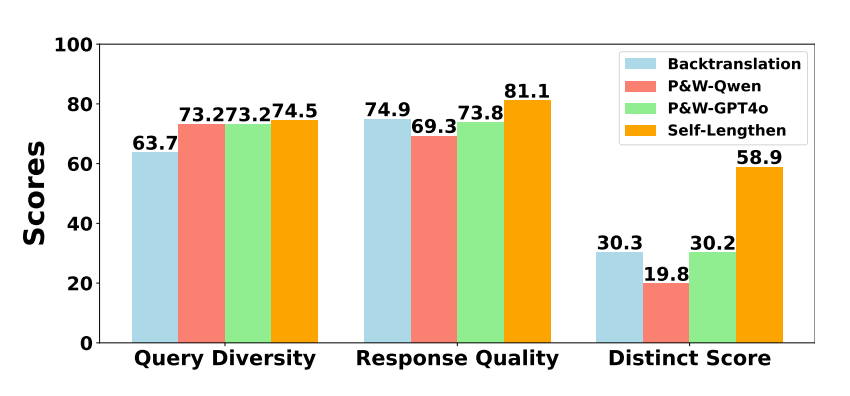

我们同时评估了构造的数据质量以及用这些数据训练模型的效果。在数据评估中,我们组织了数位志愿者对我们的数据以及其它方法构建的数据进行打分,对比数据中的问题多样性和回答满意度。同时,我们还统计回复的 Distinct 分数进行了比较。我们发现我们在几个纬度上均超过了其它方法,结果如图 4 所示。

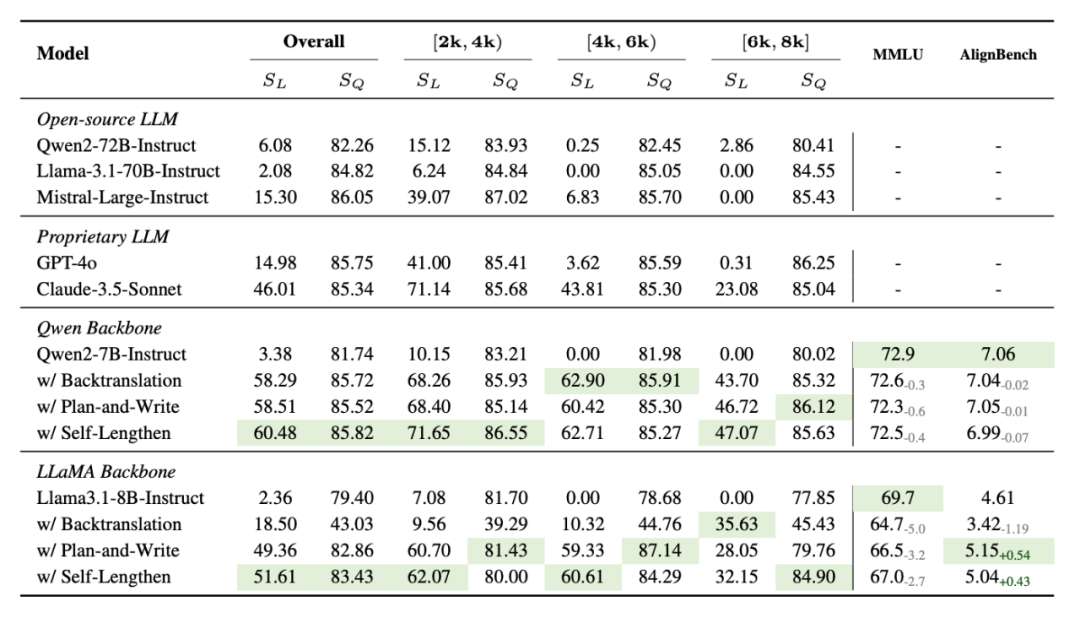

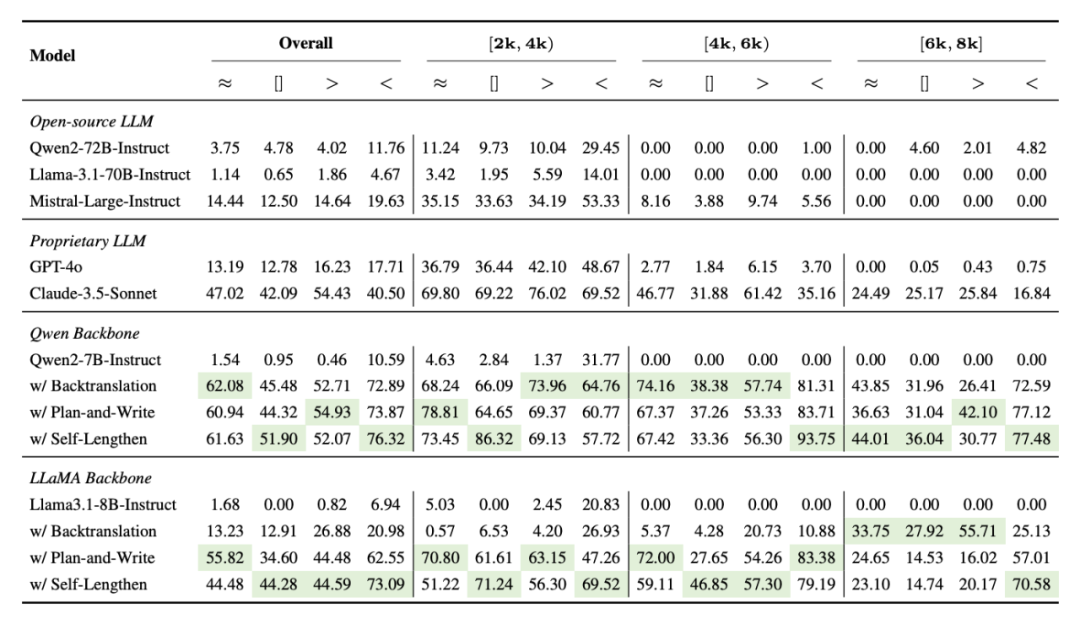

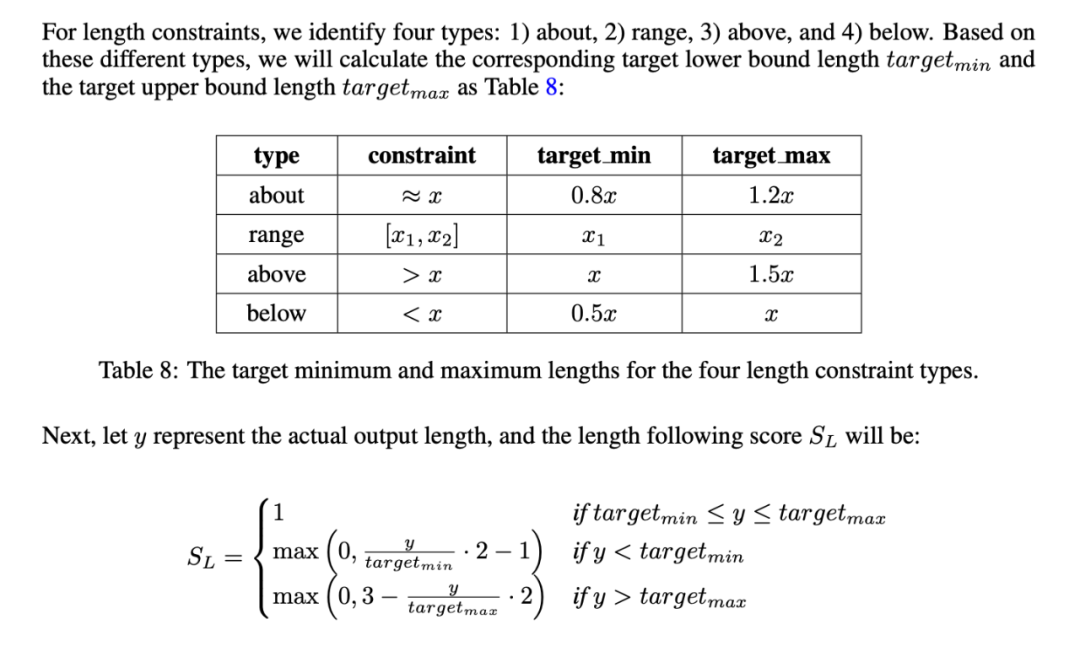

在模型评估中,我们首先构建了一个长生成能力的评估基准 LonGen,包含了文学写作、科研写作、情感表达等七类任务,并且在指令中都包含了明确的长度限制。根据模型的真实输出和不同的长度限制类型,我们根据图 5 提出的公式来计算模型的长度遵循分数。

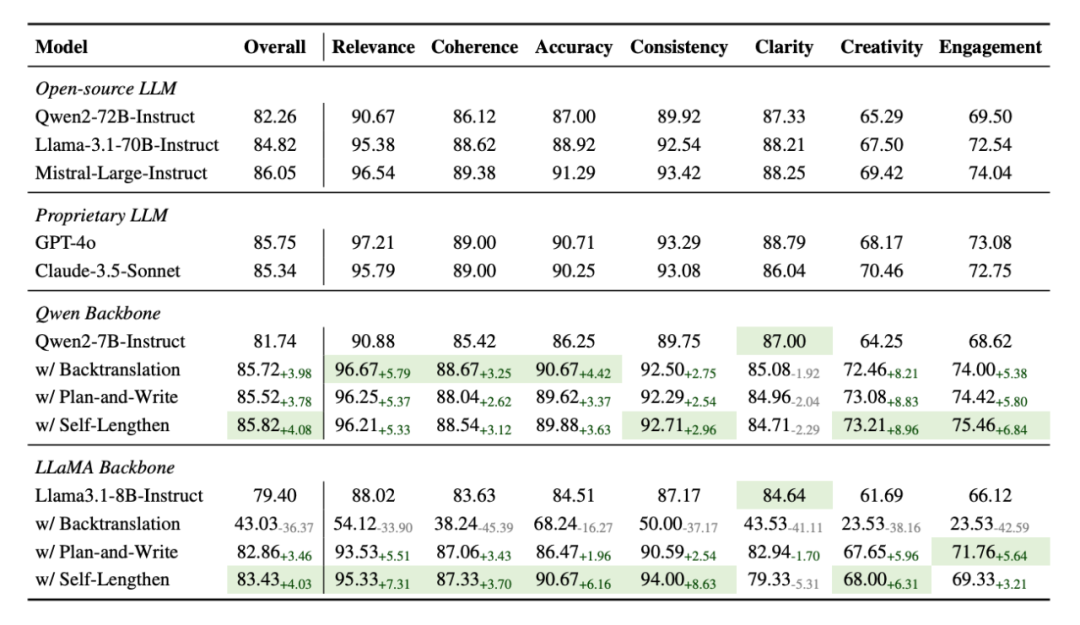

同时我们使用 GPT-4o 来对不同模型在回答相关性、准确性、创造力等七个纬度上进行打分来得到质量评估。我们发现我们的方法在 Qwen, LLaMA 基座模型上始终比其它方法有更好的长度遵循效果和质量评估分数,并在长输出任务上超过了其它的通用开源和闭源模型。