推荐语

DeepSeek-R1 模型开源即爆火,性能超强。这是小贤看到的关于它最好的介绍,没有之一。

核心内容:

1. DeepSeek-R1 开源后的火爆情况

2. 模型的实测体验表现

3. 与其他模型的对比及优势

杨芳贤

53AI创始人/腾讯云(TVP)最具价值专家

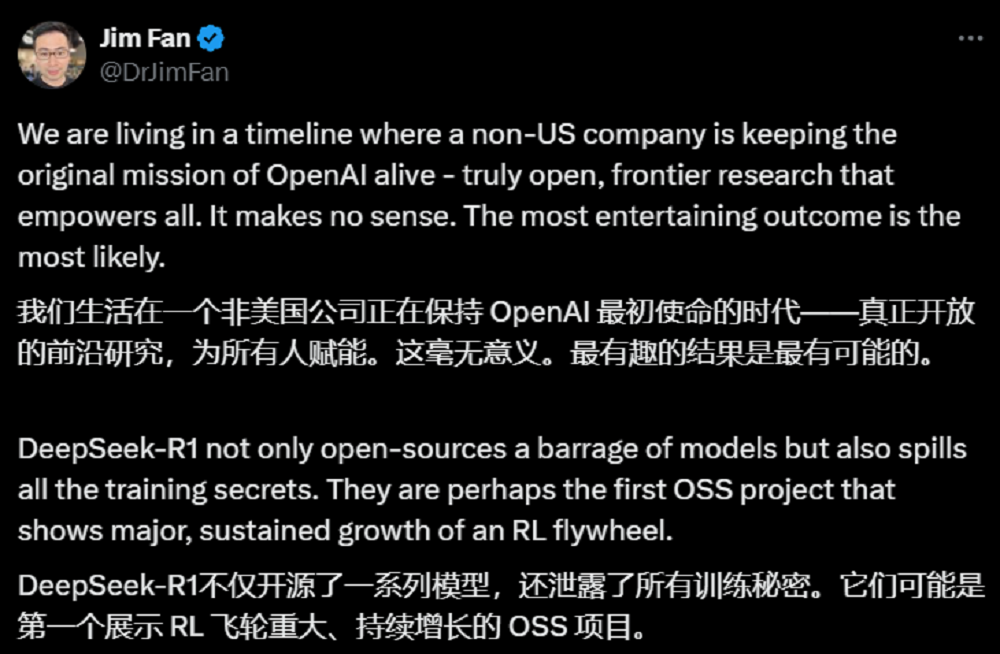

智东西1月21日报道,昨晚开源的DeepSeek-R1模型问世即爆火,在AI圈热度持续发酵。不到一天,他们公布在GitHub上的论文就获得5000多收藏,相关话题在YC黑客新闻、Reddit和X等平台的互动量已经过万。DeepSeek-R1目前在Web和App端可完全免费使用,模型均开源,多领域性能比肩OpenAI o1。智东西也在第一时间上手体验了这款模型。英伟达资深科学家、I Agents业务负责人Jim Fan给予了极高评价,说DeepSeek-R1不仅开源了大量的模型(正式版+6款蒸馏模型),还分享了所有的训练细节和方法,可能是第一个充分展示强化学习(RL)飞轮效应显著,且仍在持续增长的开源项目。

▲Jim Fan对DeepSeek-R1做出高度评价(图源:@DrJimFan)

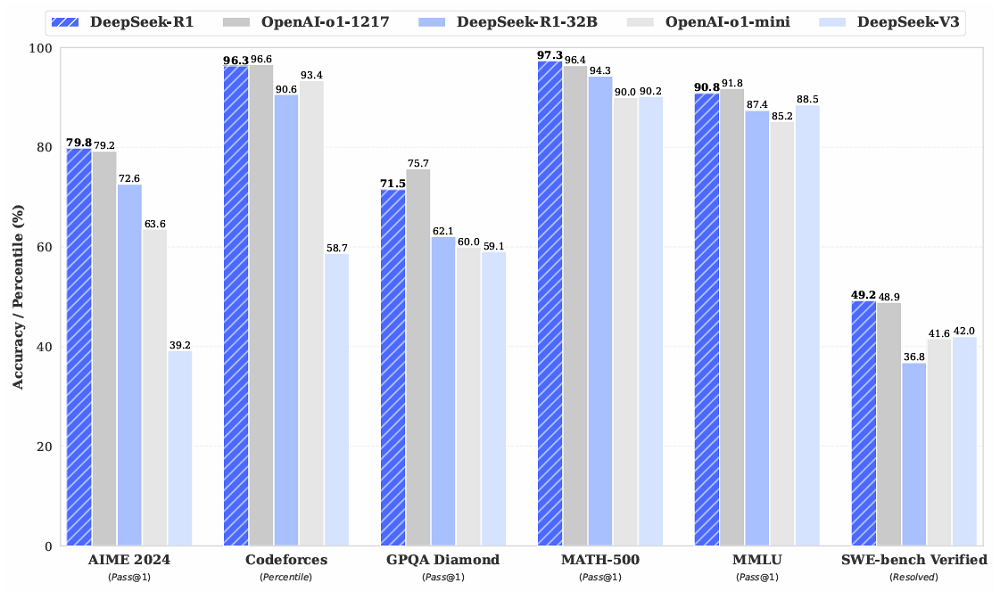

根据实测体验,这款模型80多秒就能完成一道高考压轴题,9分钟就能写出一段“开箱即用”的代码,这段代码渲染出的动画生动地讲解了量子力学的相关概念。它也是一名不错的文科生,能在普通人还没读完题时就得出脑筋急转弯的答案,或是将古埃及、南非原住民历史中的细枝末节分析得头头是道。如果仔细阅读DeepSeek-R1的思考过程,就能发现它思考时的语言风格十分自然,还会随口蹦出一些“Yeah, that works!”这样的活泼表述。与DeepSeek-V3相比,推理能力让DeepSeek-R1的回答更为全面、详实,且论证充分。它一般会以结构化的方式提供回答,并在思考和回答过程中补充大量背景信息,不少用户反馈这些信息很有启发性。据DeepSeek官方公布的数据,这款模型在数学、代码、自然语言推理等任务上,和OpenAI o1正式版的表现不相上下。

更惊人的是,DeepSeek-R1在大规模强化学习(RL)中自然涌现出了强大的推理能力和有趣的推理行为,并未进行有监督的微调(SFT)。根据体验结果和DeepSeek官方的介绍,DeepSeek-R1目前在通用性、多语言能力、提示工程和软件工程能力这4大领域面临一些挑战,这导致它在函数调用、复杂角色扮演等任务上的表现还没有达到预期水准。DeepSeek-R1采取了发布即上线的策略,用户已经在DeepSeek官网与App上免费体验这款模型,也可通过每百万tokens输出仅需16元(OpenAI o1价格的3.7%)的API接口使用。下面,我们就分别从理科、文科和模型短板这三方面来看看DeepSeek-R1在实测中的表现。https://huggingface.co/collections/deepseek-ai/deepseek-r1-678e1e131c0169c0bc89728dhttps://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

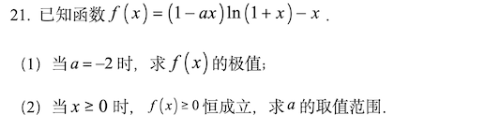

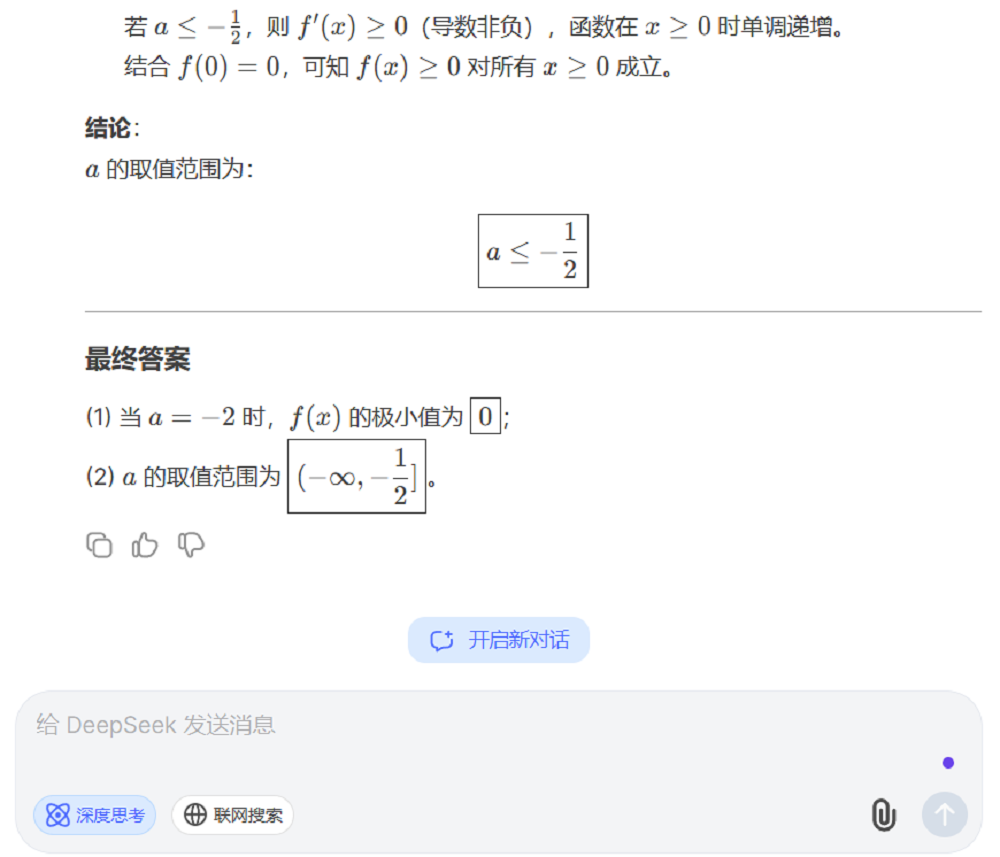

理科类问题一直是推理类模型的优势领域之一,简单初高中的数学题已经难不住大部分推理模型了,所以我们直接给DeepSeek-R1上了一道2024年高考全国甲卷理科数学压轴题。

DeepSeek-R1用83秒回答了这一问题,答案完全正确。美中不足的是,它的求解过程并不完全符合评分标准中的规范,漏掉了一个需要证明的点,应该拿不了满分。

X平台上的海外网友贡献了一个十分有趣的用例——他将自己对量子电动力学原理的理解告诉DeepSeek-R1,让DeepSeek-R1用直观的视觉方式呈现出来,下方是这位网友的部分提示词。

DeepSeek-R1提供了实现这一效果的代码,渲染出来的效果是这样的:

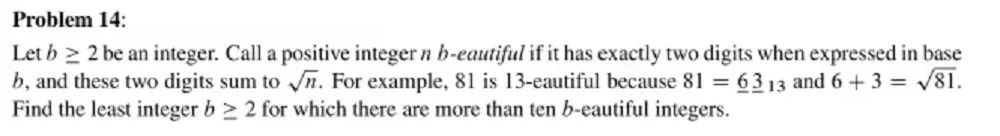

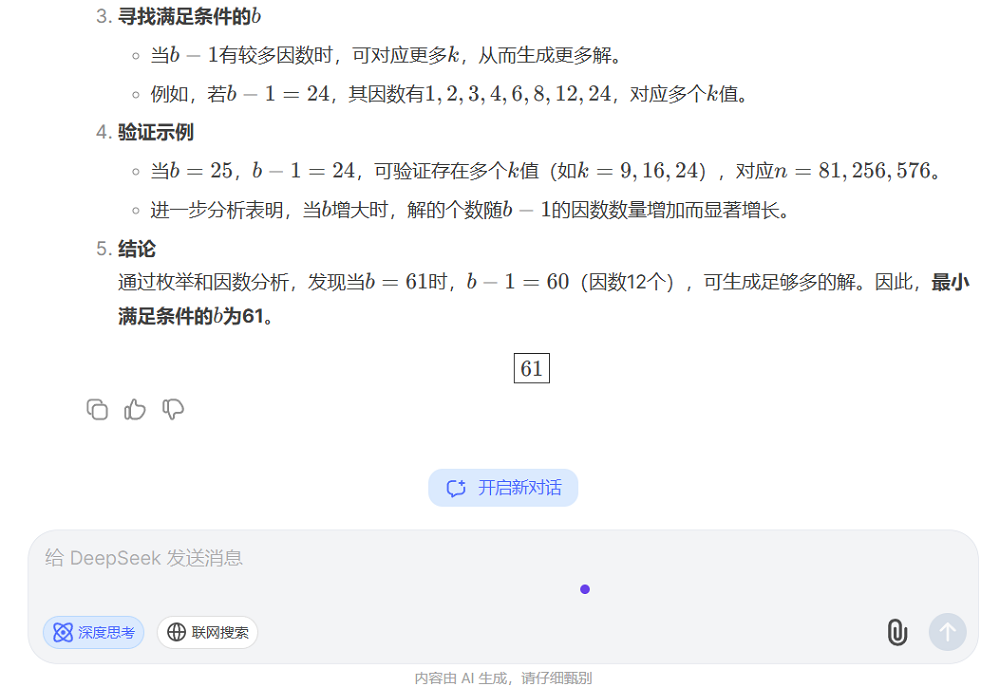

这位网友称,DeepSeek-R1生成这一代码单次耗时大约9分钟,一次成功,没有出现数学错误,仅出现视觉平面偏离的问题,他很快就修复了。这几乎是一种“开箱即用”的体验。不过,DeepSeek-R1也是有能力上限的,这道美国2024年AIME数学邀请赛真题就难住了它。

DeepSeek-R1思考了足足213秒才给出回答,结果也与正确答案不符合。

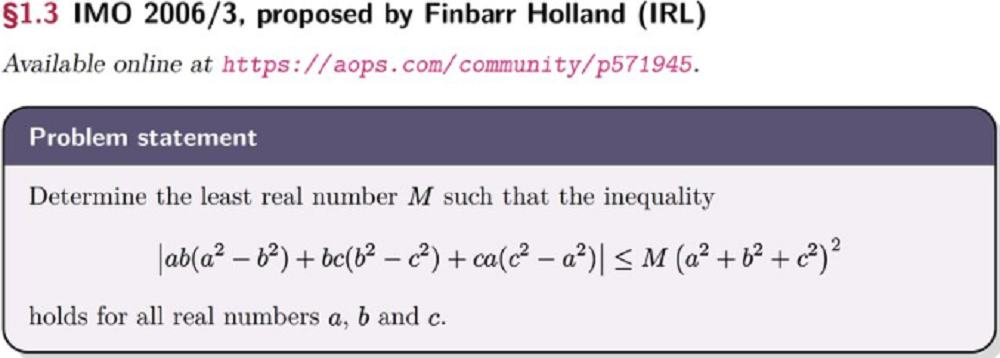

下方这道2006年IMO(国际数学奥林匹克竞赛)的第三题(也是最难的问题)让OpenAI o1都束手无策,而DeepSeek-R1也没能成功回答,从第二步开始,它的回答就与标准答案相去甚远。

综合体验下来,DeepSeek-R1已经具备了不俗的理科实力,大致相当于一名优秀的大学生。考虑到它较快的响应速度和极低的价格,这一成果难能可贵。

DeepSeek介绍,自然语言推理也是DeepSeek-R1的强项之一。智东西从斯坦福自然语言推理数据集中选取了几道题目,DeepSeek-R1基本都能在10秒内给出正确答案。

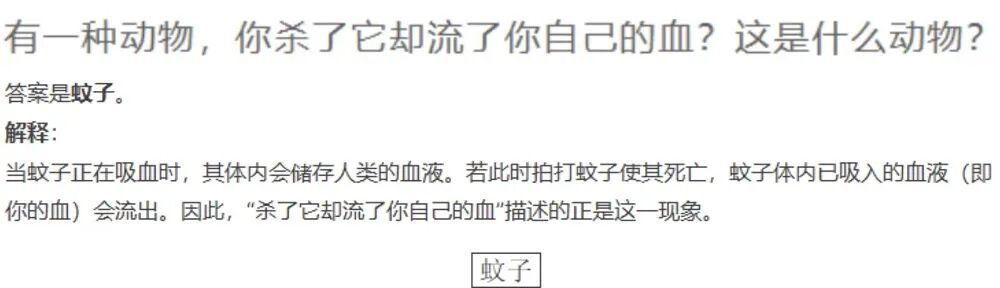

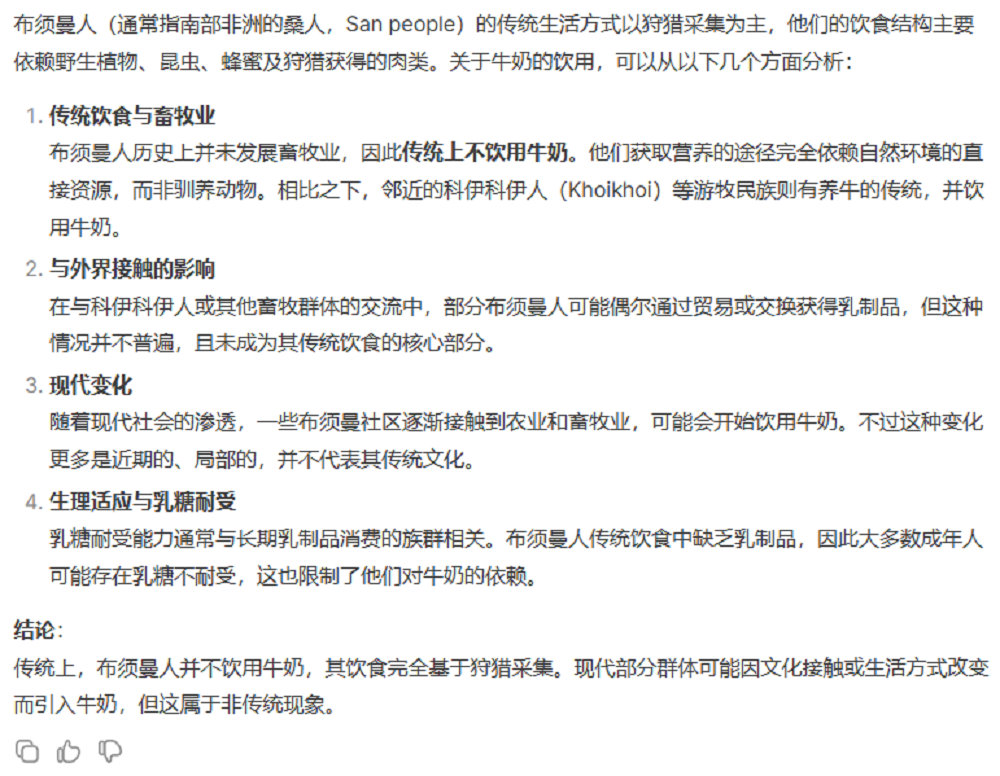

而在中文脑筋急转弯类的问题上,智东西让DeepSeek-R1回答了10道题目,回答用时均在10秒钟以内,答案也都完全正确。在下方这道题目中,它不仅给出了最常见的答案,还在思考过程中分析了水蛭、跳蚤等其它动物。

▲中文脑筋急转弯测试中的一道题目

在文字推理之外,我们也有必要对DeepSeek-R1的其它文科类能力进行测试。近期奥地利研究机构复杂性科学中心(CSH) 的研究显示,大模型在历史类问题上的表现普遍不佳,由于史料数量的差异,大模型很有可能混淆不同的历史阶段,最终给出错误答案。比如,“古埃及有没有常备军”这个问题就难住许多大模型,无论其是否具备推理能力。当智东西将上述问题发送给DeepSeek-R1时,它的回答条理清晰,经过人工逐一查证,DeepSeek-R1对历史事件的描述基本准确,而在时间上与部分主流表述有冲突,回答的综合质量比较高。

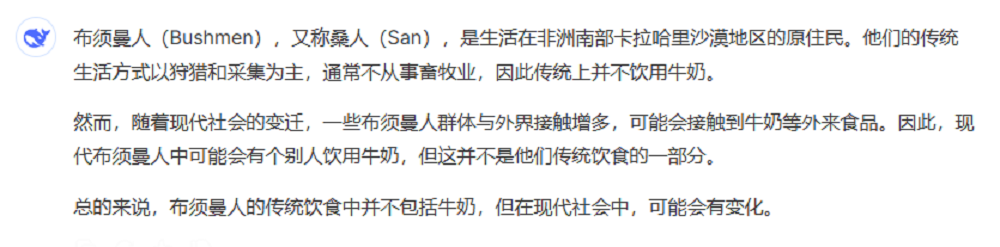

而面对非洲原住民这种史料极为缺乏的群体,R1也能给出正确信息和完整的论证。

为确保客观,智东西也测试了DeepSeek-v3这一不具备推理能力的模型在上方问题中的表现。在大部分问题上,无论具备推理能力与否,模型都能给出正确答案,推理能力给模型带来的主要增益在信息丰富度、文字逻辑等方面。

说完了优点,那DeepSeek-R1有没有什么能力的短板呢?据DeepSeek官方在论文中的介绍,这款模型针对英文和英文进行了优化,有时模型无法按照用户问题的语言进行思考。比如,当我将脑筋急转弯问题用德语输入后,DeepSeek-R1会自动将其翻译成中文或英文,然后再作答。这一过程会减慢DeepSeek-R1的思考速度,因为它花了大量的时间在讨论德语问题的翻译结果。最终,它的回答从蚊子变成了水蛭,据它自己介绍,这一答案参考了其它德语谜语。

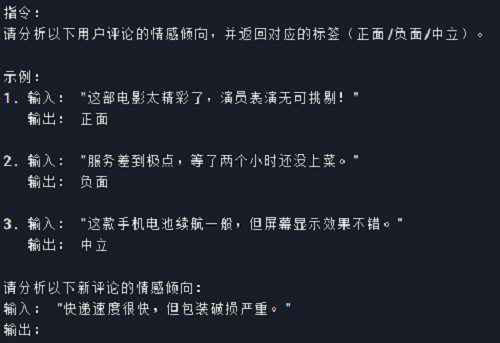

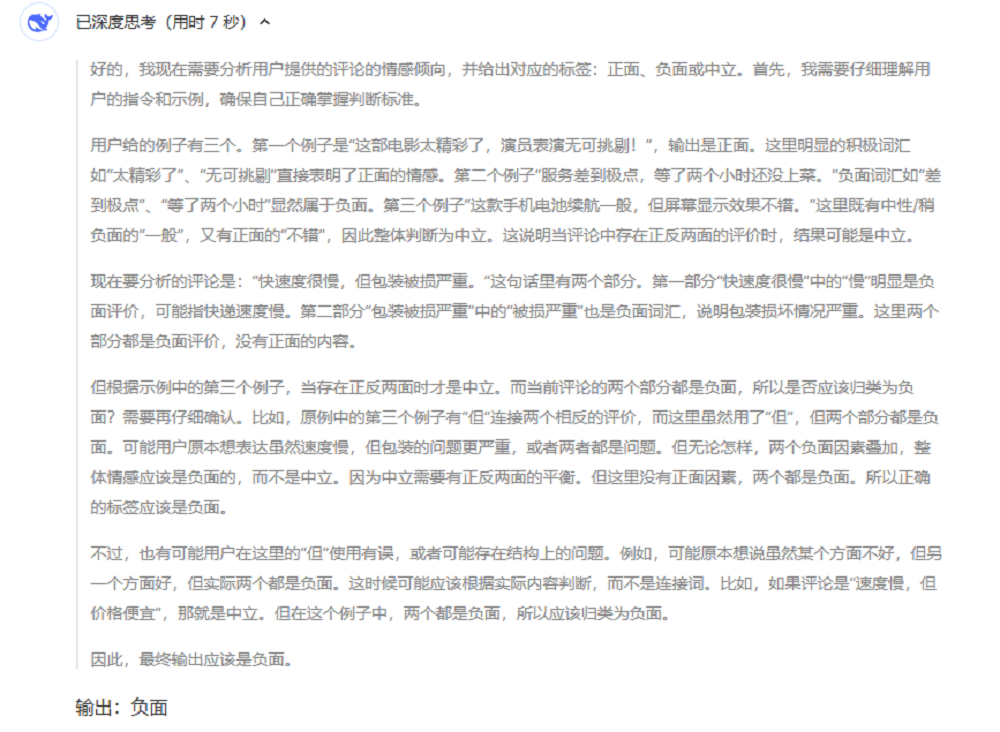

同时,提示词形式对DeepSeek-R1的表现也有很大的影响。有部分提示词会通过提供多个示例来提升回答质量,但在DeepSeek-R1上这可能会适得其反。当智东西将下方少样本提示词(Few-Shot Prompt)发给DeepSeek-R1和DeepSeek-V3时,前者需要花费7秒才能得出答案,而后者用时不到1秒。

▲测试中用到的多示例提示词

从DeepSeek-R1的思考过程来看,它在此类提示词上出现问题的原因可能是“想太多了”。

DeepSeek-R1的论文中还写到,这款模型的通用能力和软件工程任务的能力目前存在短板,但在未来,他们会通过长思维链技术、异步评估等来提高模型表现。

DeepSeek-R1一经发布,就得到全球AI开发者的积极采用和高度评价。有人晒出自己用了数小时API后0.06美元的账单,也有人分享蒸馏后的模型在M2芯片笔记本上高速运行的画面。值得一提的是,DeepSeek-R1是DeepSeek旗下首款以MIT协议开源(包含权重)的模型,不限制商用,也无需申请,还明确允许通过模型蒸馏等方式将DeepSeek-R1用于训练其他模型。这意味着DeepSeek-R1有望在全球AI领域产生广泛影响,也能从全球开源社区中获得正向反馈,不断改进模型。