Source:OpenAI o1 Results on ARC-AGI-Pub (arcprize.org)

在过去24小时内,我们获得了OpenAI最新发布的o1-preview和o1-mini模型的使用权限,这两款模型特别针对模拟推理能力进行了训练。在给出最终答案之前,这些模型被赋予额外的时间来生成并优化推理步骤。

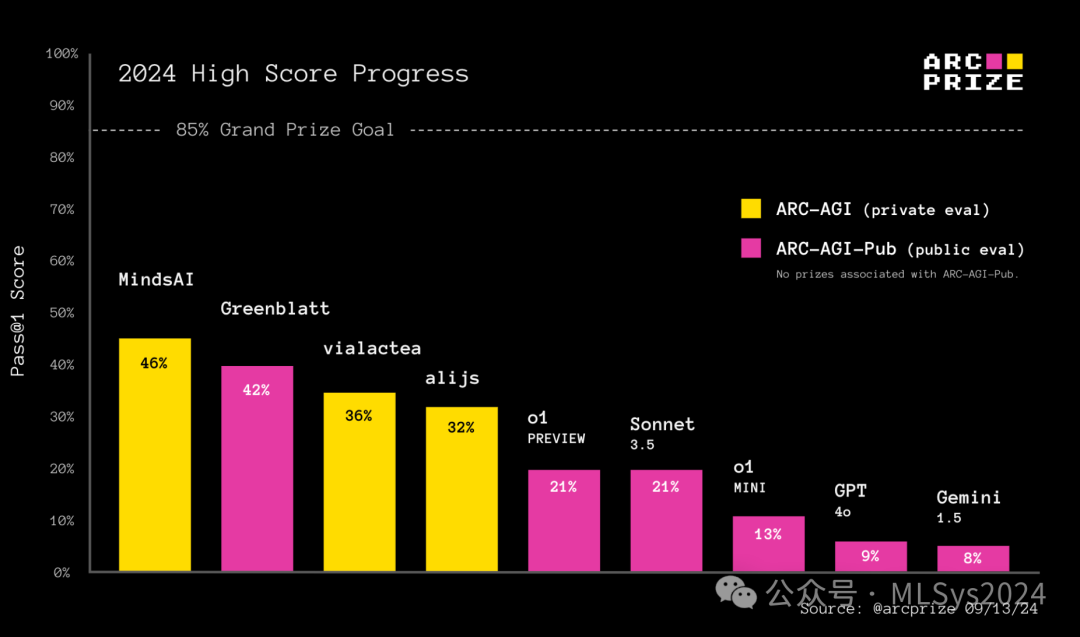

鉴于众多用户询问o1在ARC Prize上的表现如何,我们使用与评估Claude 3.5 Sonnet、GPT-4o及Gemini 1.5时相同的基准测试框架对其进行了测试。以下是测试结果:

o1是否标志着通往通用人工智能(AGI)的新范式?它能否实现规模扩展?为何o1在IOI、AIME等众多令人瞩目的基准测试中表现出色,与在ARC-AGI上仅获得中等分数相比,存在如此巨大的差异?这些问题值得我们深入探讨。CHAIN-OF-THOUGHT

o1模型在训练和测试推理阶段均全面实现了“让我们一步步思考”的链式思考(CoT)范式。

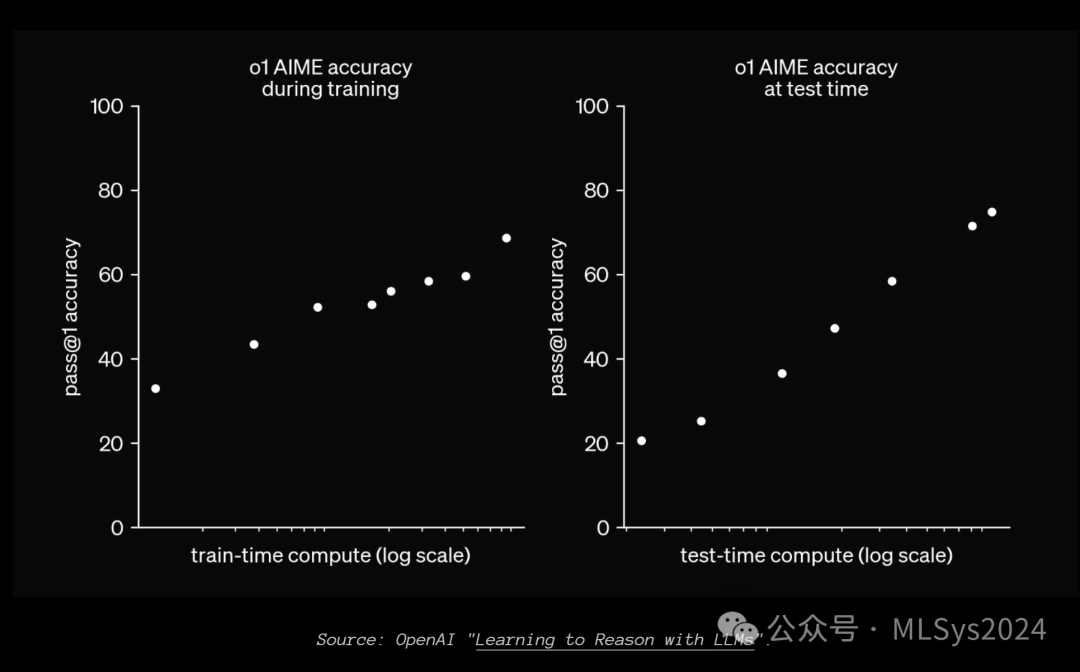

在实践中,当执行的任务中,中间步骤序列在合成的链式思考(CoT)训练数据中得到良好表示时,o1模型出现错误的概率显著降低。在训练阶段,OpenAI表示他们构建了一种新的强化学习(RL)算法和一个高度数据高效的流程,该流程利用了链式思考(CoT)。这意味着o1训练的基础来源仍然是一组固定的预训练数据。但OpenAI还能够生成大量模拟人类推理的合成CoT,通过强化学习进一步训练模型。然而,一个未解之谜是OpenAI如何选择用于训练的生成CoT?尽管我们了解的信息有限,但可以推测,强化学习的奖励信号可能是通过验证(在数学和代码等正式领域)和人工标注(在任务分解和规划等非正式领域)来实现的。在推理阶段,OpenAI表示他们利用强化学习使o1能够优化其链式思考并细化其策略。我们可以推测,这里的奖励信号可能类似于OpenAI之前发布的actor-critic系统。同时,他们在推理阶段对生成的推理标记应用了搜索或回溯技术。o1模型最引人注目的地方在于,它成功展示了将链式思考(CoT)推理搜索应用于非正式语言(如日常对话)而非数学、代码或Lean等正式语言的有效实例。尽管在训练阶段利用CoT进行扩展值得称赞,但真正的亮点在于测试阶段的扩展能力。我们坚信,通过迭代CoT,模型能够真正实现更广泛的泛化能力。自动迭代重提示使模型能够像MindsAI团队利用的测试时微调那样,更好地适应新情境。如果只进行一次推理,我们就只能局限于重新应用记忆中的程序。但通过为每个任务生成中间输出CoT,我们能够解锁组合已学习程序组件的能力,从而实现适应性。这种方法是解决大型语言模型泛化面临的头号问题——适应新情境能力的一种途径,尽管它像测试时微调一样,最终仍有限制。当AI系统被允许在测试阶段使用可变量的计算能力(如推理标记的数量或搜索时间)时,由于这取决于允许的计算量,因此无法客观地报告单一的基准测试分数。这正是该图表所展示的内容。OpenAI在发布o1时,本可以让开发者指定测试阶段用于优化CoT的计算量或时间。然而,他们却选择“硬编码”了测试阶段计算能力连续体上的一个点,并向开发者隐藏了这一实现细节。在测试阶段计算能力可变的情况下,我们不能再仅仅通过比较两个不同AI系统的输出来评估其相对智能程度。我们还需要比较它们的计算效率。虽然OpenAI的公告没有提及效率数据,但令人兴奋的是,我们正进入一个以效率为重点的时期。效率对于定义通用人工智能(AGI)至关重要,这也是ARC Prize对获奖解决方案实施效率限制的原因。我们的预测是:未来,我们将看到更多比较准确性与测试阶段计算能力的基准测试图表。ARC-AGI公开模型基准

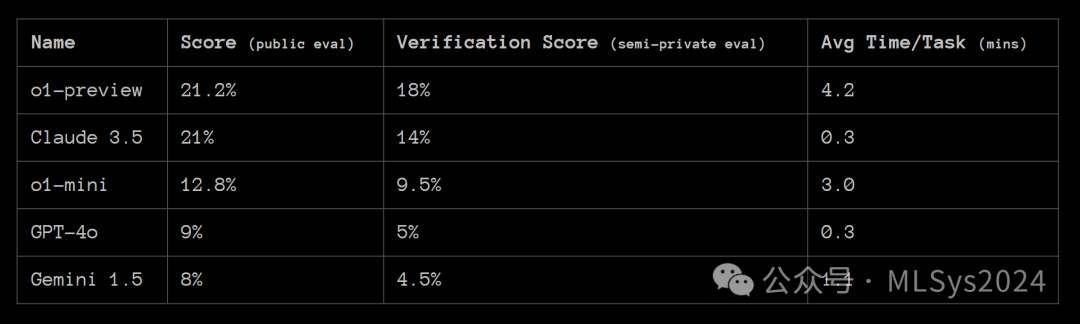

在ARC-AGI公开评估数据集上,OpenAI的o1-preview和o1-mini均超越了GPT-4o的表现。其中,o1-preview在准确性方面与Anthropic的Claude 3.5 Sonnet大致相当,但达到相似结果所需的时间却是Sonnet的约10倍。

为了获取ARC-AGI-Pub排行榜上的基准模型分数,我们采用了与测试GPT-4o时相同的基准提示。在测试并报告像o1这样的纯模型结果时,我们的目的是尽可能地测量基础模型的性能,而不叠加任何优化层。未来,其他人可能会发现更好的方式来提示链式思考(CoT)风格的模型,如果经过验证,我们很乐意将这些新方法添加到排行榜中。o1性能的提升确实伴随着时间成本的增加。在处理400项公开任务时,o1耗时70小时,而GPT-4o和Claude 3.5 Sonnet仅需30分钟。您可以使用我们开源的Kaggle笔记本作为基准测试框架或自己方法的起点。排行榜上的顶尖提交不仅仅是前沿模型的结果,还融入了巧妙的技巧。也许,您能够找到一种方法,将o1作为核心组件,以类似的方式实现更高的分数!

AGI是否已经到来?

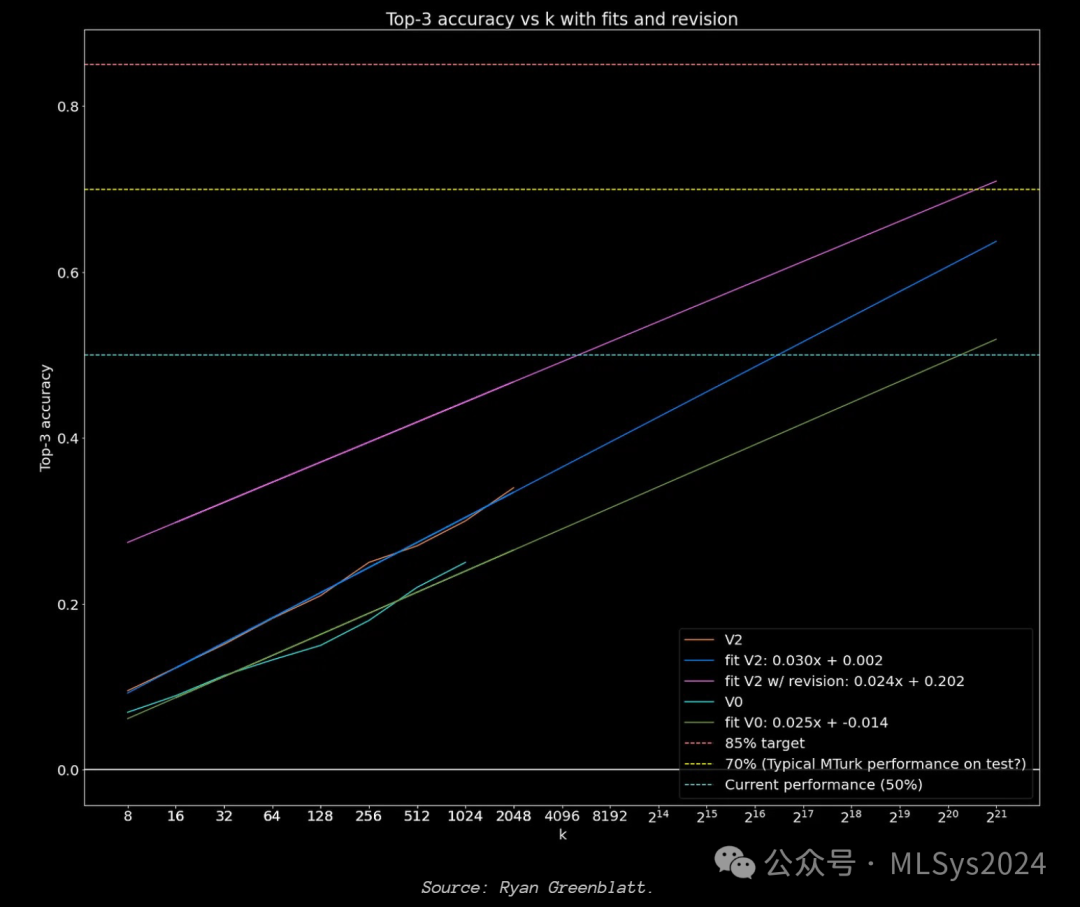

在这张图表中,OpenAI展示了AIME上准确性与测试时间计算量之间的对数线性关系。换言之,随着计算量的指数级增长,准确性呈线性上升。该方法唯一的概念性限制在于向AI提出的问题的可判定性。只要搜索过程有一个包含答案的外部验证器,你就会看到准确性随着计算量的增加而呈对数级增长。实际上,报告的结果与Ryan Greenblatt在ARC Prize中的顶尖方法之一极为相似。他通过让GPT-4o为每个任务生成k=2,048个解决方案程序,并确定性地根据任务演示进行验证,从而获得了43%的分数。

Ryan在ARC-AGI上也发现了准确性与测试时间计算量之间的相同对数线性关系。那么,这是否意味着只要扩展测试时间计算量,AGI就已经到来?并非如此。通过观察任何O(x^n)的暴力搜索,你都能发现类似的指数级增长曲线。事实上,我们知道至少有50%的ARC-AGI问题可以通过暴力搜索而非AI来解决。然而,以这种方式击败ARC-AGI并不切实际,因为你需要为每个任务生成超过1亿个解决方案程序。仅从实用性的角度出发,O(x^n)搜索对于扩展后的AI系统来说就已被淘汰。此外,我们也知道人类并非以这种方式解决ARC任务。人类不会生成成千上万的潜在解决方案,而是利用我们大脑中的感知网络来“看到”少数几个潜在解决方案,并通过系统2型思维来确定性地检查它们。亟需新思维

智能的衡量标准在于系统在不同情境下将信息转化为行动的效率。这本质上是一个转换率问题,因此存在上限。当智能达到完美时,唯一的进步途径便是收集新信息。存在一些方法能让看似不够智能的系统显得更智能,而实际上并未真正提升其智能水平。一种方法是系统仅记忆最佳行动。这类系统非常脆弱,可能在某一领域表现出色,但在其他领域则迅速崩溃。另一种方法是试错。系统若最终得出正确答案,可能会显得智能,但若需经过上百次猜测,则不然。我们期待未来的测试时间计算研究能更高效地扩展搜索和精炼过程,或许可以借助深度学习来引导搜索。然而,仅凭此并不足以解释o1在ARC-AGI与其他客观难度较高的基准测试(如IOI或AIME)之间的巨大性能差距。更充分的解释是,o1主要仍在预训练数据的分布范围内运作,但现在包括了所有新生成的合成链式思考(CoT)。额外的合成CoT数据增强了系统对CoT分布的关注,而不仅仅是答案的分布(更多计算用于如何得到答案,而非答案是什么)。我们预计,像o1这样的系统在涉及重用已知模拟推理模板(程序)的基准测试中表现会更好,但在需要即时合成全新推理的问题上仍会面临挑战。测试时间对CoT的精炼只能在一定程度上纠正推理错误。这也解释了为什么o1在某些领域如此出色。当基础模型以类似方式进行预训练时,测试时间对CoT的精炼会获得额外助力。总而言之,o1代表了从“记忆答案”到“记忆推理”的范式转变,但并未脱离通过拟合分布曲线以提升性能的广义范式。