在 RAG 应用中使用 Neo4j 和 LangChain 构建和检索知识图谱信息的实用指南

图片由DALL-E创作

图表搜索增强生成(GraphRAG)正在蓬勃发展,并成为传统向量搜索搜索方法的有力补充。这种方法利用图数据库的形态将数据组织为节点和关系,以增强搜索信息的深度和上下文。

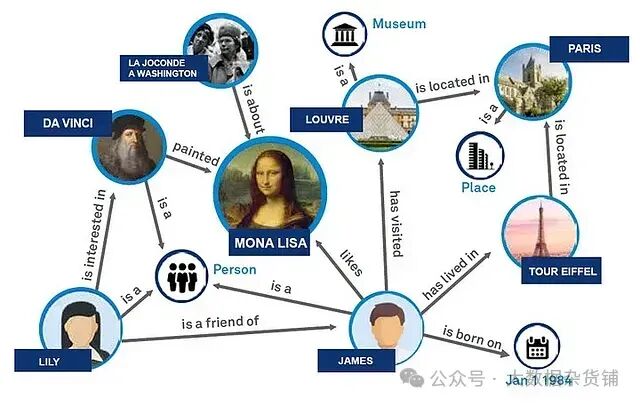

知识图谱示例

图表非常擅长通过结构化的方式表示和存储互连的信息,轻松获取不同数据类型之间的复杂关系和属性。相比之下,向量数据库通常难以处理这些结构化信息,因为它们的优势在于通过高维处理非格式化数据。在 RAG 应用程序中,您可以将结构化的图形数据与通过非结构化的文本进行向量搜索相结合,以实现两全其美。这就是我们将在这篇博文中演示的内容。

构建知识图谱通常是最棘手的步骤。它涉及收集和构建数据,这需要对领域和图形建模有深入的了解。

为了简化这个过程,我们一直在尝试大语言模型。借助对语言和上下文的深刻理解,大语言模型可以自动化知识图谱创建过程的重要部分。通过分析文本数据,这些模型可以识别实体、理解它们的关系,并建议如何在图形结构中最好地表示它们。

作为这些实验的结果,我们在 LangChain 中添加了第一个版本的图构建模块,我们将在这篇博文中进行演示。

该代码可在GitHub上获取。

您需要设置一个 Neo4j 实例。请按照本文中的示例进行操作。最简单的方法是在 Neo4j Aura上启动一个免费实例,它提供 Neo4j 数据库的云实例。或者,您还可以通过下载Neo4j 桌面应用程序并创建本地数据库实例来设置 Neo4j 数据库的本地实例。

Shell

os.environ["OPENAI_API_KEY"] = "sk-"

os.environ["NEO4J_URI"] = "bolt://localhost:7687"

os.environ["NEO4J_USERNAME"] = "neo4j"

os.environ["NEO4J_PASSWORD"] = "password"

graph = Neo4jGraph() |

另外,您必须提供OpenAI Key,因为我们将在本博文中使用他们的模型。

在本示例中,我们将使用Elizabeth I’s 维基百科页面。我们可以使用LangChain loaders从维基百科获取和分割文档。

Shell

# Read the wikipedia article

raw_documents = WikipediaLoader(query="Elizabeth I").load()

# Define chunking strategy

text_splitter = TokenTextSplitter(chunk_size=512, chunk_overlap=24)

documents = text_splitter.split_documents(raw_documents[:3]) |

是时候根据搜索到的文档构建图了。因此,我们实现了一个LLMGraphTransformer模块,可以显着简化在图数据库中构建和存储知识图。

Shell

llm=ChatOpenAI(temperature=0, model_name="gpt-4-0125-preview")

llm_transformer = LLMGraphTransformer(llm=llm)

# Extract graph data

graph_documents = llm_transformer.convert_to_graph_documents(documents)

# Store to neo4j

graph.add_graph_documents(

graph_documents,

baseEntityLabel=True,

include_source=True

) |

您可以定义使用哪个LLM知识图谱生成链。目前,我们仅支持 OpenAI 和 Mistral 的函数调用模型。但是,我们计划在未来扩展LLM的选择范围。在此示例中,我们使用最新的 GPT-4。请注意,生成的图的质量取决于您使用的模型。从理论上讲,您总是想使用最有能力的人。LLM图转换器返回图形文档,可以通过该方法将其add_graph_documents导入Neo4j。该baseEntityLabel参数为每个分配节点一个附加__Entity__标签,从而增强索引和查询性能。该include_source参数将节点链接到其原始文档,从而促进数据的可追溯性和上下文理解。

您可以在 Neo4j 浏览器中检查生成的图形。

生成的部分图

请注意,该图仅代表生成图的一部分。

图生成后,我们将使用混合搜索方法,将索引和关键字与 RAG 应用程序的图搜索相结合。

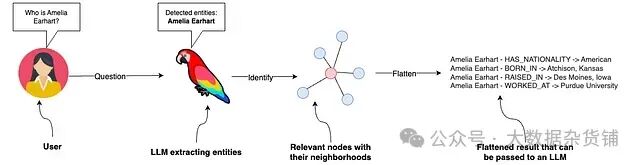

结合(提供+关键字)和图混合搜索方法。图片由作者提供

该图说明了搜索过程,从用户提出问题开始,然后将问题定向到 RAG 搜索器。该搜索器采用关键字和向量搜索来搜索非结构化文本数据,并将其与从知识图谱中收集的信息Neo4j 同时具有关键字索引和向量索引,因此您可以使用单个数据库系统实现所有三个搜索选项。从这些来源收集的数据将输入大语言模型以生成并提供最终答案。

您可以使用该Neo4jVector.from_existing_graph方法将关键字和支持搜索添加到文档中。此方法为混合搜索方法配置和支持搜索索引,以标记为的节点为目标Document。另外,如果文本嵌入值删除,它还会计算他们。

Shell

vector_index = Neo4jVector.from_existing_graph(

OpenAIEmbeddings(),

search_type="hybrid",

node_label="Document",

text_node_properties=["text"],

embedding_node_property="embedding"

) |

然后可以使用该similarity_search方法调用向量索引。

另一方面,配置图检索更加复杂,但提供了更多自由。此示例将使用全文索引来识别相关节点并返回它们的直接邻居。

图检索器。图片由作者提供

图检索器首先识别输入中的相关实体。为简单起见,我们指示大语言模型来识别人员、组织和地点。为了实现这一点,我们将使用LCEL和新添加的with_structured_output方法来实现这一点。

Shell

# Extract entities from text

class Entities(BaseModel):

"""Identifying information about entities."""

names: List[str] = Field(

...,

description="All the person, organization, or business entities that "

"appear in the text",

)

prompt = ChatPromptTemplate.from_messages(

[

(

"system",

"You are extracting organization and person entities from the text.",

),

(

"human",

"Use the given format to extract information from the following "

"input: {question}",

),

]

)

entity_chain = prompt | llm.with_structured_output(Entities) |

让我们测试一下:

Shell

entity_chain.invoke({"question": "Where was Amelia Earhart born?"}).names

# ['Amelia Earhart'] |

太好了,现在我们可以检测问题中的实体,让我们使用全文索引将它们映射到知识图谱。首先,我们需要定义一个全文索引和一个函数,该函数将生成允许一些拼写错误的全文查询,这里我们不会详细介绍。

Shell

graph.query(

"CREATE FULLTEXT INDEX entity IF NOT EXISTS FOR (e:__Entity__) ON EACH [e.id]")

def generate_full_text_query(input: str) -> str:

"""

Generate a full-text search query for a given input string.

This function constructs a query string suitable for a full-text search.

It processes the input string by splitting it into words and appending a

similarity threshold (~2 changed characters) to each word, then combines

them using the AND operator. Useful for mapping entities from user questions

to database values, and allows for some misspelings.

"""

full_text_query = ""

words = [el for el in remove_lucene_chars(input).split() if el]

for word in words[:-1]:

full_text_query += f" {word}~2 AND"

full_text_query += f" {words[-1]}~2"

return full_text_query.strip() |

现在让我们把它们放在一起。

Shell

# Fulltext index query

def structured_retriever(question: str) -> str:

"""

Collects the neighborhood of entities mentioned

in the question

"""

result = ""

entities = entity_chain.invoke({"question": question})

for entity in entities.names:

response = graph.query(

"""CALL db.index.fulltext.queryNodes('entity', $query, {limit:2})

YIELD node,score

CALL {

MATCH (node)-[r:!MENTIONS]->(neighbor)

RETURN node.id + ' - ' + type(r) + ' -> ' + neighbor.id AS output

UNION

MATCH (node)<-[r:!MENTIONS]-(neighbor)

RETURN neighbor.id + ' - ' + type(r) + ' -> ' + node.id AS output

}

RETURN output LIMIT 50

""",

{"query": generate_full_text_query(entity)},

)

result += "\n".join([el['output'] for el in response])

return result |

该structured_retriever函数首先检测用户问题中的实体。接下来,它迭代检测到的实体并使用 Cypher 模板来检索相关节点的邻域。我们来测试一下吧!

Shell

print(structured_retriever("Who is Elizabeth I?"))

# Elizabeth I - BORN_ON -> 7 September 1533

# Elizabeth I - DIED_ON -> 24 March 1603

# Elizabeth I - TITLE_HELD_FROM -> Queen Of England And Ireland

# Elizabeth I - TITLE_HELD_UNTIL -> 17 November 1558

# Elizabeth I - MEMBER_OF -> House Of Tudor

# Elizabeth I - CHILD_OF -> Henry Viii

# and more... |

正如一开始提到的,我们将结合非结构化和图形检索器来创建传递给 LLM 的最终上下文。

Shell

def retriever(question: str):

print(f"Search query: {question}")

structured_data = structured_retriever(question)

unstructured_data = [el.page_content for el in vector_index.similarity_search(question)]

final_data = f"""Structured data:

{structured_data}

Unstructured data:

{"#Document ". join(unstructured_data)}

"""

return final_data |

当我们处理 Python 时,我们可以使用 f 字符串简单地连接输出。

我们已经成功实现了 RAG 的检索组件。接下来,我们引入一个提示,利用集成混合检索器提供的上下文来生成响应,从而完成 RAG 链的实现。

Shell

template = """Answer the question based only on the following context:

{context}

Question: {question}

"""

prompt = ChatPromptTemplate.from_template(template)

chain = (

RunnableParallel(

{

"context": _search_query | retriever,

"question": RunnablePassthrough(),

}

)

| prompt

| llm

| StrOutputParser()

) |

最后,我们可以继续测试我们的混合 RAG 实现。

Shell

chain.invoke({"question": "Which house did Elizabeth I belong to?"})

# Search query: Which house did Elizabeth I belong to?

# 'Elizabeth I belonged to the House of Tudor.' |

我还集成了查询重写功能,使 RAG 链能够适应允许后续问题的对话设置。鉴于我们使用向量和关键字搜索方法,我们必须重写后续问题以优化我们的搜索过程。

Shell

chain.invoke(

{

"question": "When was she born?",

"chat_history": [("Which house did Elizabeth I belong to?", "House Of Tudor")],

}

)

# Search query: When was Elizabeth I born?

# 'Elizabeth I was born on 7 September 1533.' |

您可以观察到它When was she born?首先被重写为When was Elizabeth I born?.然后使用重写的查询来检索相关上下文并回答问题。

随着 引入LLMGraphTransformer,生成知识图谱的过程现在应该更加流畅且更容易访问,让任何希望利用知识图提供的深度和上下文来增强 RAG 应用程序的人变得更加容易。这只是一个开始,我们计划了很多改进。

该代码可在GitHub上获取。