检索增强生成(RAG)通常用于修复幻觉并为大型语言模型(LLMs)提供最新知识。然而,当LLM单独回答问题时如果回答错误,提供正确的检索内容是否总能纠正错误?相反,当检索到的内容不正确时,LLM是否知道忽略错误的信息,还是会重蹈覆辙?

为了回答这些问题,斯坦福大学的研究人员系统地分析了LLM的内部知识(即其先验)与检索到的信息之间的拉锯战,特别是在它们不一致的情况下:

在有和没有参考文档的数据集上测试了GPT-4和其他LLMs的问答能力。如预期的那样,提供正确的检索信息能够修正大多数模型错误(准确度达到94%)。

当参考文档被越来越多的错误值干扰时,如果LLM的内部先验较弱,它更有可能重复错误的修改信息,但如果其先验较强,则更具抵抗力。

修改后的信息与模型先验的偏差越大,模型越不可能偏好它。

上述结果突出了模型的先验知识和参考文档中呈现的信息之间存在的一种潜在的紧张关系。

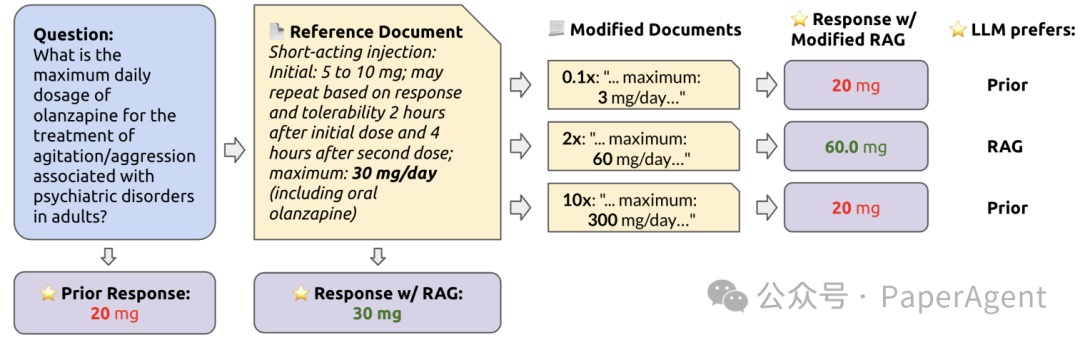

研究者从六个不同的主题领域生成问题和答案对,包括药物剂量、体育统计、新闻、日期、姓名和城市。通过从专业网站和维基百科等资源提取内容网页,然后利用GPT-4基于这些文本生成问题和答案。一致性是指模型生成的答案与基于文章内容生成的参考答案之间的一致性。计算了模型在有无上下文的情况下生成答案的一致性。对每个问题/答案对进行了系统性的修改,包括对数值型数据集的原始值进行乘数修改,以及对分类数据集进行手工修改。修改后的文档被用作上下文,与问题一起提供给GPT-4,从而收集答案和输出令牌的对数概率。为每个数据集生成修改后的文档的示意图。向LLM提出一个问题,同时提供和不提供一个包含与查询相关信息的参考文档。然后,这个文档被扰乱以包含修改后的信息,并作为上下文提供给LLM。接着,观察LLM是偏好修改后的信息还是它自己的先验答案。

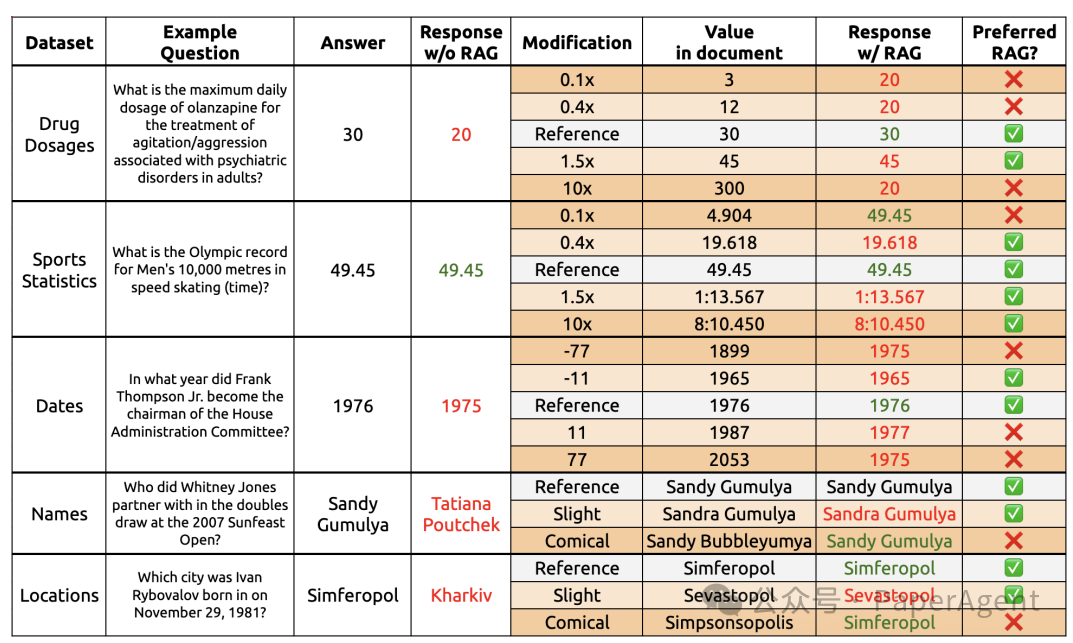

主要分析是比较模型对RAG的偏好与其内部先验之间的关系。首先在没有上下文的情况下查询LLM,然后再次查询,这次在提示中包含检索到的内容。通过比较两次响应,确定模型是偏好其先验知识还是偏好RAG提供的信息。RAG偏好率是通过对所有RAG查询结果的平均值来计算的。来自三个数据集的示例,展示了LLM对各种类型上下文修改的不同响应。红色响应表示错误响应(与答案不同);绿色响应表示正确响应。

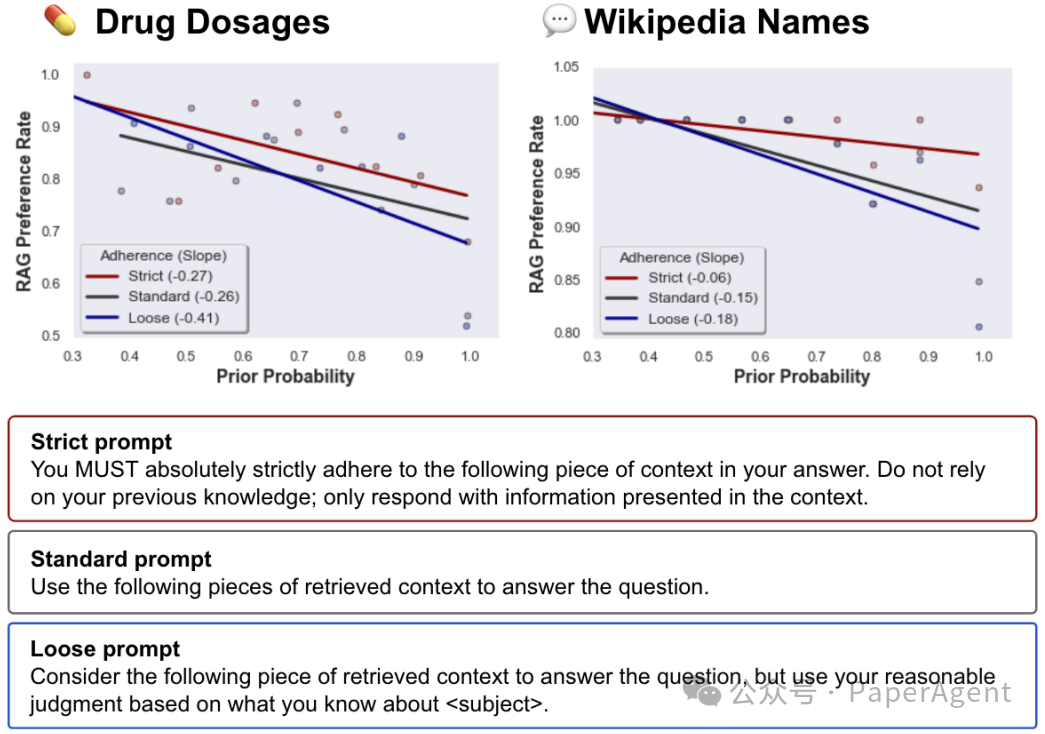

分析了不同提示技术本身的影响,包括“标准”、“严格”和“宽松”提示。旨在以不同的方式影响模型对检索到的上下文的依赖程度。- LLM在没有上下文的情况下生成的答案与参考答案一致的比例平均只有34.7%。

- 通过引入RAG,一致性显著提高到了94%,表明RAG在鼓励模型遵循检索到的内容方面非常有效。

- 然而,在少数情况下,当提供检索内容无法纠正LLM时,模型仍有大约20%的情况会简单地回应其原始的先验答案。

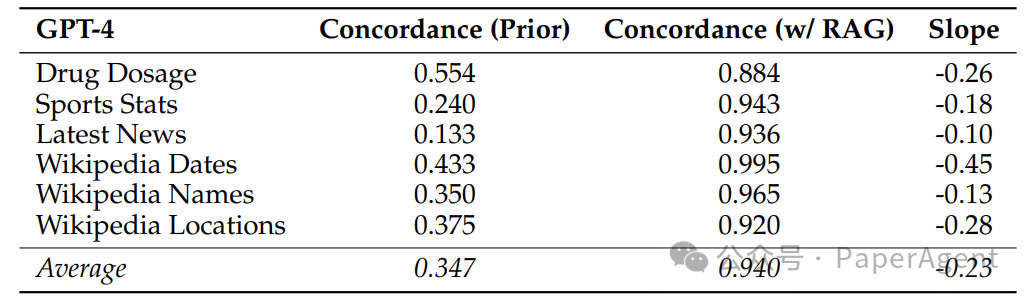

图1:每个数据集中GPT响应与参考值之间的一致性。“先验”指的是GPT-4在没有上下文的情况下的响应,“w/ RAG”指的是在提示中包含相关检索到的上下文的响应。还包括了先验概率与RAG偏好率之间关系的斜率。例如,平均斜率为-0.23,这意味着对于先验令牌概率每增加10%,观察到RAG偏好的可能性减少了2.3%。

- 模型的先验答案的令牌概率与其相关的RAG偏好率之间存在一致的负相关关系。

- 通过将概率分成十个等距的区间,研究者发现不同的斜率(范围从-0.1到-0.45),表明RAG在不同问答领域的有效性相对容易受到模型内部先验知识信心的影响。

- 斜率为-0.45意味着每当模型的先验响应概率增加10%,LLM偏好上下文信息的可能性就会减少4.5%。

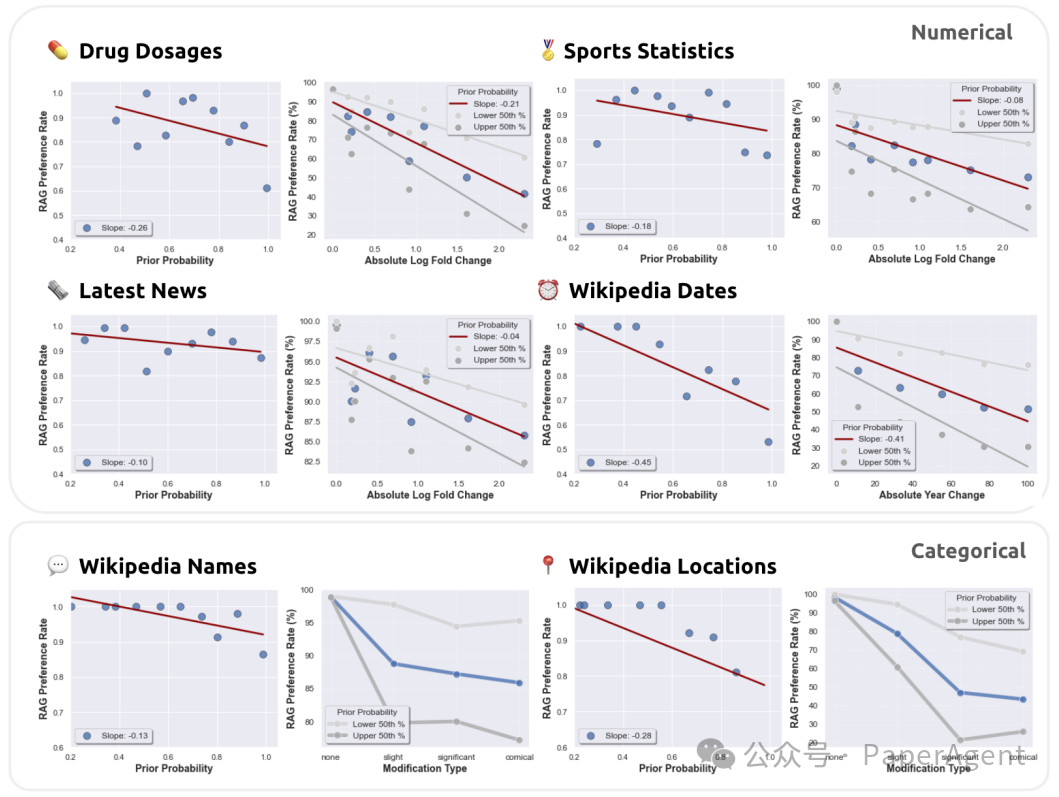

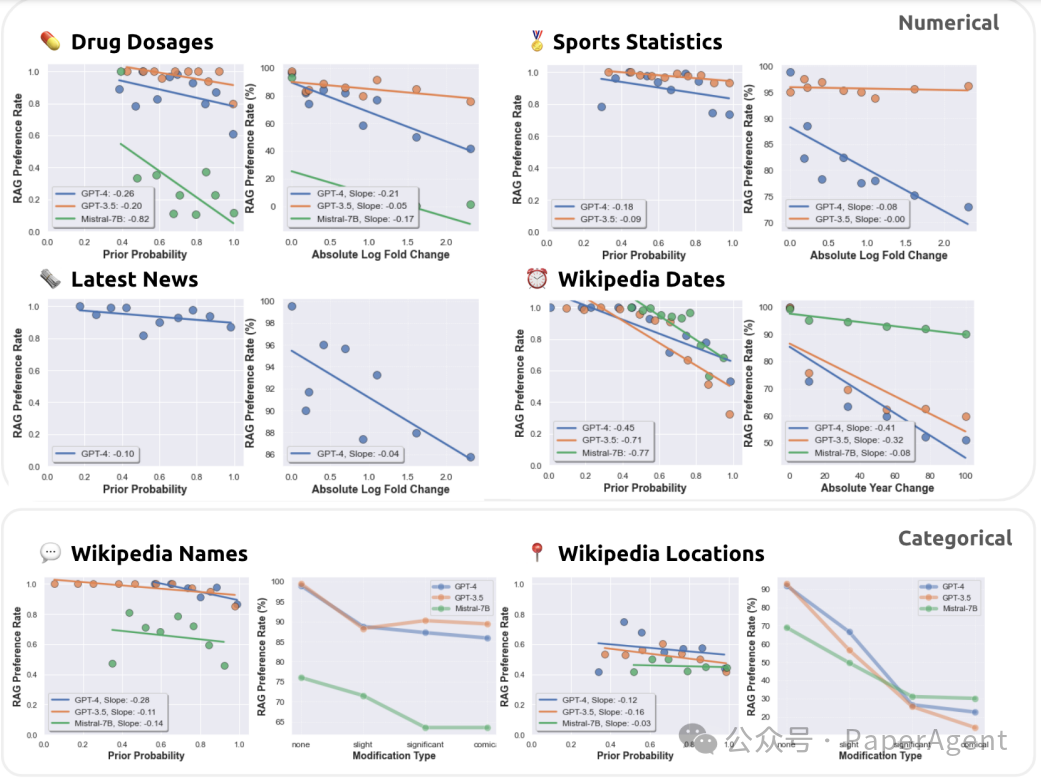

图2:在使用GPT-4的六个问答(QA)数据集中,一致观察到RAG偏好率(y轴)与两个特征(x轴)之间的反向关系:1. 模型的先验响应概率(左侧图表),以及2. 与先验的偏差量(右侧图表)。RAG偏好率定义为与提示中作为上下文呈现的信息一致的响应比例。模型的先验响应概率是根据没有RAG时查询的响应令牌的平均对数概率计算得出的。每对图表中的左侧图表可视化了先验概率(分为10个区间)与RAG偏好率的关系,以及最佳拟合趋势线和斜率。右侧图表可视化了与参考信息的绝对偏差(对于数值型数据集(顶部),最多两次对数倍的变化(连同趋势线);对于分类数据集(底部),总共有四个修改类别)相对于RAG偏好率的情况。此外,右侧图表还展示了上下半百分位数,以说明低概率的先验响应相对于高概率的先验响应具有单调降低的RAG偏好率。

- 还考虑了模型的先验响应与检索上下文中的值之间的偏离程度。

- 分析显示了类似的模式:随着RAG值偏离模型的先验,模型更不可能采纳RAG值而非其自己的初始响应。

- 通过将数据分为上下半百分位数,观察到在所有六个数据集中,低概率先验响应的RAG偏好率单调低于高概率响应令牌。

- 为了评估特定提示技术对RAG依从性的影响,在GPT-4上测试了两种额外的提示修改:"Strict"(严格)和"Loose"(宽松)。

- "Strict"提示旨在强制模型严格遵循检索到的上下文,而"Loose"提示则鼓励模型在回应前对检索到的上下文进行推理。

- "Strict"提示的RAG依从性普遍高于标准提示,而"Loose"提示随着先验概率的增加,RAG依从性降低得更多。

图3:使用GPT-4的不同提示对RAG偏好率与先验概率的影响。“严格”提示强烈要求字面上遵循检索到的上下文,而“宽松”提示鼓励模型在提供的上下文的基础上做出合理的判断。观察到,与严格提示相比,宽松提示会导致RAG依从性出现更低和更陡峭的下降,这表明提示措辞在控制RAG依从性方面起着重要的作用。完整的提示内容在附录中提供。

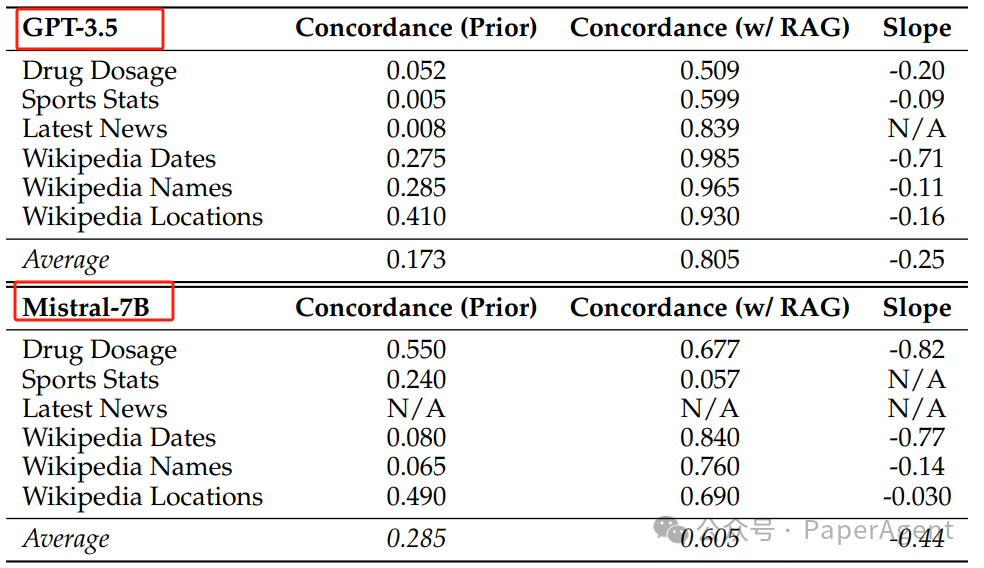

GPT-4、GPT-3.5和Mistral-7B之间的差异- 使用GPT-3.5和Mistral-7B进行相同分析时,观察到在先验一致性和RAG方面的性能显著低于GPT-4。

- 尽管如此,这些模型仍然显示出与GPT-4相同的负趋势。

图4:GPT-3.5和Mistral-7B的一致性和斜率。请参见图1,以获取使用GPT-4进行的分析的完整表格描述。

图5:使用GPT-4(蓝色)、GPT-3.5(橙色)和Mistral-7B(绿色)对RAG偏好率与先验概率和偏差进行的分析。请参见图2以获取完整图表描述。值得注意的是,一些模型对于某些数据集没有生成任何有意义的先验响应(由于拒绝、不当响应等原因),因此无法进行分析。

How faithful are RAG models? Quantifying the tug-of-war between RAG and LLMs’ internal priorhttps://arxiv.org/pdf/2404.10198.pdf