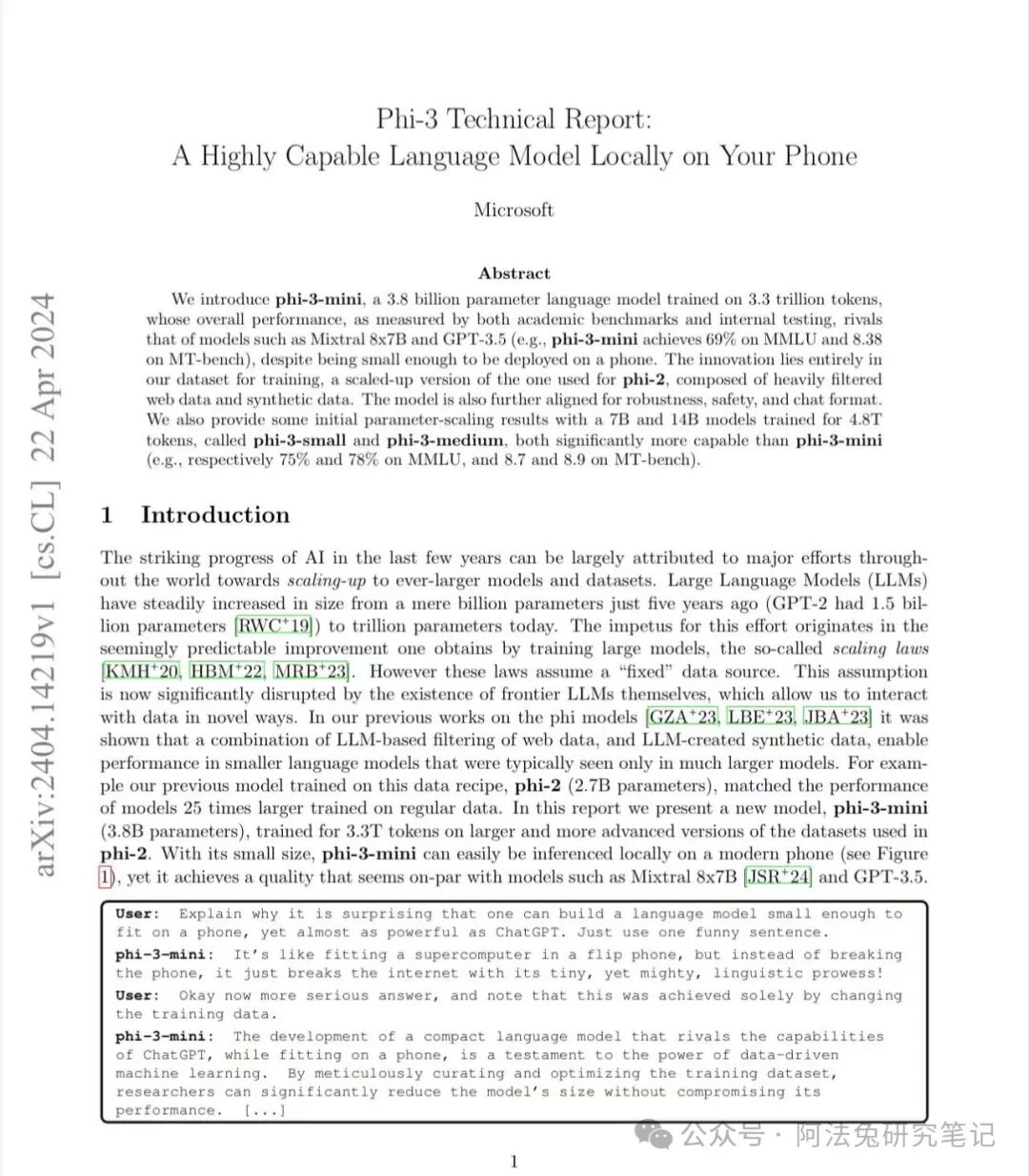

刚才,微软推出轻量级人工智能(AI)模型的下一代,名为Phi-3,新系列包括38亿参数的Phi-3 Mini、70亿参数的Phi-3 Small和140亿参数的Phi-3 Medium。

这款新的38亿参数模型在使用的资源显著少于更大的语言模型的同时,改进了之前的Phi-2模型。据微软自己的基准测试,仅有38亿参数的Phi-3 Mini的性能超过了Meta的80亿参数Llama和OpenAI的35亿参数GPT-3。由于体积较小,与较大模型相比,Phi-3系列更适用于低功耗设备。微软副总裁Boyd 表示,新模型能够直接在智能手机上进行高级自然语言处理。这使得Phi-3 Mini非常适合需要AI协助的新颖应用。虽然Phi-3 Mini在其重量级别中表现优于竞争对手,但它无法与在互联网上训练的庞大模型的知识广度相匹敌。然而,Boyd 指出,较小的高质量模型往往表现更好,因为内部数据集的规模通常更有限。“phi-3-mini,一款在3.3万亿个token上训练的38亿参数语言模型,其总体性能根据学术基准和内部测试,与诸如Mixtral 8x7B和GPT-3.5等模型相媲美(例如,phi-3-mini在MMLU上达到69%,在MT-bench上达到8.38),尽管其足够小,可以部署在手机上。微软还提供了一些初步的参数缩放结果,与为4.8万亿token训练的7B和14B模型phi-3-small和phi-3-medium相比,这两者的能力都显著高于phi-3-mini(例如,分别在MMLU上达到75%和78%,在MT-bench上达到8.7和8.9)。”2023年12月,微软发布了 Phi-2,其性能与 Llama 2 等更大的模型一样好。微软表示,Phi-3 的性能比之前的版本更好,并且可以提供接近于比其大 10 倍的模型的响应。微软 Azure AI 平台公司副总裁 Eric Boyd 指出,Phi-3 Mini 与 GPT-3.5 等 LLM 一样强大,“只是更小”。与常规的大语言模型相比,小型人工智能模型通常运行成本更低,并且在手机和笔记本电脑等个人设备上表现更好。据《The Information》今年早些时候报道,微软正在组建一个专门专注于轻量级人工智能模型的团队。与 Phi 一起,该公司还构建了 Orca-Math,一个专注于解决数学问题的模型。微软的竞争对手也有自己的小型人工智能模型,其中大多数针对更简单的任务,例如文档摘要或辅助编程。Google 的 Gemma 2B 和 7B 非常适合简单的聊天机器人和语言相关的工作。Anthropic 的 Claude 3 Haiku 可以阅读带有图表的密集研究论文并快速总结它们,而 Meta 最近发布的 Llama 3 8B 可以用于一些聊天机器人和编程辅助。Boyd 表示,开发人员通过“课程”对 Phi-3 进行了培训。他们的灵感来自于孩子们如何从睡前故事、单词更简单的书籍以及谈论更大主题的句子结构中学习。“市面上没有足够的儿童读物,所以我们列出了 3,000 多个单词的清单,并要求大模型制作‘儿童读物’来教 Phi,”Boyd 说。Phi-3 只是建立在之前迭代所学到的知识之上。Phi-1 专注于编程,Phi-2 开始学习推理,而 Phi-3 更擅长编程和推理。虽然 Phi-3 系列模型了解一些常识,但它无法在广度上击败 GPT-4 或其他 LLM — 从受过整个互联网培训的 LLM 获得的答案与从受过整个互联网培训的 LLM 获得的答案有很大差异。较小的模型,如 Phi-3。微软发现,像 Phi-3 这样的较小模型更适合他们的定制应用程序,因为对于许多公司来说,他们的内部数据集无论如何都会较小。由于这些模型使用较少的计算能力,因此它们通常成本更低。