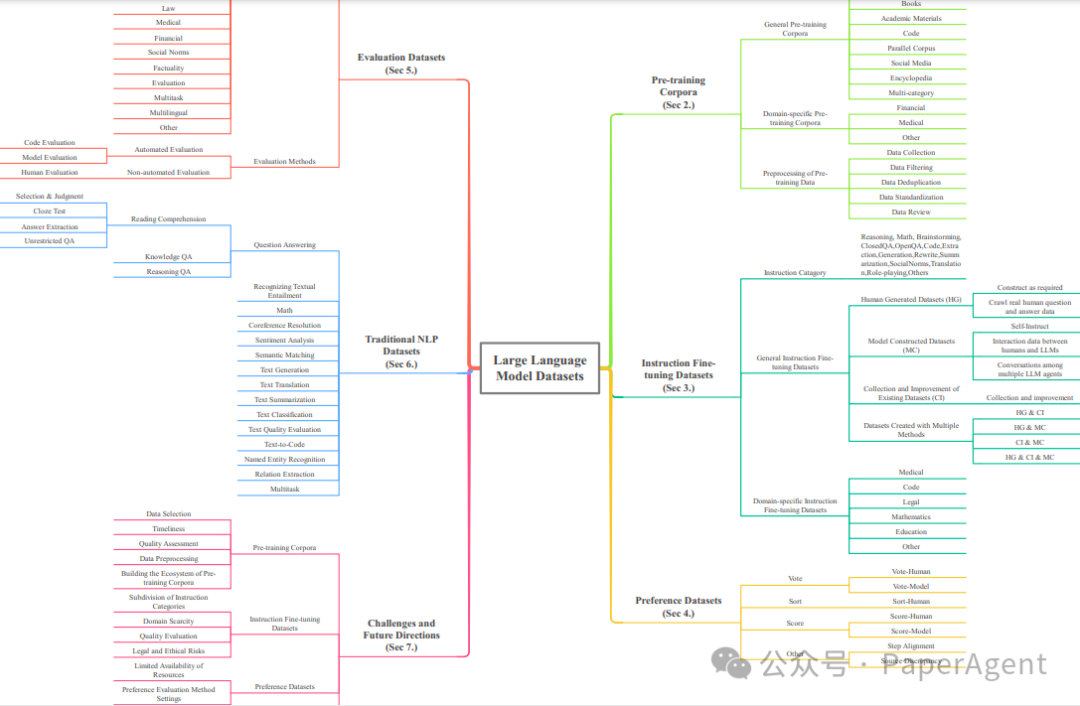

Datasets for Large Language Models: A Comprehensive Surveyhttps://arxiv.org/pdf/2402.18041.pdf

论文探索了大型语言模型(LLM)数据集,它们在LLM的显著进步中扮演着至关重要的角色。数据集作为基础架构,类似于根系,支撑并培育LLM的发展。因此,对这些数据集的审查成为研究中的关键话题。为了解决目前缺乏对LLM数据集全面概述和深入分析的问题,并洞察它们的现状和未来趋势,从五个角度整合和分类了LLM数据集的基本方面:

(1)预训练语料库;

(2)指令微调数据集;

(3)偏好数据集;

(4)评估数据集;

(5)特定任务:传统的自然语言处理(NLP)数据集。

本篇综述的整体架构

论文还提供了现有可用数据集资源的全面回顾,包括来自444个数据集的统计数据,涵盖8种语言类别,跨越32个领域。从20个维度的信息被纳入数据集统计。调查的总数据量超过774.5 TB的预训练语料库和7亿实例的其他数据集。旨在呈现LLM文本数据集的整体景观,为该领域的研究人员提供全面的参考,并为未来的研究做出贡献。

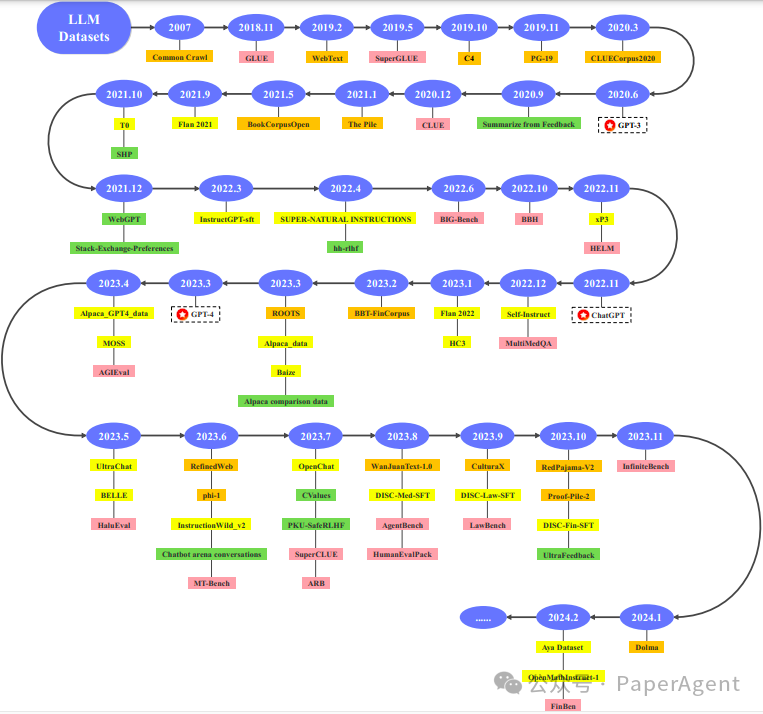

一些代表性的大型语言模型(LLM)数据集的时间线。橙色代表预训练语料库,黄色代表指令微调数据集,绿色代表偏好数据集,粉色代表评估数据集

一、预训练语料库

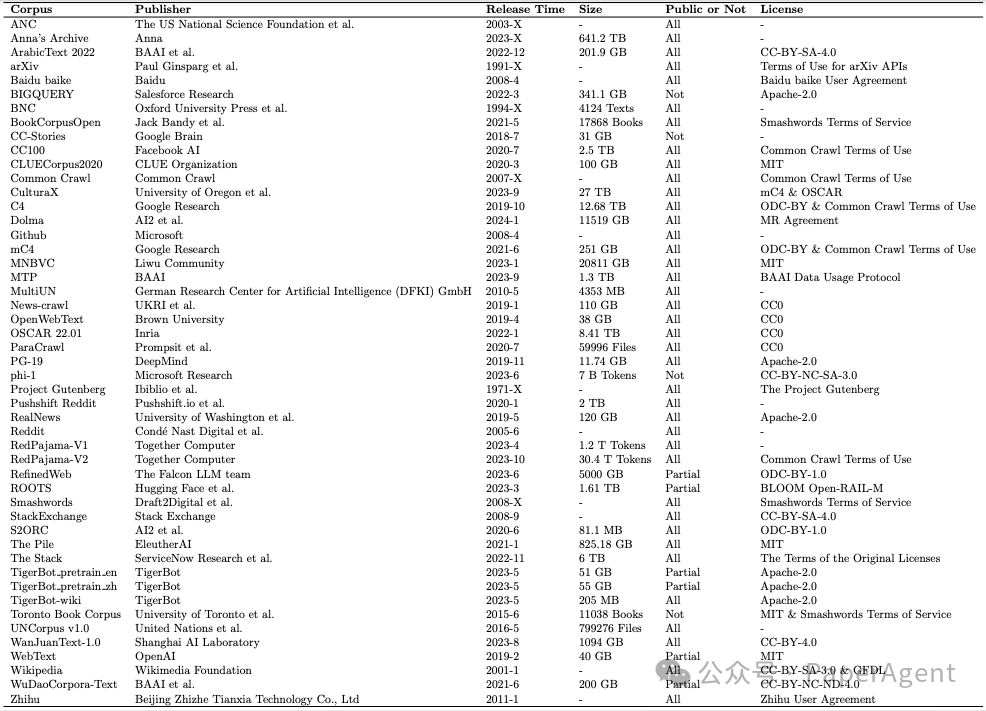

预训练语料库是在大型语言模型(LLM)预训练过程中使用的大量文本数据集合。在所有类型的数据集中,预训练语料库的规模通常是最大的。在预训练阶段,LLM从大量未标记的文本数据中学习广泛的知识,这些知识随后被存储在其模型参数中。这使得LLM具备了一定程度的语言理解和生成能力。预训练语料库可以包含各种类型的文本数据,如网页、学术材料、书籍,同时也包括来自不同领域的相关文本,例如法律文件、年度财务报告、医学教科书以及其他特定领域的数据。根据预训练语料库涉及的领域,它们可以分为两种类型:第一种是通用预训练语料库,它包括来自不同领域和主题的大规模文本数据混合。数据通常包括来自互联网的文本内容,如新闻、社交媒体、百科全书等。其目标是为自然语言处理(NLP)任务提供通用的语言知识和数据资源。通用预训练语料库分类:网页、语言文本、书籍、学术材料、代码、平行语料库、社交媒体和百科全书。

通用预训练语料库信息部分总结。发布时间:“X”表示未知月份。公开与否:“All”表示完全开源;“Partial”表示部分开源;“Not”表示不开源。“许可证”表示该语料库遵循某种协议。如果该语料库是基于其他语料库构建的,那么源语料库的许可证也必须遵守。

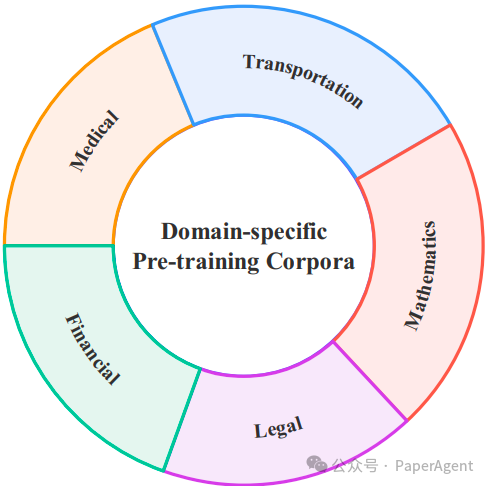

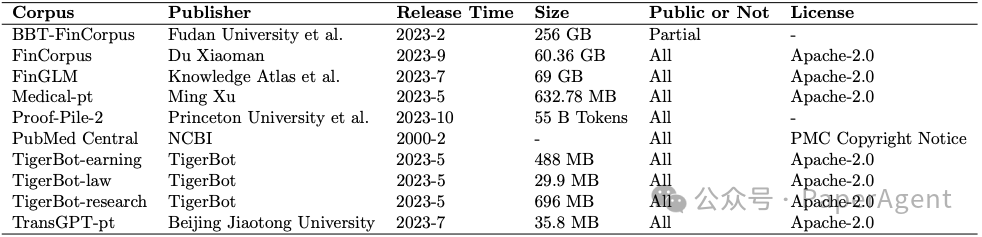

第二种是特定领域的预训练语料库,它专门包含特定领域或主题的相关数据。其目的是为LLM提供专业知识。特定领域预训练语料库分类:金融、医疗、法律、交通、数学。 特定领域预训练语料库信息总结。公开与否:“All”表示完全开源;“Partial”表示部分开源。“许可证”表示该语料库遵循某种协议。如果该语料库是基于其他语料库构建的,那么源语料库的许可证也必须遵守。

特定领域预训练语料库信息总结。公开与否:“All”表示完全开源;“Partial”表示部分开源。“许可证”表示该语料库遵循某种协议。如果该语料库是基于其他语料库构建的,那么源语料库的许可证也必须遵守。

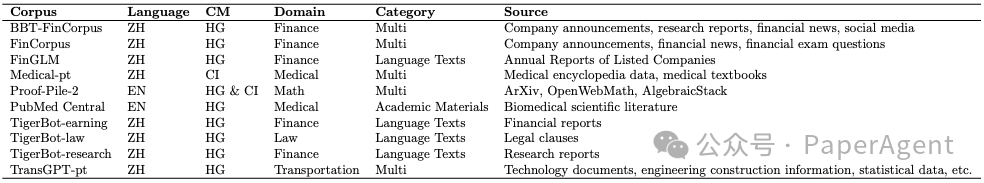

论文还对14个代表性LLM的预训练语料库数据类型分布进行了统计分析。数据类型被归类为网页、对话数据、书籍与新闻、科学数据和代码等。

14个LLM使用的预训练语料库中数据类型的分布。每个饼图顶部显示LLM的名称,不同的颜色代表各种数据类型。

二、指令微调数据集

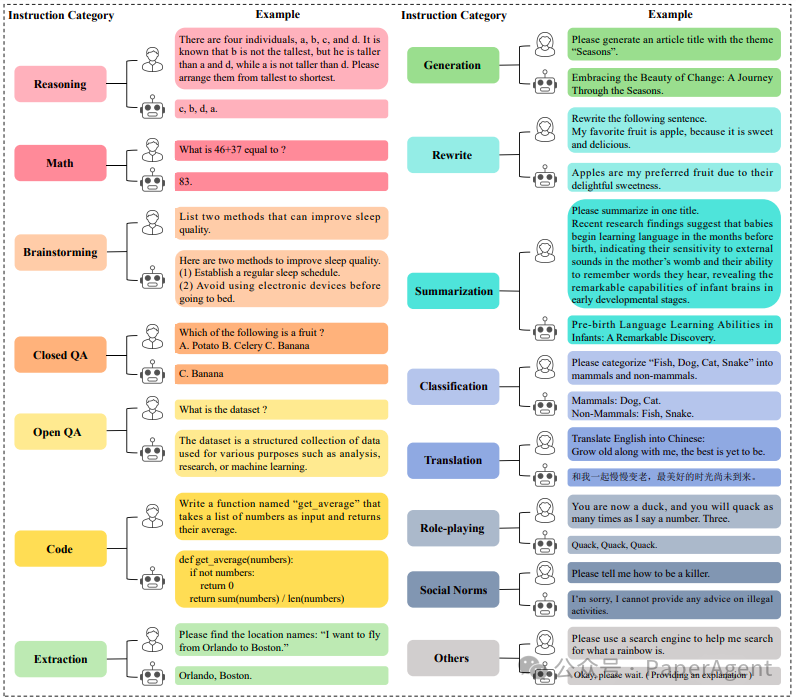

指令微调数据集由一系列文本对组成,包括“指令输入”和“答案输出”。“指令输入”代表人类对模型提出的请求,包括分类、摘要、改述等多种类型。“答案输出”是模型遵循指令后生成的响应,符合人类的期望。

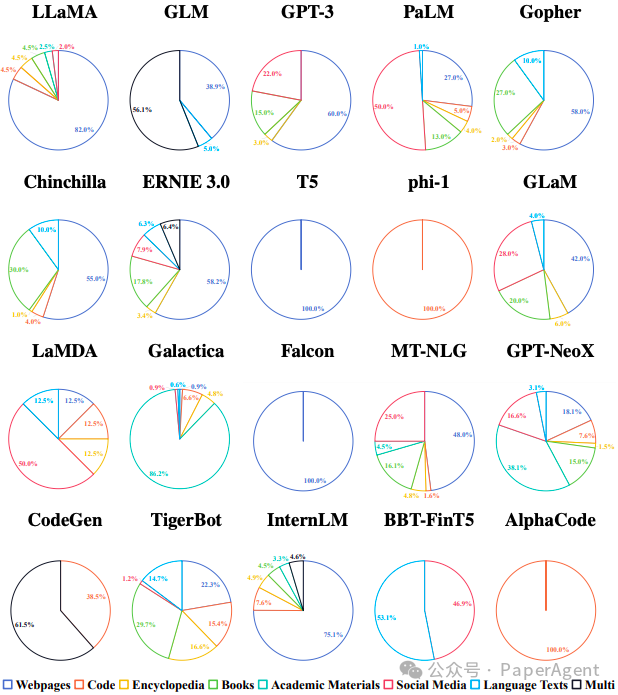

构建指令微调数据集有四种方式:(1)手动创建(2)模型生成,例如使用Self-Instruct方法(3)收集和改进现有的开源数据集,以及(4)上述三种方法的结合。

指令微调数据集用于进一步微调预训练的LLM,使模型更好地理解和遵循人类指令。这个过程有助于缩小LLM的下一个词预测目标与遵循人类指令的目标之间的差距,从而增强LLM的能力和可控性。指令微调数据集可以分为两个主要类别:通用指令微调数据集和特定领域指令微调数据集。通用指令微调数据集包含多个领域的各种类型指令,旨在提高模型在广泛任务中的性能。通过微调,LLM可以更好地遵循通用指令。在特定领域指令微调数据集中,指令是专门为特定领域设计的。例如,医疗指令使模型能够学习和执行医疗诊断和医疗协助等任务。15个细分指令类别的总结:推理、数学、头脑风暴、封闭问答、开放问答、编码、提取、生成、重写、摘要、分类、翻译、角色扮演、社交规范以及其他。

三、偏好数据集

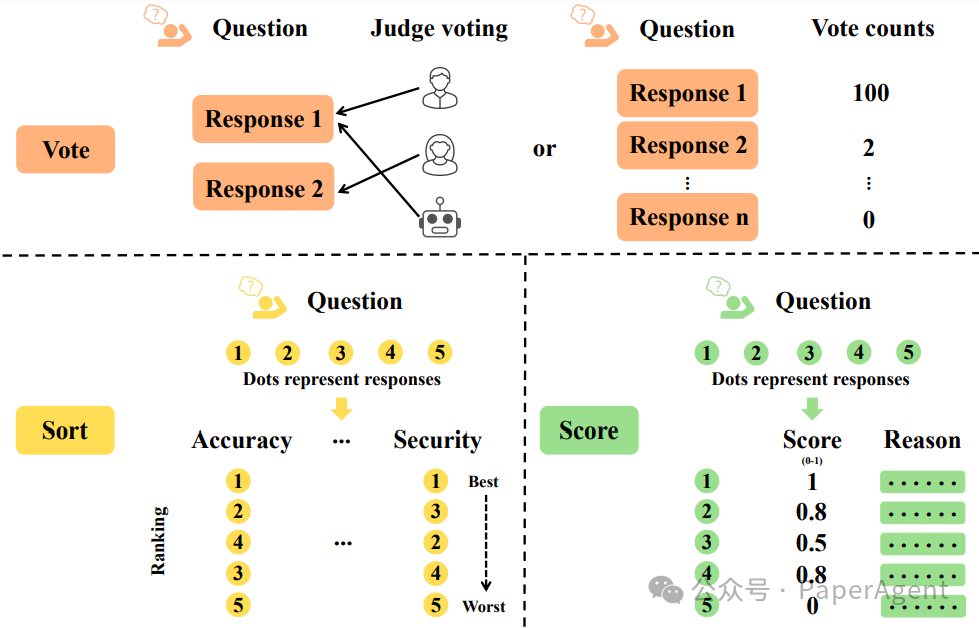

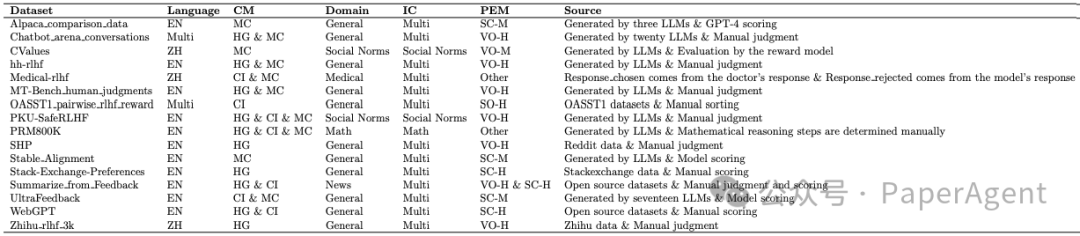

偏好数据集是一系列指令的集合,用于对同一指令输入的多个响应提供偏好评估。通常,它们由具有不同响应的指令对组成,以及来自人类或其他模型的反馈。这种设置反映了在给定任务或上下文中,人类或模型对不同响应的相对偏好。偏好数据集中的反馈信息通常通过投票、排序、评分或其他形式的比较表现出来。

不同的偏好评估方法的原理示意

偏好数据集主要用于大型模型的对齐阶段,旨在帮助使模型的输出更紧密地与人类偏好和期望对齐。与人类偏好的对齐体现在三个方面:实用性,即遵循指令的能力;诚实性,避免编造;安全性,避免生成非法或有害信息。RLHF和RLAIF(从AI反馈中学习的强化学习)都采用强化学习方法,使用反馈信号来优化模型。除了使用指令数据集进行微调外,还可以使用偏好数据集训练奖励模型。随后,可以根据奖励模型的反馈应用近端策略优化(PPO)算法进行进一步微调。

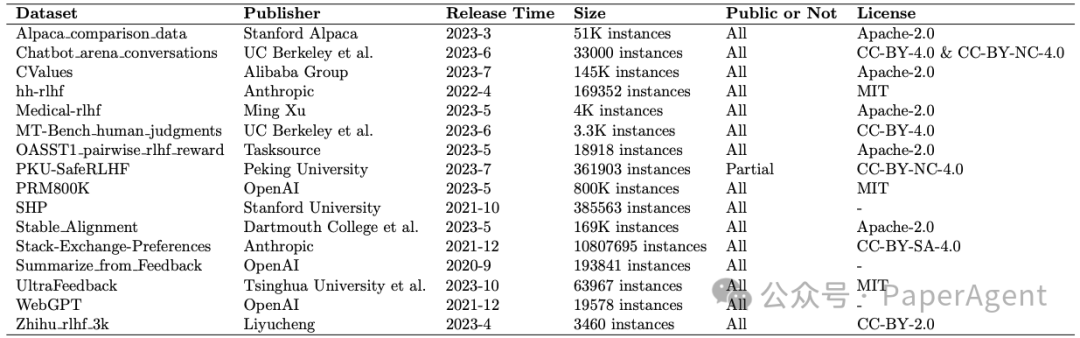

偏好数据集信息的总结。公开与否:“All”表示完全开源;“Partial”表示部分开源。“许可证”表示该数据集遵循某种协议。如果该数据集是基于其他数据集构建的,那么源数据集的许可证也必须遵守。

四、评估数据集

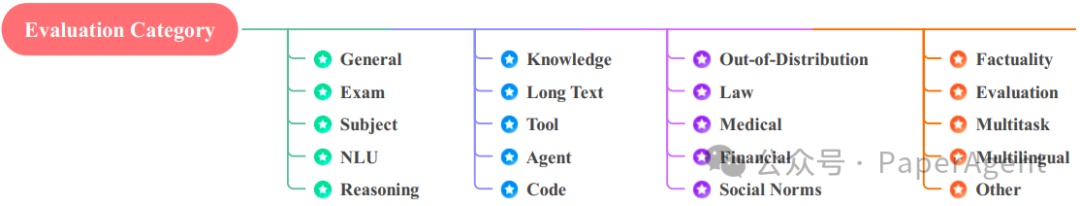

评估数据集是一组经过精心策划和注释的数据样本,用于评估LLM在各种任务上的表现。不同的评估数据集关注不同的评估方面,为不同模型提供客观的衡量标准。仅通过调整训练条件,包括预训练语料库、指令微调数据集和偏好数据集,LLM在相应评估数据集上的表现可以间接反映数据集的质量和有效性。这反过来有助于持续优化训练数据。112个评估数据集的20个评估类别:通用、考试、学科、自然语言理解(NLU)、推理、知识、长文本、工具、代理、代码、OOD(Out-Of-Distribution,分布外)、法律、医疗、金融、社交规范、事实性、评估、多任务、多语言以及其他。

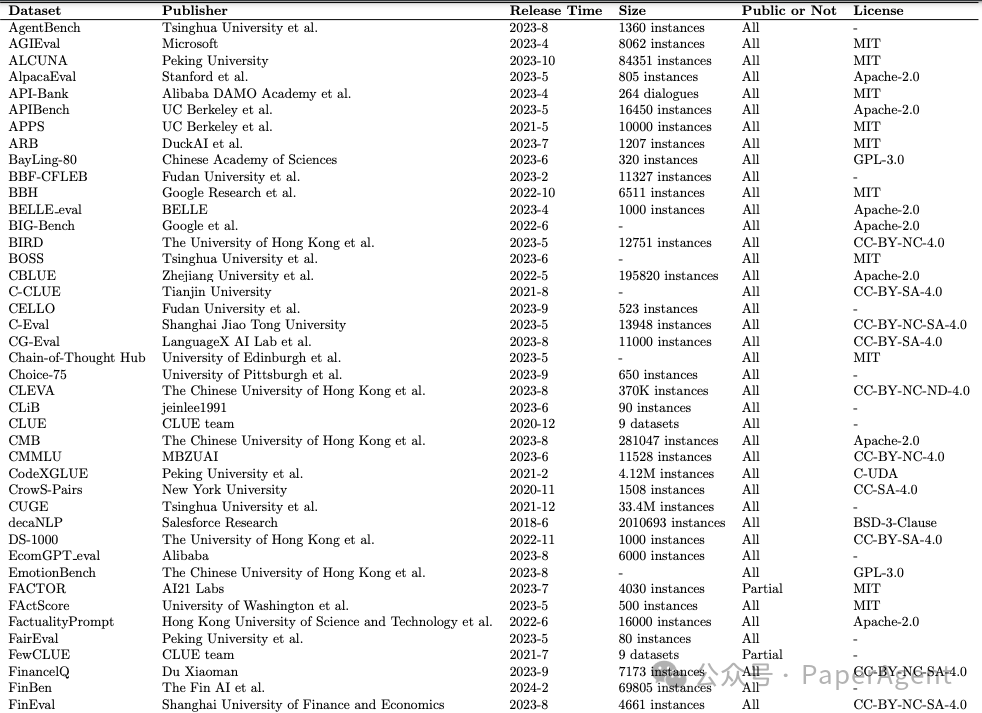

评估数据集信息的总结。公开与否:“All”表示完全开源;“Partial”表示部分开源;“Not”表示不开源。“许可证”表示该数据集遵循某种协议。如果该数据集是基于其他数据集构建的,那么源数据集的许可证也必须遵守。

五、特定任务:传统的自然语言处理(NLP)数据集

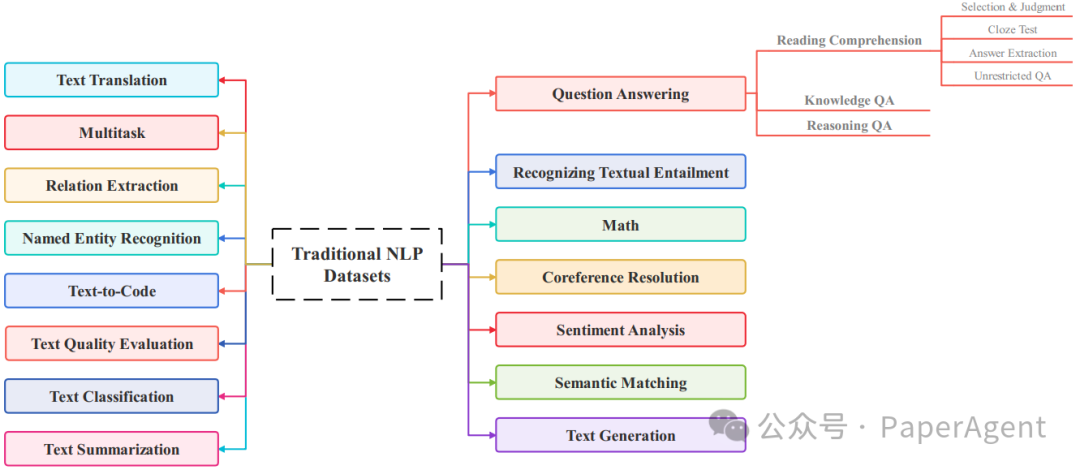

与传统的指令微调数据集不同,将专门用于自然语言任务的文本数据集,在LLM广泛采用之前,归类为传统NLP数据集。这些数据集没有指令格式,专门为训练、优化和测试传统NLP模型而精心设计。由此产生的NLP模型应用于多种文本处理任务,包括文本分类、信息提取、文本摘要等。在当代LLM项目中,大量的传统NLP数据集得到应用。这些数据集扮演双重角色:首先,它们的格式和内容转变为LLM指令引导微调阶段的指令格式,增强模型遵循指令和在这些任务中表现出色;其次,它们作为LLM的评估数据集,使得可以比较不同LLM在自然语言任务上的表现。传统NLP数据集被系统地分类为15个不同的类别,与各种任务相对应。这些类别包括:问答、识别文本蕴含、数学、共指解析、情感分析、语义匹配、文本生成、文本翻译、文本摘要、文本分类、文本质量评估、文本转代码、命名实体识别、关系提取和多任务。传统自然语言处理(NLP)数据集中不同的NLP任务类别

在人工智能的广阔领域中,大型语言模型(LLMs)作为迅速增长的显著特征脱颖而出——类似于密集森林中的参天大树。滋养它们成长和发展的数据集可以比作这些树木至关重要的根系,为它们的表现提供必不可少的养分。遗憾的是,当前与LLM相关的数据集景观广泛,各种类型的数据集之间缺乏统一的综合。理解LLM数据集的现状和未来趋势是一个巨大的挑战。因此,论文提供了对LLM数据集的全面分析,从五个维度对与LLM相关的数据集进行分类和总结:预训练语料库、微调指令数据集、偏好数据集、评估数据集和传统NLP数据集。除了这种分类,还确定了当前的挑战,并概述了未来数据集发展的潜在方向,涵盖四个关键领域:预训练、微调指令、强化学习和模型评估。这份综述能够成为学术界和工业界的研究人员,以及从事LLM的新手和熟练实践者的宝贵参考点。未来不断完善LLM数据集,促进一个健壮和标准化的数据集生态系统的发展,以及支持LLM的持续进步。