想象一下,你在一个巨大的迷宫里寻找出口,这个迷宫复杂到足以让最聪明的大脑也迷失方向。这个迷宫,就像是当今世界中的数据海洋,而找到出口的钥匙,就是AI。但是,要让AI真正发挥作用,我们需要一种特殊的“超级望远镜”,可以快速地、准确地穿透这个复杂的迷宫,找到隐藏在其中的宝藏。这个“望远镜”,就是我们今天要深入讨论的——GPU、ASIC ,以及基于此整个计算产业的变革。

在人工智能成为家喻户晓的技术之前,计算机科学界已经有了一个长久以来的好朋友——冯·诺依曼架构。这种架构由匈牙利数学家约翰·冯·诺依曼在上个世纪40年代提出,至今仍是大多数计算机系统的基础。在这个架构下,CPU扮演着绝对主角的角色,它负责读取并执行存储在内存中的指令。你可以将其想象为一位指挥家,指挥着计算机中的各种操作和处理任务。

然而,随着时间的推移,人们开始意识到这位老朋友在处理某些特定任务时,尤其是在人工智能领域,表现得并不尽如人意。原因在于,AI任务,特别是深度学习,需要大量的并行计算能力和数据处理能力。而传统的CPU设计更侧重于顺序执行任务,每次只能处理少量任务。这就好比是让一位厨师同时准备百桌宴会的餐点,虽然他技艺高超,但面对海量的工作量,效率自然大打折扣。

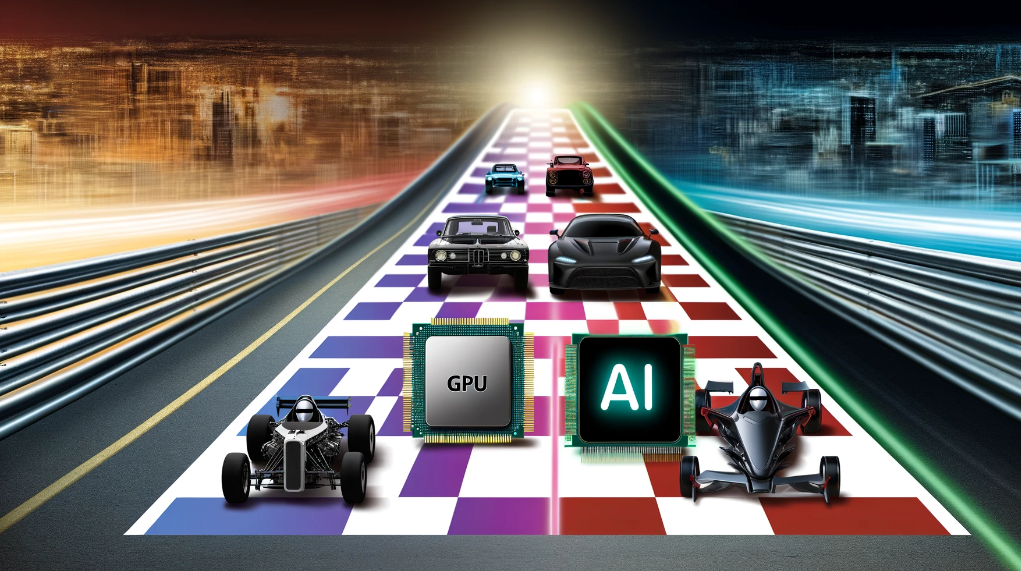

正是在这个背景下,智能计算架构应运而生,以满足日益增长的并行处理需求。在这个新的架构中,GPU(图形处理单元)和ASIC(应用特定集成电路)等硬件成为了新的明星。GPU最初被设计用于加速图形和视频处理,但其内部成百上千的核心能够同时处理大量数据,使其成为执行并行计算的理想选择。

ASIC则是为了满足特定应用需求而生的硬件解决方案,它们在执行某些特定类型的计算任务时,比通用硬件(如CPU或GPU)更加高效。在人工智能领域,比如谷歌的TPU(张量处理单元),就是一种专为深度学习任务设计的ASIC,其设计哲学是最大限度地提高特定任务的计算效率和速度。随着GPU和ASIC等硬件的发展,我们不仅见证了计算架构的革命,也看到了这些技术如何推动人工智能从理论走向实践的进程。这种设计哲学的转变,从注重通用计算能力转向满足特定计算需求的高效能,不仅加速了AI应用的研发和部署,也大大扩展了AI技术的应用场景。我们现在能够训练比以往任何时候都要复杂的模型,处理从自然语言处理到计算机视觉等多个领域的海量数据,这一切都得益于智能计算架构的进步。

那么,为什么现在GPU变得这么重要呢,以至于英伟达市值突破两万亿美元,是上一代霸主英特尔的10倍以上?这就要从人工智能和GPU的数据处理方式说起,来从更本质上来分析为什么GPU跟人工智能如此般配。在探讨为什么GPU特别适合AI任务之前,让我们先了解一下传统计算与智能计算在数据处理方式上的根本差异,以及并行处理能力为何如此重要。

传统的计算任务,比如文字处理或者网页浏览,往往依赖于线性处理流程。你可以把它想象成在厨房做饭:一步接一步,切完菜才能开始炒。这种方式在处理复杂任务时很有效,因为它保证了任务的顺序性和逻辑性。然而,当我们转向AI领域,比如图像识别或自然语言处理,数据处理的需求就完全不同了。这时,我们面对的是大量的数据需要同时分析,就像是要一次性照顾好厨房里的上百个炒锅,每个都要保证温度和时间恰到好处。

并行处理技术正是为了解决这类问题而生,与线性处理一步步来不同,它允许多个处理任务同时进行。这不仅大幅提高了处理速度,也极大地提升了效率。在AI任务中,这种能力是至关重要的,因为它们通常涉及到的数据量巨大,且需要在短时间内完成大规模的数据分析和处理。

GPU的内部结构是它适应并行处理的关键,不同于CPU通常只有几个核心,GPU拥有成百上千个核心,可以同时执行大量的运算任务。这就像是将一个巨大的办公室从只有几个工作人员变成了拥有成百上千个工作人员,每个人都在同时处理一个小任务,最终迅速完成整个项目。这种结构使得GPU在处理图像渲染、视频编辑等大量数据并行处理的任务时表现出色,而这正是AI领域中经常遇到的场景。

举个例子,深度学习中的一个关键步骤是训练神经网络,这涉及到大量的矩阵运算。在这个过程中,GPU的并行处理能力可以同时计算成千上万个神经元的输出,极大地加快了学习过程。这与CPU相比,后者在处理这类任务时可能需要更长的时间,因为它们更擅长于处理需要连续逻辑和高级决策的任务,而不是大规模的并行数据处理。

GPU之所以在AI任务,尤其是深度学习中表现出色,还在于它们对于矩阵和向量计算的高效率。深度学习算法大量依赖这类计算,GPU设计之初就考虑到了这一点,优化了相关的硬件和软件,以支持这些操作的高效执行。随着AI技术的发展,对计算资源的需求也在不断增长,GPU能够提供这种需求所必需的可扩展性和灵活性。

此外,GPU的发展促进了新的编程模型和算法的出现,这些都是专门为并行计算和高效率计算设计的。框架如英伟达的CUDA,允许开发者直接利用GPU的强大计算能力,而不必深入了解底层的复杂机制。这种易于访问和使用的特性,使得GPU成为AI研究和开发的首选硬件平台。总的来说,GPU在AI任务中的关键作用不仅仅是因为它们强大的并行处理能力,还因为它们对于AI领域至关重要的操作——如矩阵和向量运算——提供了优化和高效的执行。这使得GPU成为驱动当今AI革命的核心技术之一,无论是在科研界还是工业界,GPU都被广泛应用于加速AI的发展。需要指出的是,我们目前正处在整个计算产业变革的关键节点上,GPU技术的迅速发展和广泛应用不仅仅改变了硬件制造的面貌,也深刻影响了软件开发和云计算服务的格局,从而对整个计算产业生态造成了显著的影响。随着人工智能、深度学习、和大数据分析等领域的迅猛发展,对GPU的需求呈现出前所未有的增长趋势。这种需求的增长不仅推动了硬件制造商不断创新,以设计出更高效、更强大的GPU,同时也促使了新玩家的加入和投资的增加。这一切不仅促进了硬件技术的革新,也带动了整个半导体行业的发展,加速了计算能力的普及和应用的扩展。

传统的编程模型和工具往往无法充分利用GPU的并行计算能力,这就促使了新的编程模型和工具的出现。例如,英伟达的CUDA编程平台就是专门为GPU设计的,此外,深度学习框架如TensorFlow和PyTorch也提供了对GPU加速的支持,使得开发者能够更容易地构建和训练复杂的机器学习模型。

这种针对GPU优化的编程工具和框架的发展,不仅降低了开发门槛,使得更多的研究者和开发者能够利用GPU进行科学研究和应用开发,还推动了编程范式的变革。现在,开发者在设计软件时,更加注重软件能够充分利用硬件资源,尤其是GPU的并行处理能力,从而实现更高效的数据处理和计算。随着GPU加速计算能力的增强,云服务提供商纷纷将GPU集成到其服务中,提供GPU加速的云计算服务。这使得即使是没有高性能计算硬件的小型企业和个人开发者,也能通过云服务获得必要的计算资源,进行复杂的数据分析和机器学习任务。GPU加速的云服务不仅降低了AI项目的门槛,还提高了计算的灵活性和可扩展性,使得计算资源可以根据需求快速调整。此外,GPU加速云服务的兴起还促进了新型业务模式的发展,如AI分析平台、在线深度学习训练平台等,这些服务让用户能够更加灵活和经济高效地利用GPU资源,推动了AI技术的普及和应用。

综上所述,GPU技术对计算产业生态的影响深远且全面。它不仅推动了硬件制造的创新,也催生了新的软件开发模式和编程工具,更重要的是,它通过云计算服务,使得高性能计算资源变得更加普及和可获取,为AI技术的发展提供了强大的动力和广阔的应用空间