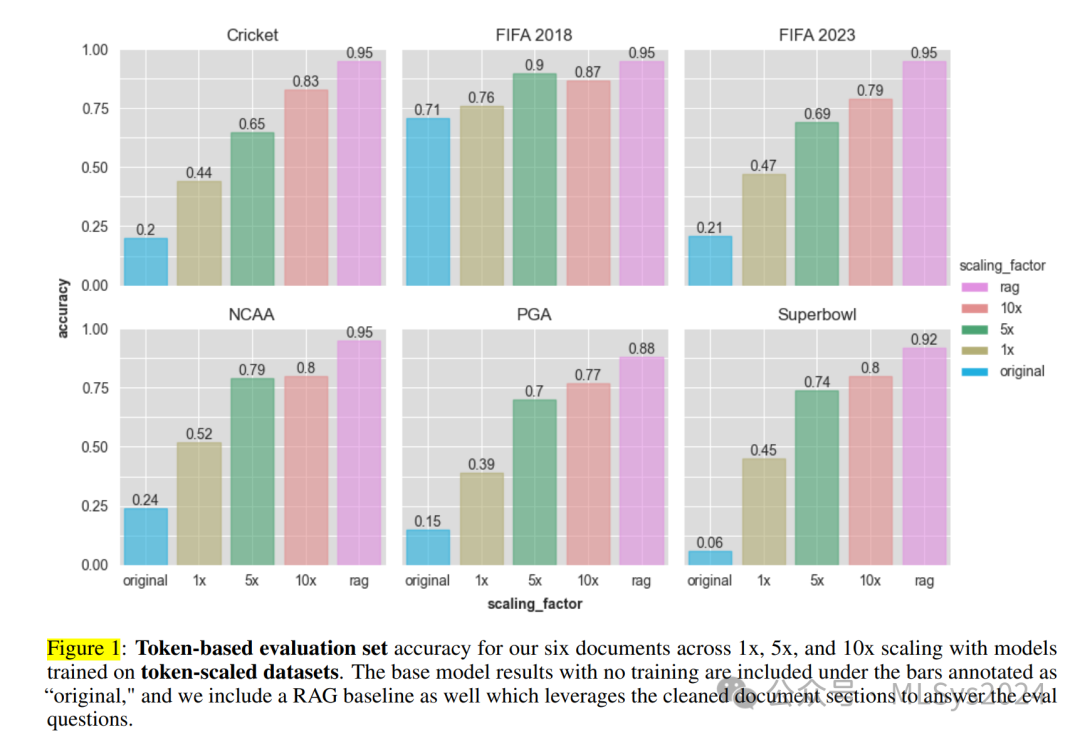

近年来,大型语言模型(LLMs)在生成类人文本方面展现了卓越性能,成为众多应用领域中的宝贵资源。然而,将这些模型调整为能够融入新领域知识,特别是模型知识截止日期之后出现的事实和事件,仍是一项挑战。本文研究了监督微调(SFT)作为LLMs知识注入方法的有效性,特别聚焦于近期体育赛事领域。我们比较了不同的数据集生成策略——基于词元的扩展和基于事实的扩展,以创建训练数据,帮助模型学习新知识。在GPT-4(OpenAI, 2023)上的实验表明,虽然基于词元的扩展可以提升问答准确性,但可能无法全面覆盖新知识。相比之下,基于事实的扩展提供了一种更系统的方法,确保所有事实都能得到均衡覆盖。我们提出了一种新颖的数据集生成流程,通过SFT实现了更有效的知识吸收,实验结果显示,在涉及领域外知识的问答任务中,性能得到了显著提升。本研究有助于理解LLMs的领域适应性,并强调了SFT在提升LLMs在特定知识领域回答事实性问题方面的潜力。1 引言

近年来,随着生成式人工智能的爆发式增长,越来越多的应用场景开始倾向于采用大型语言模型(LLM)来实现其功能。通常,LLM应用开发者面临的核心问题是如何最佳地将特定模型适配于其下游任务;这往往涉及在少样本学习、提示工程、检索增强生成(RAG)(Lewis等人,2020)、监督微调(SFT)、基于人类反馈的强化学习变体(RLHF)(Schulman等人,2017;Bai等人,2022)或这些技术的某种组合(Balaguer等人,2024)之间做出选择。本文的出发点在于认识到,尽管预训练的大型语言模型具备令人印象深刻的能力,但它们本质上受到训练数据范围和时效性的限制。作为LLM预训练基础的互联网规模语料库,本质上是有限的知识快照,既在时间上有局限,又在知识覆盖面上存在不足。这一局限性对于需要最新信息或模型训练截止日期后产生或超出训练语料库范围的专业领域知识的应用而言,构成了重大障碍。此外,人类知识的动态性和不断演变进一步加剧了这一挑战,因为新事件不断发生,而特定领域则产生了专有或小众的内容,这些内容并非公开可访问。因此,开发者若想在需要当前或专业知识的场景中部署LLM,必须制定有效的领域适应策略,将新知识有效融入模型中。尽管RAG(Lewis等人,2020)通过引入外部知识库来增强模型响应,提供了一种巧妙的解决方案,但这种方法绕开了将新知识直接同化到模型本身这一核心问题。

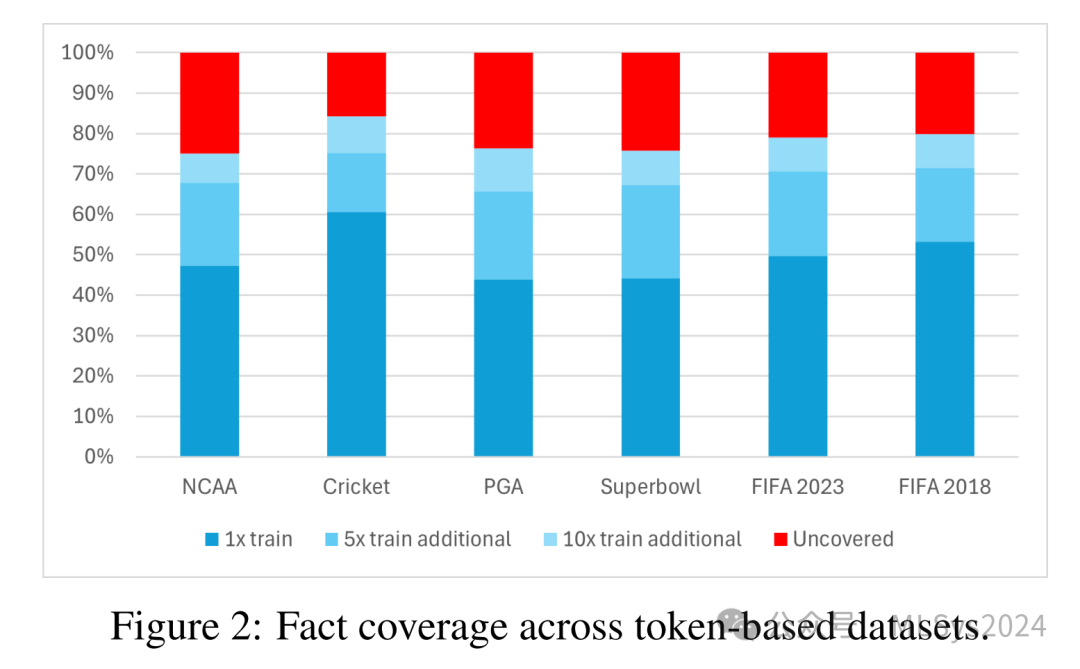

因此,我们迫切需要探索其他方法,使大型语言模型能够通过直接的训练干预来内化和保留新信息。这正是我们研究的核心所在:如何从一系列文档中构建一个训练数据集,以便通过简单的监督微调(SFT)技术来学习新知识?解决这一问题不仅具有理论意义,而且对于在现实世界环境中部署大型语言模型,尤其是那些对准确性、时效性和领域特异性要求极高的场景,具有重大的实际意义。我们通过对直接训练中知识吸收领域的研究,取得了以下几项显著贡献:- 我们全面评估了基于令牌的Q&A数据集生成的常规做法。研究发现,这种方法可能无法确保文档集合中新知识的全面或均匀覆盖。这一观察至关重要,因为它揭示了当前数据集准备策略的潜在局限性,并强调了采用更针对性方法纳入知识的必要性。

- 基于事实的生成过程开发:针对上述不足,我们提出了一种基于事实的生成过程。该方法优先考虑在源文件中的所有显著事实之间均匀分配注意力,确保训练数据中每条信息都得到充分表示。这种方法将显著提高模型从特定领域语料库中内化多样化和详细知识的能力。

- SFT对新知识学习的实证验证:我们证明,即使采用简单的监督微调,也能在处理跨领域、训练截止期后的知识时显著提升模型性能。我们的结果不仅验证了所提出的基于事实的生成过程的有效性,还为监督微调作为大型语言模型领域适应工具的实用性提供了有力证据。这一贡献对于在需要紧跟最新信息的动态领域中应用生成式AI具有深远影响。

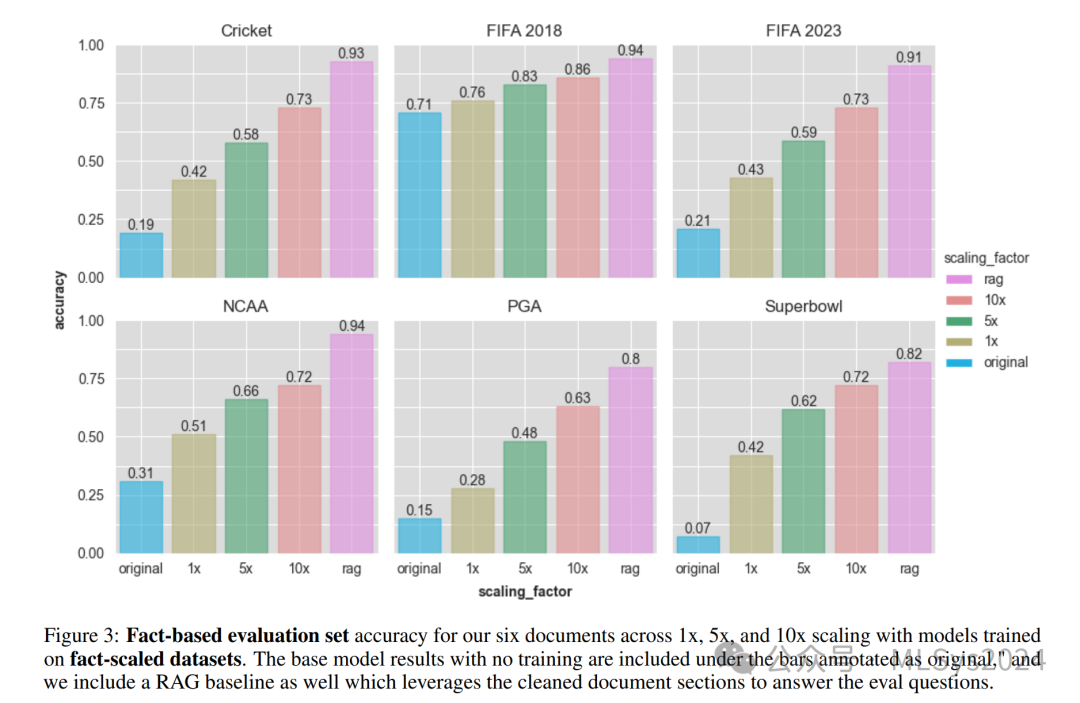

- 与检索增强模型的基准测试:我们将研究扩展到包括我们的SFT模型与采用RAG的模型之间的基准比较。此分析揭示了直接训练与基于检索的增强之间的权衡和相对优势,为从业者在选择和实施知识吸收方法时提供了宝贵指导。

- 认识到超参数调整通常是模型训练中一个微妙且影响重大的方面,我们深入研究了模型对几个超参数设置的敏感性。这一探索揭示了我们的研究发现的稳健性,并为未来针对知识吸收任务的优化策略研究工作奠定了基础。

在此,我们不仅展示了研究贡献的广泛性,还阐述了它们对人工智能和大型语言模型应用开发领域的潜在影响。通过这样做,我们旨在让读者全面了解我们研究的影响及其与学术探索和实际应用的相关性。2 相关工作

在语言模型的后训练自适应领域,特别是关注事实性方面,已有诸多相关研究。其中一项重要工作是知识注入研究,其目标同样是向语言模型系统中编码新知识(Wang等人,2020;Chen等人,2022)。过去流行的知识注入方法可能涉及使用外部知识库进行检索或增强(Fan等人,2020;Song等人,2016);这些知识库不必是现代RAG系统中常用的向量数据库(Lewis等人,2020),而可以是知识图谱等其他构建方式(Martino等人,2023)。另一种常见的知识注入方法是通过使用模型适配器,如Lauscher等人(2020)的研究所示,在训练过程中仅保留用于编码领域自适应的适配器参数不被冻结,以减轻灾难性遗忘问题。灾难性遗忘,即模型在学习新任务时倾向于自由覆盖之前任务所学结构的现象(McCloskey和Cohen,1989),对我们的目标尤为重要。避免这种遗忘部分地推动了外部增强技术的复杂性或部分冻结的适配器训练方法。然而,这并不意味着完全避免直接训练的方法。Xu等人(2023)尝试使用知识填充目标进行持续预训练,以增强事实保留能力。Tian等人(2023)则利用直接偏好优化的约束优化(Rafailov等人,2023)来鼓励后训练过程中的事实性。我们特别关注Ovadia等人(2024)的研究,他们利用对截断后的维基百科文章片段进行多次改写后的无监督训练,来教授模型新知识。他们通过精心设计的重复来提高微调性能的方法与本研究中的选择相契合,尽管我们在监督学习与无监督学习的技术上有所不同,他们选择无监督学习来有效进行知识注入的持续预训练。此外,Ovadia等人(2024)并未考虑他们旨在学习的底层语料库的事实密度,这更接近于我们在第3节中概述的基于令牌的扩展方法。我们选定了六篇维基百科文章,其中五篇是关于近期体育锦标赛的——包括2023年板球世界杯(Wikipedia contributors, 2024b)、2023年美国橄榄球超级碗(Wikipedia contributors, 2024d)、2023年国际足联女子世界杯(Wikipedia contributors, 2024c)、2023年美国职业高尔夫球协会锦标赛(Wikipedia contributors, 2024a)和2023年美国全国大学体育协会男子篮球一级联赛锦标赛(Wikipedia contributors, 2024e)——这些文章均属于截止时间之后的内容,另有一篇是关于截止时间之前的体育赛事,即2018年国际足联世界杯(Wikipedia contributors, 2024f)。选择体育赛事是因为它们富含事实和统计数据,易于理解,且相关信息在截止前后的界定上大多是非黑即白的。对于每篇文档,我们使用启用了explaintext功能的文本提取API来获取每个部分的纯文本内容,并以JSON格式返回。我们过滤并清理了这些部分,移除了任何空白部分或没有实质性纯文本贡献的部分(如除了少量注释外完全基于表格的部分)。对于每篇清理后的文档,我们生成了两种类型的数据集:基于令牌的扩展和基于事实的扩展。我们致力于通过不同问题覆盖相同内容的方式来扩展问答数据集——而不是简单地在相同数据上进行更多步骤的训练——因为增加的示例将使模型以更多方式看到所包含的目标知识。这种多样化的重复提高了学习的有效性,同时尽可能减轻了过拟合,后者否则会导致显著的性能下降(Ovadia等人,2024)。我们不希望模型仅仅记住源文档的措辞,而是希望它记住文档中包含的知识。3.1 基于令牌的扩展

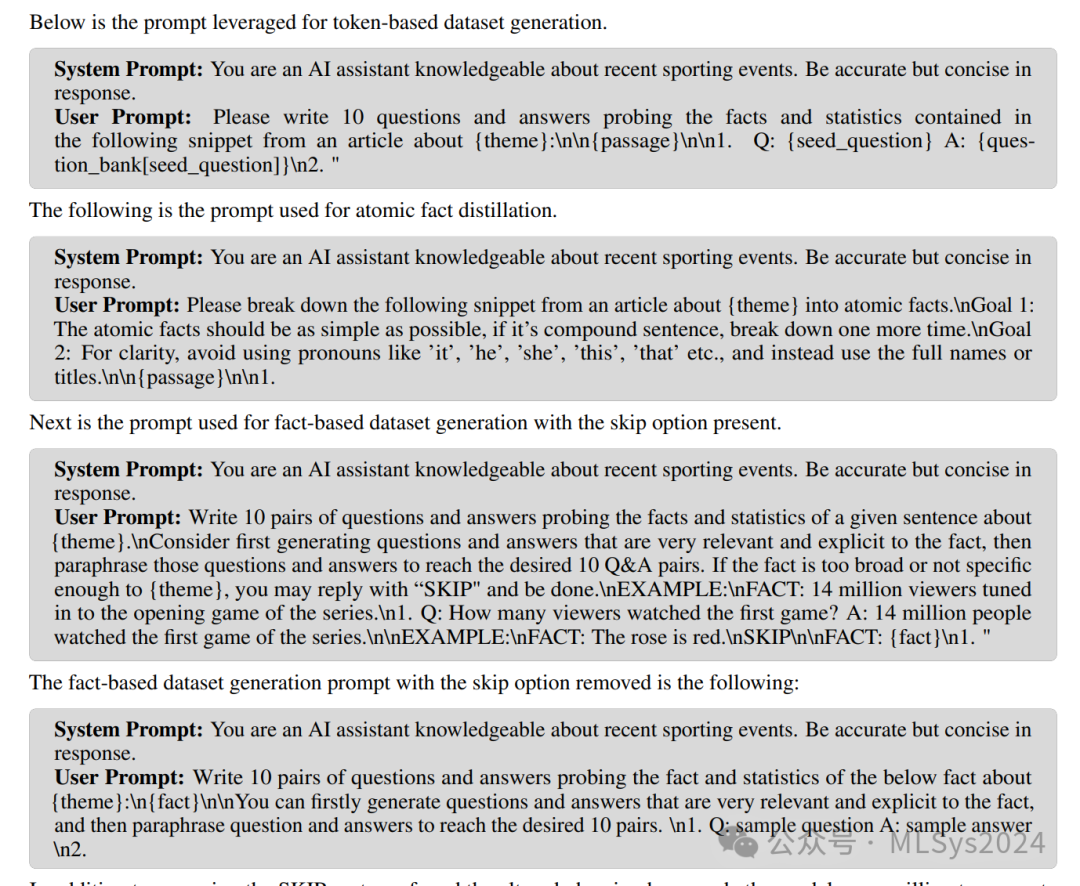

- 初始化一个空的问题库,并基于文章的概述部分手动编写一对问答作为种子。

- 对于文档中的每个部分,使用OpenAI的tiktoken库计算其令牌数。以1的温度和top_p=0.95(本节中所有数据集生成任务均使用此设置)反复查询基础GPT-4,生成问答对,直到该部分独特问答对的生成令牌数超过源部分令牌的10倍。

- 我们能够从10倍生成的数据集中选取子集来创建每个部分的1倍和5倍数据集。所有问题从精确匹配的角度来看都是唯一的。

- 1倍、5倍和10倍的微调数据集是通过将各自扩展因子的每部分数据集合并而成的。

- 每个文档的评估集也是按照相同的程序生成的,但仅限于1倍令牌规模。同样确保所有问题都是唯一的,并且不包含在训练集中。

3.2 基于事实的扩展

对于基于事实的扩展,我们首先需要生成文档中包含的原子事实列表。这通过向GPT-4查询之前清理过的文档部分来完成。然后,对于每个文档:- 我们遍历原子事实,并通过查询GPT-4生成10个独特的问答对。

- 只有当问答对在问题库中尚不存在时才会被接受,以避免重复,否则将生成新的一对。

- 从这个10倍集合中,我们创建了1倍和5倍的扩展子集。

在基于事实的数据集生成提示中,我们给GPT-4一个选项,如果事实过于宽泛、不清晰或与文档主题不相关,则可以跳过问答对的生成。我们手动检查了模型选择遵循此选项的少数情况。如果这些原子事实确实与主题无关,则会被过滤掉;如果保留,则移除“跳过”提示选项并重新生成问答对。一个GPT-4选择跳过的事实示例是“俄罗斯是一个在与纳粹主义的斗争中损失了数百万生命的国家”,这是在俄罗斯举办的2018年国际足联世界杯文章中被提及的。原文中的一句话提到了这一点,但模型(正确地)认为这与体育赛事太过不具体,因此没有包含在内。另一个例子是,对于美式足球超级碗LVII的文章,GPT-4跳过了“2022年2月,超过200名自由派宗教领袖向NFL专员罗杰·古德尔请愿”这一事实,尽管它看似与主题关系不大,但确实涉及了一些要求更改超级碗LVII举办地的呼声。我们仍然为这一事实生成了问答对。基于事实的评估集是在接受的原子事实集上,使用不带跳过选项的提示生成的,经过精确匹配标准的去重处理,并保持在1倍规模。

对于所有扩展因子的基于令牌和事实的数据集,我们采用了相同的训练设置。在微调过程中,我们选择了GPT-4 – v0613模型,其截止日期为2021年9月(msf, 2024a)。我们的SFT(Soft Fine-Tuning)过程参数高效,采用了lora技术(Hu et al., 2021),设置秩为16,批量大小为1,迭代次数为3。上下文长度足够大,能够容纳我们所有的训练示例。梯度更新仅针对辅助令牌进行反向传播,而不针对我们基于其进行条件设置的用户提示令牌。请注意,我们没有全面遍历所有超参数配置,因此这里选择的配置并非最优。我们特别发现,在学习率和迭代次数参数方面仍有改进空间,因为我们观察到了一些欠拟合的迹象。5 实验结果

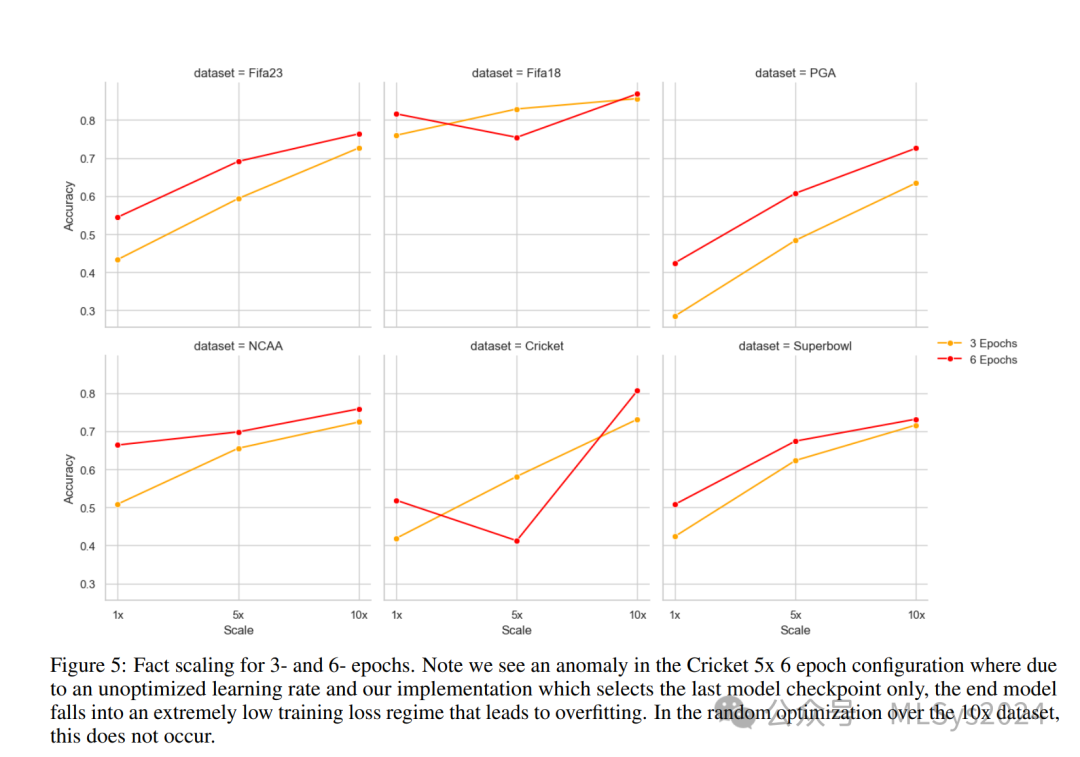

本研究在探讨SFT和知识注入时,采用了相同类型的数据集——关于体育赛事的维基百科文章。未来的研究可以通过纳入来自不同领域的多样化文本语料库来增强我们发现的稳健性。这不仅能验证我们方法的普适性,还能提高模型在更广泛知识领域中的适应性。在评估知识保留的有效性时,我们主要关注了体育相关内容中答案的正确性。然而,重要的是要考虑模型在更广泛主题上的表现,特别是在可能跨越多个领域的现实对话场景中。未来的研究应探讨新知识获取的权衡,尤其是对新知识的获取可能对模型在先前学习概念上的熟练度产生的潜在影响。我们对超参数调整和欠拟合可能性的初步探索取得了令人鼓舞的结果,观察到在增加训练轮次后,性能有了显著提升。我们尝试将轮次从3加倍到6,并再次在事实数据集上进行训练,结果如图5所示。在一些情况下,如PGA在10倍数据集时,或在NCAA在1倍数据集时,我们的评估集得分显著提高了高达10%或15%的绝对值。那么,我们所看到的扩展增益是否仅仅是因为更大的数据集等同于更长的训练时间,从而产生与延长训练轮次相同的效果?为此,我们比较了5倍数据集6轮次的结果与10倍数据集3轮次的结果,它们在训练成本上大致相等,但在扩展上有所不同。在所有六个数据集中,10倍数据集3轮次的配置均优于5倍数据集6轮次的配置,尽管在某些数据集中这一优势仅为3-5%。因此,我们的一些增益可能仅仅归因于更长的训练时间,但一致的超常表现让我们相信,通过不同问题进行的扩展也有其益处。尽管如此,数据集扩展、训练时长和学习效率之间的关系仍值得进一步探索。未来的研究应旨在明确数据集扩展与延长训练周期的具体贡献,同时考虑增加轮次可能带来的过拟合风险。

此外,尽管我们生成训练和评估数据集的方法是一致的,但可能并未完全涵盖现实应用中遇到的语言使用的多样性。我们的训练和评估数据集是根据相同程序生成的,并来自同一分布。未来的研究可以受益于开发更能准确反映人类查询多面性特征的数据集,涵盖各种语言风格和结构。最后,由于事实密度和令牌计数的可变性,使用令牌扩展与事实扩展数据集训练的模型之间的直接比较存在一定复杂性。令牌扩展没有固定的事实覆盖率,因为GPT-4的Q&A分布存在偏差;而事实扩展没有固定的令牌计数,因为每篇文档中的事实数量可能不同,并且我们需要足够的令牌预算来覆盖所有事实。因此,我们观察到事实扩展数据集的令牌计数大于令牌扩展数据集的等价物,例如1倍事实训练集的令牌数大约是1倍令牌训练集的两倍。尽管如此,我们仍然支持基于事实的方法,因为前面讨论过的覆盖范围保证。表1列出了每个基于事实的训练数据集的令牌乘数。为了解决这个问题,未来的工作可以致力于标准化一个维度——无论是令牌还是事实——以便于更清晰地进行比较,并就每种方法的相对优势得出更明确的结论。