✨ 1: Artificial Analysis

AI语言模型和API提供商的比较分析,帮助用户选择最佳方案。

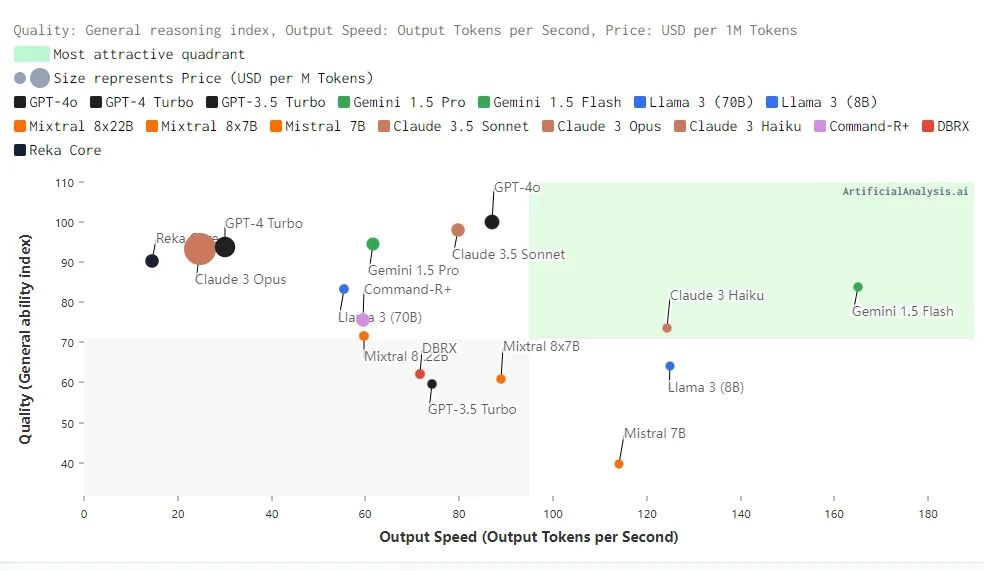

Artificial Analysis 是一个专门独立分析AI语言模型和API提供商的平台,旨在帮助用户了解AI领域并选择最适合其需求的模型和API提供商。以下是该平台的主要内容和功能:

模型与API提供商分析:比较不同的AI模型与API提供商,涵盖质量、速度和价格等指标

质量和速度分析:质量指数(越高越好)、输出速度(每秒生成的Token数量,越高越好)和价格(每百万Token的价格,越低越好)是主要的考核指标。

API提供商的具体分析:针对特定模型(如Llama 3 Instruct 70B)的输出速度与价格进行详细分析。

参与调查和报告:用户可以参与AI构建者调查,并收到结果报告,这有助于更好地了解市场趋势和最佳实践。

地址:https://artificialanalysis.ai/

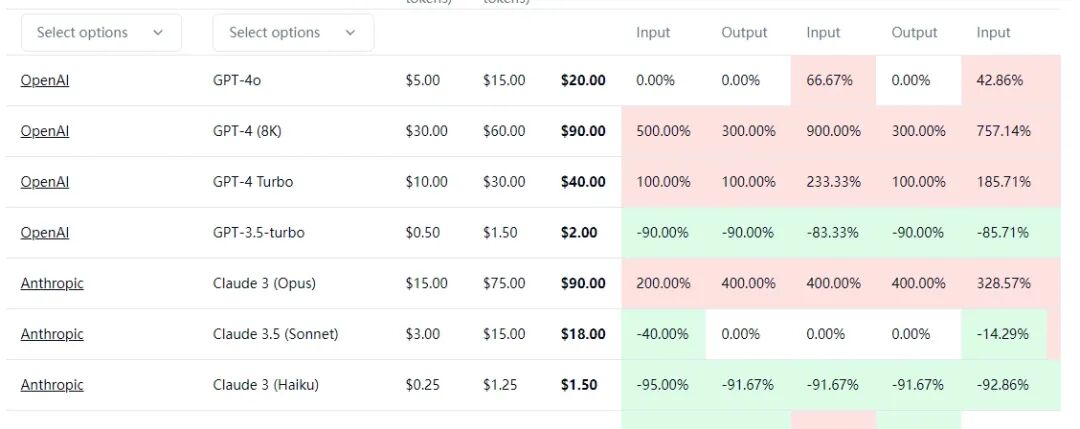

✨ 2: llm-pricing

抱抱脸LLM价格对比

抱抱脸各种LLM价格对比,方便开发者进行选择。

地址:https://huggingface.co/spaces/philschmid/llm-pricing

✨ 3: MinerU

MinerU 是一个开源的高质量数据提取工具,支持多种文件格式。

MinerU 是一个一站式、开源的高质量数据提取工具,主要包括以下两个核心功能模块:

Magic-PDF

Magic-Doc

MinerU 提供了强大的 PDF 和网页数据提取功能,能够显著提升文档处理效率,适用于多种数据提取和知识管理场景。

地址:https://github.com/opendatalab/MinerU

✨ 4: ai-renamer

AI重命名助手

Node.js CLI 工具,它使用 Ollama 模型(Llama、Gemma、Phi 等)智能地重命名指定目录中的文件。

地址:https://github.com/ozgrozer/ai-renamer

✨ 5: ttt-lm-pytorch

ttt-lm-pytorch 是一种带有表达性隐藏状态的RNN序列模型,用于测试时训练。

ttt-lm-pytorch 是一个基于 PyTorch 的模型实现,来源于论文 《Learning to (Learn at Test Time): RNNs with Expressive Hidden States》。该模型提出了一种新的序列建模层,称为测试时间训练层(Test-Time Training (TTT) layers),旨在解决自注意力机制在处理长上下文时导致的计算复杂度问题。

长上下文与复杂性:自注意力(Self-attention)在处理长上下文时效果显著,但其复杂度为二次方。

隐藏状态的表达能力:现有的RNN层复杂度为线性,但其在长上下文中的性能受到隐藏状态表达能力的限制。

TTT 层:该模型创新性地将隐藏状态设计为一个机器学习模型,更新规则为一个自监督学习步骤,即在测试时对隐藏状态进行训练。

地址:https://github.com/test-time-training/ttt-lm-pytorch

这就是本期的内容,记得标星⭐️点赞 ,关注我不迷路哦~

,关注我不迷路哦~

,关注我不迷路哦~

,关注我不迷路哦~