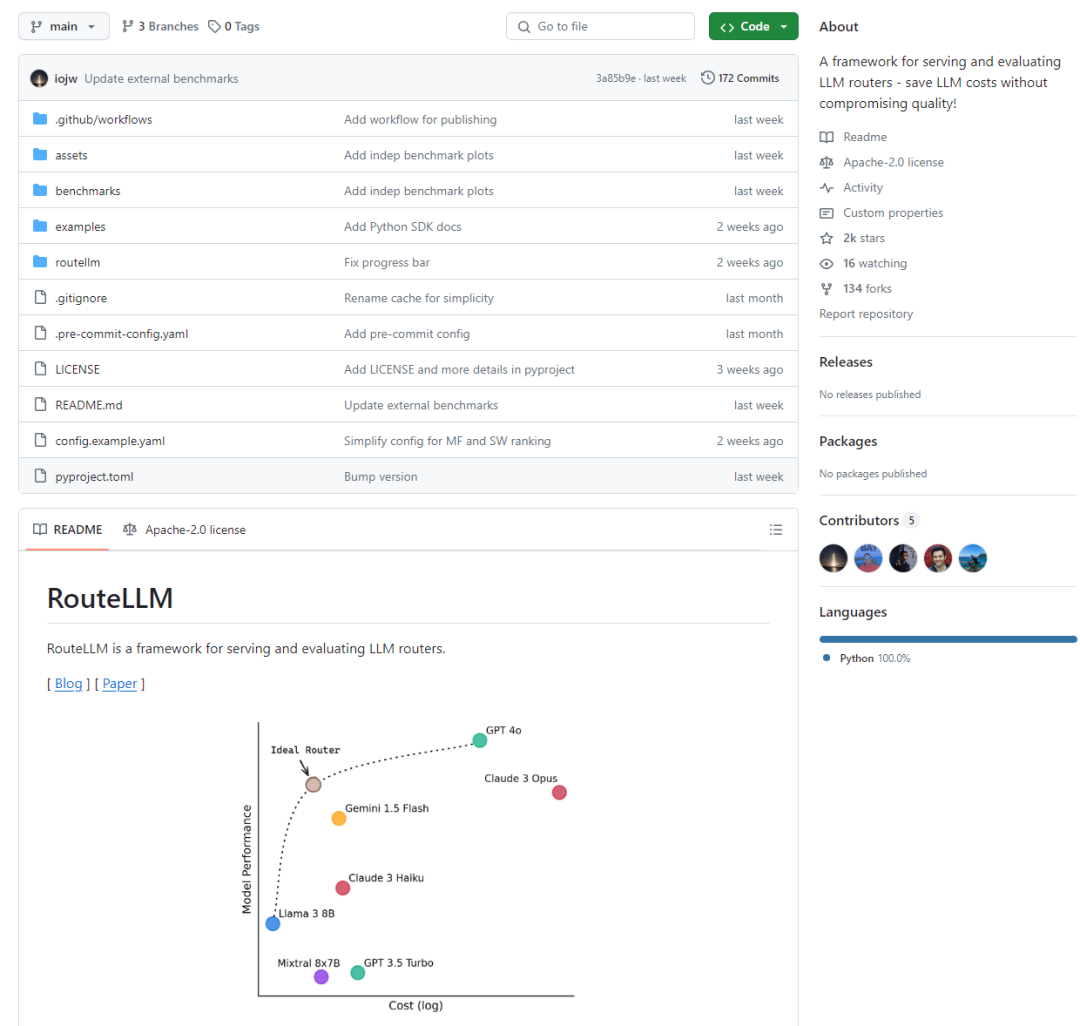

大型语言模型(LLMs)在多种任务中展现出了卓越的能力,但它们在成本和功能上存在显著差异,这一点从图1中性能与成本的对比图中可见一斑。一般来说,功能更强的模型往往比功能较弱的模型成本更高。这在实际部署LLMs时引发了一个难题:将所有查询路由到最大、功能最强的模型可以获得最高质量的响应,但可能会产生较高的成本;而将查询路由到较小的模型虽然可以节省成本,但可能会导致响应质量降低。

大型语言模型(LLM)路由提供了一种解决方案,该方案通过一个系统首先处理每个查询,然后决定将其路由到哪个LLM。理想情况下,所有能够由功能较弱的模型处理的查询都应被路由到这些模型,而其他所有查询则应被路由到功能更强的模型,以此在保持响应质量的同时最小化成本。然而,这实际上是一个挑战性问题,因为路由系统在路由时需要推断进入查询的特性和不同模型的能力。为了解决这个问题,提出了RouteLLM,这是一种基于偏好数据的LLM路由的有原则框架。形式化了LLM路由问题,并探索了增强技术以提高路由器的性能。使用Chatbot Arena的公共数据训练了四种不同的路由器,并证明它们可以在不降低质量的情况下显著降低成本,在MT Bench上成本降低了85%以上,在MMLU上降低了45%,在GSM8K上降低了35%,相比仅使用GPT-4,同时仍达到GPT-4性能的95%。1. 作为OpenAI客户端的即插即用替代品(或启动一个与OpenAI兼容的服务器),将简单查询路由到成本更低的模型。2. 提供开箱即用的经过训练的路由器,这些路由器在广泛使用的基准测试如MT Bench上显示出在降低成本高达85%的同时,保持了95%的GPT-4性能。3. 基准测试还表明,这些路由器在性能上与商业产品相当,同时成本降低了超过40%。4. 轻松扩展框架以包含新的路由器,并在多个基准测试中比较路由器的性能。pip install "routellm[serve,eval]"

git clone https://github.com/lm-sys/RouteLLM.git

cd RouteLLM

pip install -e .[serve,eval]

参考:

1.https://github.com/lm-sys/RouteLLM?tab=readme-ov-file

2.https://arxiv.org/pdf/2406.18665