在上篇Q1的观察主要从与 RAG,Workflow,Money相关的三个问题开始

整个Q2针对 AI+效率工具的思考依然是三个大方向- UGC内容库成为了AIGC?的燃料,传统的Template会进阶到新的Draft

- RAG层的数据异质性处理逐渐前置,?还有什么是会逐渐前置到模型侧?

- 分销模式?,针对“健身房”式的AI产品商业模式会是一个不错的选择。

防止<Garbage in, Garbage out>,高质量的UGC内容库成为了AIGC的基础。

GIGO的现象再一次说明了输入对于输出的重要性。如果从大多数用户的角度来看,我输入的只可能是需求or目标任务,在卷了“灵感市集”这种 Prompt 库未见到明显的成效之后。在输入侧,高质量的 UGC 库作为需求相关的上下文内容,精准搜索到并带入到 Input 中成为了新的方向。内容生产链条上的各个环节,无论是起点处的内容库,还是首要过程的搜索,以及下游的编辑器甚至是发布平台都开始发力。二季度中,输出时同时有 UGC 内容的现象也逐渐普遍,无论是腾讯的元宝的输出附有公众号内容备受好评,百度文库的橙篇借助文库内容积攒生成中长篇文章的精准定位,还是秘塔搜索在生成文章时直接借助知网的内容,高质量的 UGC 的内容成为了 AIGC 的基础保障。对比有无 GenAI 的内容创作 Workflow,很清晰的可以看出AI能够发力的三个环节,Idea诞生前的脑暴,从 Idea 到 Draft 的全过程(价值最高),整个修改的过程。去年此刻,我们惊艳于 AI 能够生成具备特定模板格式且表达清晰流畅的草稿,彼时还停留在模板的阶段,只是这个模板的相关性有所提高。但对于最终产出内容的整个工作流来看,势必会回归到最终的目标上内容,这也符合用户会为效果买单的逻辑。国内数据源封闭性的特点也使得不同的厂商手中的 UGC 内容各不相同,在模型能力差异不那么明显的情况下,UGC 内容对输出结果的影响十分巨大。某种程度上不同的内容就决定了 GenAI 工具的目标用户,比较明显的是以百度文库 or 知网数据为 UGC 内容源头的产品,注定了目标客群的教育标签十分明显。那么回过头来看,办公软件的UGC内容到底是什么?表面上看就是各种各样的文档。但是,仔细拆解则是<人,事务,消息(即时消息,长时效信息,讨论中产生的碎片化信息),以及三者沉淀出来的图谱关系网络>。因此,对于办公软件厂商来说在高效使用UGC内容的过程中一定绕不开的三个点:- 过去:对于这些信息的存储和索引做的是否足够好,多种内容是单独与账号关联但不同种类彼此分离还是通过网络能够连接起来的

- 今天:能否快速将这些UGC内容转化为LLM友好的信息格式以便于在不同任务中使用

- 未来:在多种信息中如何高效地消除噪音,同时能够将信息维度的增加对应到生成的信息质量上升

当然链接到外部的高质量内容库也是一个拓宽场景和目标客群的必要选择,否则则会出现在第三方软件生成好 Draft 再将内容复制到传统编辑器中,仅仅是 Modify 的过程中因为不想跳出工作流而简单使用 AI 润色,改写等和内容微调的局部功能。随着模型的降价,AI 生成内容的整体成本也在骤降,必然会有更多的AIGC内容诞生并融入到UGC的内容库中。如何甄别AIGC和UGC内容,以及防止低质量的AIGC污染UGC,我认为未来一段时间会是一个值得投入的方向。

在微软宣布 GPTs 下线后的十天内,Claude 发布的 Artifacts 大受好评。

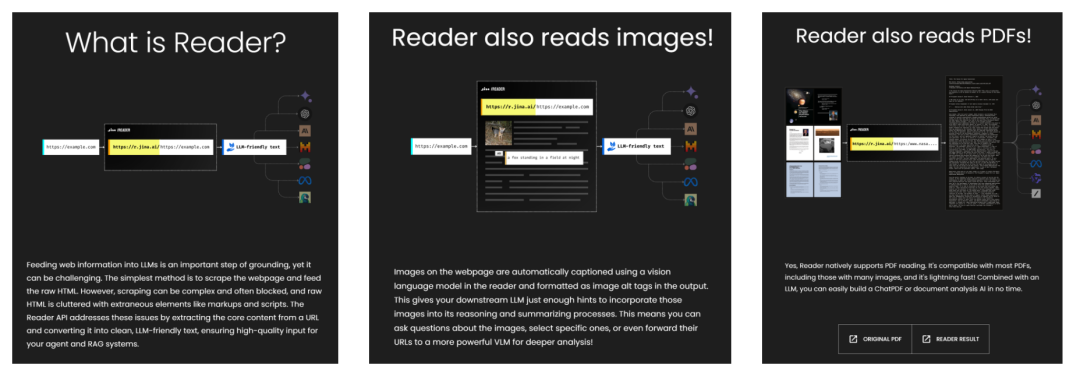

在Q1的思考中,RAG的核心之一数据异质性处理,我认为是办公软件厂商得天独厚的优势。因为这些格式的识别,兼容性的处理是过去办公软件厂商重要的技术能力积淀。今天来看,无论是模型厂商还是RAG方案提供商也都瞄准了这一部分的问题,期望在数据处理得好(LLM Friendly)方面建立起自己的优势。当模型厂商逐渐补齐数据格式的兼容和处理能力,叠加一个兼具“结果呈现”和“协作”(人与AI与人)的画布,办公的入口很可能会跟随着前移到模型侧。此前提到过 PDF 保证了文件内容和样式的一致性,往往成为了“定稿格式”或“流通格式”。在其中包含的元素种类较多(文本,表格,图片,图表等)处理起来也是十分麻烦。Jina Reader 作为一个信息爬取及处理的工具,在网页信息处理,图片信息处理之后,儿童节的当天发布PDF信息处理的新 Feature,能够快速将 PDF 内容转化为 LLM 友好的 Markdown 格式信息,快速搭建 ChatPDF 类的工具。

同一天 Llama_Index 团队发布了RAG over Excel 的Llama Prase的新功能,针对一张Excel表直接进行数据 QA,根据 NVIDIA 过去五个季度的收入数据构建的一张“单 Sheet 包含多 Table ”的较复杂样张,针对这个样张的七个问题全部回答正确。我拿着相同的数据源通过上传文件和上传图片两种方式分别对GPT4o进行了测试,直接传文件(acc:1/7 ),上传图片(acc: 4/7 )。可见复杂的表结构对于 LLM 来说依然是一个不小的挑战,模型多模态能力对于理解表格这种二维结构至关重要[1]。在 Claude 3.5 Sonnet 发布后我直接选择了上传表格图片的方式进行提问,理解歧义造成了一题答非所问,但是答案中的数据完全正确,进一步让它生成表格图片的 Markdown 格式,他发现了样张多 Table 的行标题一致,从而进行了多 Table 合并,化繁为简,形成了便于理解的宽表,结果十分惊艳。在模型视觉能力的加持下,对表格这种二维结构的理解又更进了一步。LLM 进入办公软件中最初的形态就是 Copilot,保留主要的作业画布区域,仅仅借助于右侧侧边栏的局部区域进行对话和发号施令,对于结果的 Double Check还是会回归到画布区域。今天 Claude 的 Artifacts 有着异曲同工之妙,左侧沉浸式对话,右侧的区域进行逻辑(代码)和结果展示。那么 Artifacts 对于模型来说真正的价值是什么呢?又会有怎样的未来空间?近期 Claude 又发布了 Project Knowledge 的 Feature(本质上就是某个 Project 的高质量 UGC 库叠加项目文档的管理空间),我认为这个 Feature 是对 Long Context 能力的利好,尤其在多文件交叉分析以及长文本打满后应该丢掉哪些内容的方向有所帮助,3月份和月之暗面的朋友聊天当时也提出过此需求,当时我的做法是让 LLM 自己构建一个list,以便于召回和交叉分析。