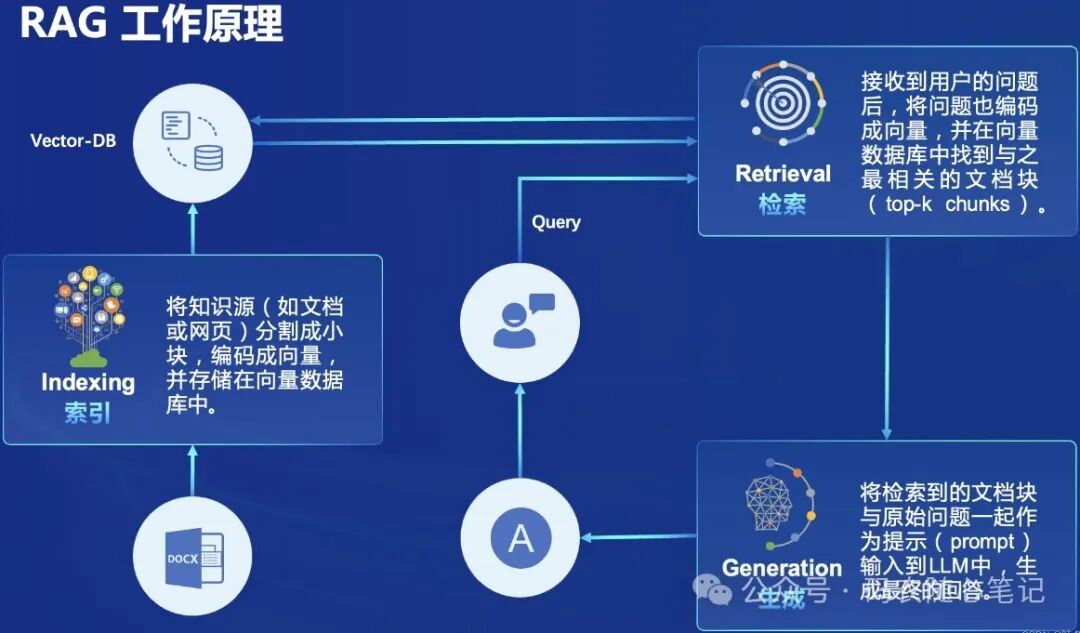

RAG,即"Retrieval-Augmented Generation",检索增强生成,是一种结合了信息检索(Retrieval)和文本生成(Generation)的机器学习模型。简单来说,RAG模型在处理问题时,会先在大量的数据中检索相关信息,然后利用这些信息生成答案或完成特定任务。

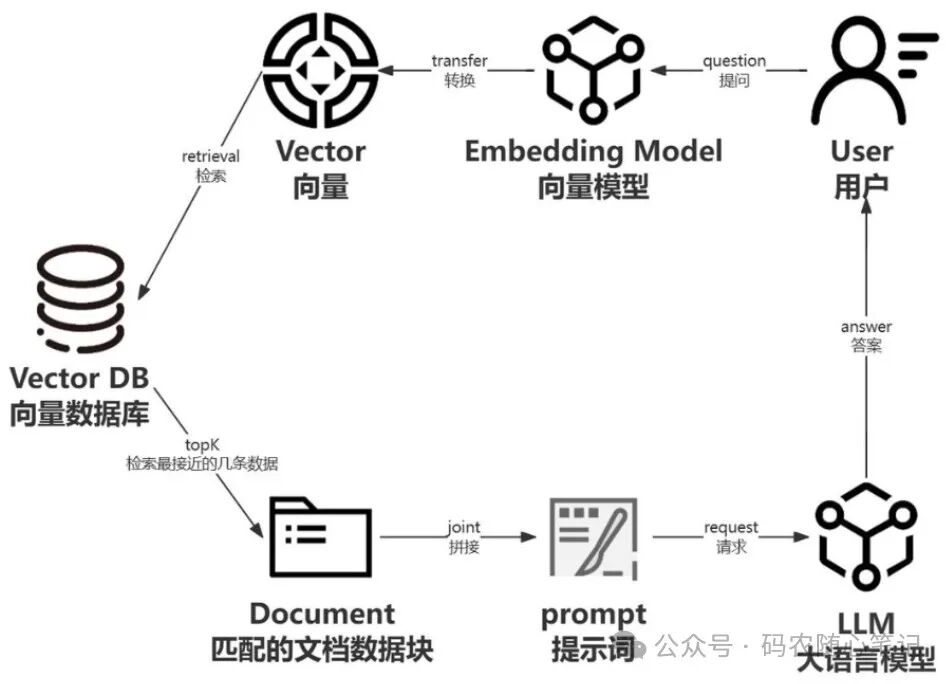

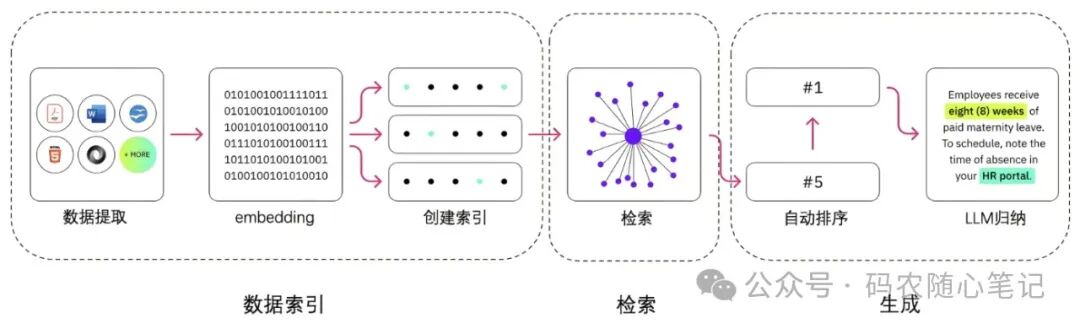

RAG 就是在大语言模型生成输出文本前,额外利用一些数据库或知识库,检索与输入问题相关的信息来辅助生成的过程。1. 首先,RAG模型会根据用户的输入问题,去检索相关的知识信息。这个知识信息可以来自于百科、论文、网页、自有数据库、知识库等各种知识源。

2. 然后,RAG模型会将这些检索到的知识和信息,与用户输入的信息一起,作为输入喂给生成模型。

3. 最后,生成模型会利用这些丰富的信息,生成出更加准确、相关、有深度的输出内容。

这样做的好处是使得生成模型可以获得更多的背景知识和上下文信息,从而生成出更加优质的内容。相比于单纯依靠训练数据,RAG模型能够提供更加丰富和准确的输出内容。

搭建一个高效的RAG系统,需要整合多项技术,共同赋能大语言模型,让其更好地获取、理解和利用知识。以下是应用到的关键技术及其作用解析:

1. 文本表示与嵌入 (Text Embedding & Representation):-作用: 将文本转换为向量空间表示,捕捉语义相似度,是RAG核心技术基础。-Transformer-based Embeddings: 模型如 SentenceTransformers, BERT, RoBERTa 训练出语义丰富的词向量和句子嵌入,能精准反映文本含义。- Fine-tuning: 针对特定领域或知识库,对预训练模型进行微调,提升嵌入质量与领域相关性。- 目的: 向量化让搜索变为高效的距离计算,而非单纯关键词匹配,实现语义搜索,找到真正相关的知识。2. 高效向量搜索与索引 (Vector Database & Search):- 作用: 快速检索与查询向量最相似的知识片段,犹如智能图书馆的索引系统。- 向量数据库 (Vector Database): 专门存储和查询向量数据的数据库,例如 Faiss, Milvus, Pinecone,支持快速近邻搜索算法。- 近邻搜索算法 (k-NN, HNSW等): 高效地从海量向量中找到与查询向量最相似的那些,缩短检索时间。- 目的: 面对庞大知识库,快速检索是关键,保证RAG系统响应速度和实用性。3. 上下文理解与融合 (Contextualization & Fusion):- 作用: 将检索到的知识片段与用户问题上下文深度融合,帮助LLM构建完整理解。- 注意力机制 (Attention): 让模型聚焦检索到的关键信息,赋予不同片段不同权重,突出与问题最相关的部分。- 文档摘要和抽取: 自动生成简洁的知识片段摘要,方便LLM快速 grasp 主要内容。- 知识图谱关联 (Optional): 利用预先构建的知识图谱,加深对知识关系的理解,构建更连贯的上下文。- 目的: 单纯拼凑信息不够,需要理解关联性,才能让LLM生成更有深度、更有针对性的回答。4. 响应生成与优化 (Response Generation & Refinement):- 作用: 大语言模型基于 enriched上下文生成最终答案,并进行优化。- LLM fine-tuning: 针对RAG任务训练LLM,使其擅长结合知识生成流畅、准确的回答。 - 模板和结构化输出: 引导LLM采用特定结构(问答式、列表式等)输出,增强可读性和信息组织。- 逻辑推理和事实验证 (增强版): 结合外部知识源进行验证,确保生成答案逻辑严谨、符合事实。- 目的: 生成阶段需要兼顾流畅性、准确性和知识融入,最终呈现给用户的答案质量至关重要。5. 持续学习与维护 (Continuous Learning & Updates):- 作用: 保持RAG系统时效性和适应性,应对不断更新的知识和用户需求。- 新数据迭代训练: 定期更新知识库,并使用新数据对RAG模型进行微调,提升模型精度和知识覆盖面。- 用户反馈机制: 收集用户交互和反馈,识别知识缺失或生成问题,引导模型改进。- 自动化知识图谱更新: 利用机器学习算法自动识别和更新知识图谱中的关联和变化,保持知识库的动态性。只有将这些技术有机结合,RAG 系统才能真正发挥出检索增强生成的优势,显著提高大模型的性能,为用户提供优质的内容生成服务。